随着人工智能尤其是大型语言模型(LLM)在软件开发领域的广泛应用,AI生成代码的现象变得司空见惯。虽然这一能力极大地提升了编码效率和创新速度,但在代码审查环节,许多开发者却对AI写的代码存在明显偏见,甚至于是无差别的否定和排拒。由于这种偏见,许多团队无法充分利用AI带来的优势,还导致审查者自身变得更糟,削弱了代码质量保障的效果。理解并反思这一趋势,已成为每一位现代软件工程师和代码评审者必须面对的重要课题。首先,需要认识的是,代码偏见的本质并非对代码质量的客观评判,而更多是源于对"AI生成"身份的固有负面印象。在开发者社区中,不少人将AI生成代码等同于粗糙、无脑、重复且缺乏灵活性的低劣作品,这种观点虽有一定现实基础,但却过度简单化。

AI模型确实存在诸多局限,容易生成废话注释、冗余逻辑、过时模式和混淆职责的代码结构,但这并不意味着所有AI代码都是劣质的。相反,谨慎且熟练地利用AI工具,结合人工的思考和调试,完全可以创造出结构清晰、功能合理、可维护性高的代码。正是这种黑白分明的刻板印象造成了编写或审查AI代码时的极大认知偏差。代码审查者因为"闻到了"AI生成的"气味",往往不自觉地降低了对代码本身的严谨度判断,甚至跳过细致的逻辑核查,只凭表象就做出草率结论。这种情形类似于"先入为主"的心理学效应,使得原本可能通过审查的优质代码反而被忽视或误判。另外,固有的担忧和不安全感也在推动偏见的形成。

优秀工程师通过持续积累经验掌握复杂系统设计,而AI工具能够在短时间内自动生成出大段代码,这种快速生成带来的认知威胁感会被误解为潜在的职业威胁。审查者潜意识中为了维护自己的专业权威和工作价值,容易将AI代码妖魔化,从而导致对AI生成内容的过度苛责。值得注意的是,偏见不仅影响了工作效率,还直接影响了团队的技术氛围和创新动力。当代码提交由于"AI嫌疑"被无理拒绝,会挫伤开发者创新和尝试新工具的积极性,进而影响整个项目的交付周期和质量迭代。与此同时,缺乏理性的代码审查使得真正的问题代码混入代码库,增加技术负债和后续维护难度。如何摆脱这种AI代码偏见,实现公平且有效的审查机制,成为业界亟待解决的问题。

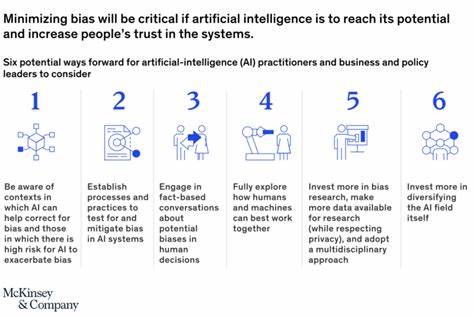

要做到这一点,首先必须改变对AI代码的基本认识。审查者应明确,AI代码本质上只是辅助工具的产物,其质量高低取决于提示的精准度、上下文理解以及后续的人工优化。通过合理利用AI进行多轮迭代、及时修正和性能测试,许多质量问题能够被轻松规避。其次,重新聚焦代码本身的质量和功能,而非其生成途径。无论代码由人类还是AI完成,同等的评判标准应适用。评审时应关注代码的可读性、模块职责是否清晰、代码是否符合团队规范、是否有充分的测试覆盖以及是否满足业务需求。

真正的专业评审重在发现潜在bug、架构缺陷以及技术债务,而非捕风捉影地识别AI指纹。另外,积极培养团队成员如何与AI工具协作的技能也至关重要。通过培训和实践,引导开发者学会有效地编写高质量提示,理解AI生成代码的典型模式,善用自动化检查手段,提升整体代码质量和开发效率。审查者自身也应承担起不断学习和适应新技术的责任,避免因固有思维掉队。最后,建立透明和包容的团队文化能够缓解不必要的焦虑。鼓励开发者公开讨论AI辅助开发的利弊和经验,消除误解和偏见,以理性的态度共同构建高效健康的技术生态。

团队领导应表态支持合理使用AI工具,避免把AI生成或辅助生成的代码当成禁忌,维护良好的合作环境。总的来说,AI在软件开发中的应用已经成为不可逆转的趋势。持续的偏见不仅使代码审查效果下降,还阻碍了技术进步。只有通过理性看待AI代码,做到"对码不对人",训练自己用同样的严苛而公平的标准审视每一行代码,我们才能真正发挥人工智能带来的巨大潜力。未来的代码审查不应是筛选"人类"与"机器"的战场,而应是激发协作与创新的舞台,让智能辅助成为提升软件质量和开发速度的强大助力。面对AI代码,放下偏执,读懂代码背后的逻辑与价值,是每一位代码审查者迈向专业成熟的必经之路。

。