在人工智能快速发展的时代背景下,衡量模型性能和技术进步的关键手段之一便是排行榜和基准测试。榜单不仅为研究人员和开发者提供参考,驱动技术迭代,也往往成为市场和公众关注的焦点。然而,随着排行榜在AI领域中的角色日益重要,有关其公正性与准确性的质疑也逐渐浮现,尤其是在大型语言模型等复杂系统的评价中表现尤为突出。最近发表的论文《排行榜幻象》(The Leaderboard Illusion)深入调查了知名AI竞赛平台Chatbot Arena所展现出的种种系统性问题,揭示了排行榜背后潜藏的评分偏差与评估不平衡现象,为我们理解当前AI竞赛生态提供了新的视角。排行榜作为衡量进步的重要工具,本应体现模型的真实水平和相对实力,但现实中出现的问题却严重影响了这一目标的达成。论文指出,部分AI模型供应商利用私下的多轮测试优势,秘密评估多个模型变体,择优披露成绩,甚至撤回不利分数。

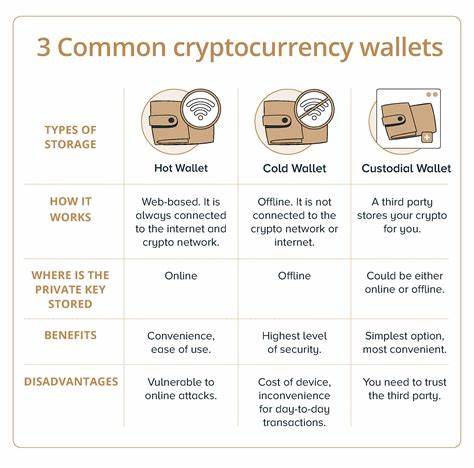

这种选择性展示(selective disclosure)导致最终排行榜上的分数带有明显的偏见,使得榜单排名不再真实反映各模型整体性能。尤其值得关注的是Meta公司在Llama-4发布前进行了至少27个私有模型的测试,这种密集的内部试验优化令其公开成绩显得更具竞争力。与之形成鲜明对比的是,开源模型和开放权重模型在排行榜中的样本曝光频率较低,被移除的比例较高,难以获得公平的竞技机会。这种数据分配和测试机会上的差异,导致了资源访问的不均衡,也使得排行榜成为小部分私有模型的优势战场。供应商如Google和OpenAI享有平均近20%的对战数据,而大量开源模型共用不到30%的数据份额,明显形成数据资源的二八分布。这种不对称不仅影响了比赛结果,也制约了整个社区在公平竞争环境中的成长和创新。

排行榜的数据访问对模型性能产生了显著提升效应,哪怕是有限额外的数据,就能带来在特定分布下超过百倍的相对性能提升。这暗示了模型在排行榜评测环境的过拟合风险,换言之,排名高的模型可能更多反映的是针对该竞赛环境的优化,而非普适意义上的真实实力。换句话说,排行榜上的龙头或许并非整体最优,在实际应用中其表现可能并不如竞赛成绩那样耀眼。这些现象催生了对排行榜评价体系改革的迫切呼声。为了塑造一个更加公平、透明、且反映实际模型质量的竞赛环境,论文提出了若干可行性建议。首先,公开所有测试数据和模型的全部成绩记录,避免私下多轮测试及择优披露行为,提升测试过程的透明度。

其次,平衡数据使用权和测试机会,确保尽可能多的模型无论开源与否均享有平等的上榜机会与数据访问权。第三,定期更新评测机制和指标,减少针对特定排行榜特征的过拟合,增强模型评价的泛化能力。学术界和产业界的合作也显得尤为重要,只有共同努力才能优化评测平台的运行机制,促进技术的正向迭代。排行榜幻象的揭露不仅使我们意识到当前AI竞赛环境中的隐性问题,也为整个AI领域的评估体系敲响了警钟。数据和测试机会的不均衡使得局部优势放大,导致某些模型凭借非技术性的因素获得不公平的领先地位。这种现象危害的不仅是技术发展本身,也削弱了人们对评测结果的信任度。

透明、公正的排行榜对于推动AI技术健康发展至关重要。科技企业应积极响应相关呼吁,致力于开放测试数据和流程,加强竞赛平台的社区治理与监督机制。同时,媒体和公众应保持理性,审视排行榜成绩背后的复杂因素,避免盲目崇拜单一榜单,从更广泛的角度理解和评估AI模型的实力和价值。未来,评测平台的演进需要实现三大目标:数据共享的最大化、公平竞争环境的保障以及指标体系的多元化。这样一来,排行榜才能真正成为推动AI进步的助力,而非误导和垄断技术视角的工具。总之,《排行榜幻象》所揭示的问题为整个AI竞技领域敲响警钟,也为构建未来更优质的评测体系指明方向。

只有正视和纠正榜单背后的偏差,营造平衡开放的生态环境,才能激发真正的技术创新,推动人工智能向更加公平、透明和高质量的未来迈进。