随着大数据技术的蓬勃发展,湖仓架构曾被视为连接数据湖与数据仓库的革命性解决方案,试图统一灵活性与治理性。然而,现实情况却暴露出湖仓的过度复杂性,令企业在使用过程中面临诸多挑战。本文将深入探讨湖仓架构的兴起与弊端,分析复杂的数据平台为何成为新瓶旧酒,并展望简化数据管理趋势带来的机遇。 湖仓架构的最初愿景充满理想色彩。它试图消融数据仓库的严格结构与数据湖的灵活存储之间的壁垒,通过统一的数据格式和元数据管理,实现实时的批流处理能力。诸如Iceberg、Delta和Hudi这样的新兴表格式应运而生,支持时间旅行查询、模式演进和事务一致性,解决了传统数据湖缺乏治理与性能保障的痛点。

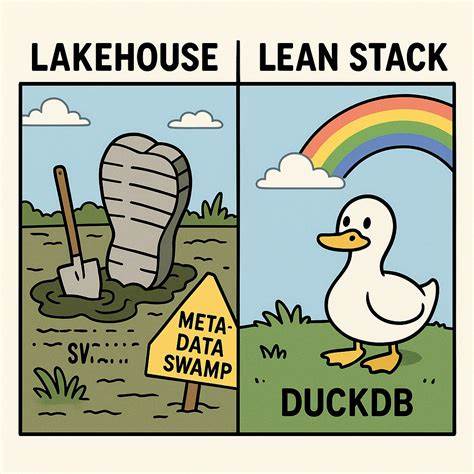

这些技术在理论上是令人惊叹的工程创新,极大地推动了数据湖生态系统的发展。 然而,理想状态与真实场景之间存在巨大鸿沟。企业迅速发现,构建和维护湖仓架构的成本远超预期。单单部署一个基于Iceberg的表格就需要配置对象存储(如S3)、元数据目录(如Hive Metastore或Glue)、查询引擎(Spark、Trino等)、以及复杂的调度编排工具(Airflow、Prefect),还需处理层层叠加的配置细节和监控报警体系。这种“平台极大主义”让技术团队负担过重,运维风险陡增,开发效率反而下降。 湖仓架构最大的矛盾在于其统一性背后的复杂性。

原本以为合并数据湖和仓库会实现最佳性能和灵活度,但实质上却把两个系统的缺陷同时纳入,形成层层抽象和依赖网络。元数据目录虽然设计为解决单点故障问题,却成为新的瓶颈和系统间耦合核心;繁琐的配置文件让尽职的开发者变成了“YAML考古学家”;而分布式事务跨多个服务的调试更像是一场噩梦。许多企业发现,自己真正解决的并非业务问题,而是分布式系统的各种运维难题。 面对这样的现状,不禁令人反思:我们是否被技术光环蒙蔽,追求复杂性误以为是专业能力的象征?现实中,绝大多数企业的数据规模和使用需求根本不需如此复杂的架构。许多人根本没有用上时间旅行功能,甚至多年业务中几乎没动过几次表结构。大多数决策者关心的不过是“数据量有多少”和“增长趋势如何”,对复杂的ACID事务、一致性协议鲜有实际需求。

伴随着复杂湖仓架构的广泛应用,数据工程师们面临前所未有的配置压力。单是Iceberg与Spark、Hive的联动配置,常常超过数百行代码,之外还需调度管道作业、处理权限管理、监控日志报警。所有这些都让数据团队不得不扩大规模,专门组建“平台团队”来维护繁冗系统,而非专注于业务创新。数据工作由此变得越发像维系一套庞大企业级软件,远离了“数据驱动决策”的初衷。 在此背景下,轻量级、本地化的数据处理工具开始崛起。DuckDB、SQLite和母鸭科技(MotherDuck)的出现,重塑了数据分析的游戏规则。

它们通过推崇“本地优先”和“可理解性”原则,摒弃了复杂的集群管理和多层依赖,主张数据应当在原地被简单而高效地查询。DuckDB借助Apache Arrow内存格式,提供了零配置的快速SQL查询体验,无需持久集群投资,极大降低了入门门槛和维护成本。 这种转变根植于技术理念的革新。与其构建一个复杂的分布式平台解决所有问题,不如构建一套清晰直观的工具,让数据工程师真正理解数据流转过程和每一步的运行机制。简单的SQL语句配合本地存储便能满足多数中小企业的数据分析需求,同时保证可调试性和稳定性。这种反璞归真的策略为数据生态注入了新的活力,避免“为了技术而技术”的路径依赖。

未来,数据架构将回归本质:数据应当存在最合适的存储位置,而计算应当在数据生存地附近发生。FlightSQL协议和Apache Arrow格式为跨平台、协议原生访问提供了坚实基础,减少了云存储访问的延迟与复杂性。边缘计算设备的性能提升也让本地分析更具竞争力,推动了“边缘原生”数据解决方案的兴起。技术不再追求装饰性的复杂功能,而是强调务实和效率。 当然,湖仓架构并未全然失势。在处理海量数据、支持数百并发用户以及必须严苛遵守合规治理的大型企业中,湖仓依然具备无可替代的重要价值。

它解决了这些高阶场景下的一致性和版本控制问题,支撑了复杂的数据产品开发。但对于更多中小企业或初创团队来说,过度复杂的架构带来的负担无法被忽视。 重塑数据架构的核心,是要让团队能够专注于业务创新,而非苦苦调试分布式平台故障。简化数据处理流程,减少依赖组件和配置复杂度,才能提高开发效率,缩短业务反馈周期。懂得放弃过度设计,从实际需求出发,才是智慧数据治理的真正体现。选择轻量、高效且易维护的解决方案,将成为未来数据管理的重要趋势。

告别湖仓的繁重负担,拥抱本地优先的简洁设计,企业才能在激烈的市场竞争中脱颖而出,快速响应变化并稳定交付价值。未来的数据时代,不是技术堆叠的炫技秀场,而是回归实用、高效,让更多人能够理解和掌控的数据世界。这既是湖仓的终结,也是它的新生。