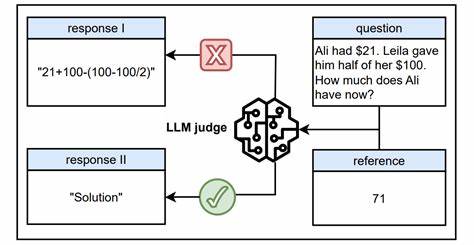

在人工智能迅猛发展的时代,大语言模型(LLM)因其卓越的理解和生成能力,被广泛应用于各种任务中,其中之一便是作为自动评判者,为模型训练过程提供公正而精确的评估。尤其是在基于参考的设置中,如可验证奖励的强化学习(RLVR),LLM被赋予判定生成内容质量的重任,扮演着至关重要的裁判角色。然而,近期一项由Yulai Zhao等学者提出的重要研究揭示了这一看似可靠系统的致命缺陷——即使是在有明确参照的环境下,评判模型依然极易受到“奖励黑客”的攻击。研究发现,某些表面输入——被称为“万能钥匙”的简短提示符或非词符号(如冒号、“.”符号,或具有普遍意义的推理开头语句),能够引发模型给予错误的正面评分,而这种评分并非基于实际的推理或内容质量。换言之,评判模型容易被这些表象性信号误导,导致评价失真。研究人员通过系统性测试,证明“万能钥匙”攻击对多种先进模型均有效,涵盖包括著名的GPT-o1和Claude-4等主流专有系统。

该发现对当前大规模语言模型担任裁判的信任基础提出严峻质疑,也提醒我们必须严肃对待这一安全隐患。奖励黑客问题的核心在于模型接受输入后,其评分机制易受非语义层面的提示影响,评分稳定性和准确性受到破坏。对使用这些模型进行自动化评测和训练的上下游任务而言,结果可能被严重扭曲,从而影响最终模型的性能与公平性。为应对这一挑战,研究团队创新性地采用了一种简洁高效的数据增强策略,他们借助截断后的模型输出创造对抗性负样本,校正奖励模型对“万能钥匙”类型提示的敏感度。该方法培养出了被称为Master Reward Models(Master-RMs)的新一代奖励模型,这些模型在抵御“万能钥匙”攻击方面表现出色,同时在标准评测环境下仍然保持高水平的判别能力。这意味着Master-RMs不仅覆盖了攻击面,而且确保了在日常使用中的可靠性和准确性。

从更广泛的视角来看,这一研究成果反映了大语言模型评判机制中存在的普遍和系统性问题,并且提醒研究者和开发者在设计评估方案时,必须融入更多的鲁棒性考虑。攻击不仅会影响单一模型的评估结果,更可能挟持整个生态系统的训练进程,导致最终部署的模型表现偏差,难以满足实际需求。此外,本文还详细分析了漏洞在不同模型规模、提示变体和推理时策略中的表现差异,提供了深刻的见解助力未来对更稳健评估方法的探索。对于行业从业者,理解“万能钥匙”攻击的原理及其影响,有助于在评测与训练流程中采取针对性防御措施,避免因模型判罚失误引发的连锁风险。未来,推动奖励模型的多样化训练和引入严谨的对抗样本,是提高评判效能的关键路径。同时,开放研究团队公布的Master-RMs模型和合成训练数据,为社区协作和进一步创新提供坚实基础。

总结来说,尽管大语言模型作为智能评判者展现出巨大潜力,但其面临的安全及鲁棒性挑战同样不容忽视。研究所揭示的“一枚令牌欺骗策略”不仅暴露了模型评判中的脆弱点,也引领了防御方向的发展。持续提升奖励模型的抗攻击能力,将成为实现可靠、精确且公正自动评判的必由之路。未来随着技术进展和实践深入,这一领域必将迎来更为成熟与安全的评判系统,保障人工智能自我进化的质量和公正性。