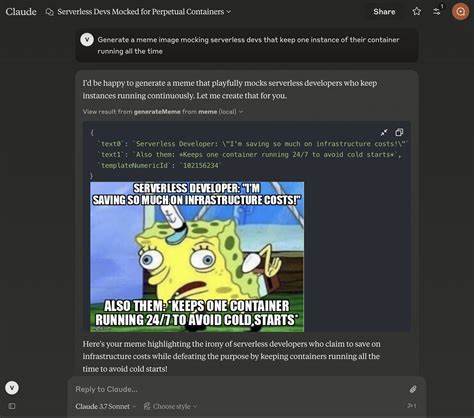

随着互联网技术的飞速发展,自动化机器人(Bot)在网络世界中的影响日益凸显。它们能够模拟人类行为,访问网站,执行各种任务。然而,当机器人行为失控,频繁请求服务器时,给网站带来的压力和风险不容忽视。近日,ClaudeBot向某些服务器发起了近百万次请求,在短短一天内形成猛烈的流量冲击,令许多站长和运维人员深感困扰。本文将深入分析ClaudeBot的特点,讨论这种高频请求对服务器的影响以及网站应采取的策略,帮助运营者有效应对类似挑战,确保网站的正常运行和用户体验。 ClaudeBot是一种自动化机器人,旨在高速抓取网页内容。

它的设计初衷是提供智能化数据采集和处理能力,但在实际应用中,若缺乏恰当的访问频率限制,就可能造成服务器资源过度消耗,甚至导致服务中断。一天近百万请求的量级,足以让大多数普通服务器陷入瘫痪状态,引发带宽拥堵、CPU占用飙升和响应延迟加剧等问题。 面对ClaudeBot的海量请求,网站管理员首要考虑的是如何识别这些异常流量。通常,访问日志会显示同一来源IP在短时间内发出大量请求,且请求行为缺乏正常用户浏览的随机性。此外,User-Agent标识也可能显示为ClaudeBot的特定字符串,这为自动检测和过滤提供了可能性。在识别到异常访问后,运维人员可以采取多重防护措施,确保服务器免受攻击而保持稳定。

首先,合理配置防火墙规则,对异常IP段进行封禁或限制访问频率,是最直接有效的方法。通过设置访问阈值,一旦请求次数超过预定标准,即可自动触发阻断,防止恶意请求持续侵占系统资源。同时,借助内容分发网络(CDN)和负载均衡技术,将流量分散到多个节点,减轻单一服务器负载压力,是提升抗压能力的重要手段。 其次,针对ClaudeBot的User-Agent特征,可以在服务器端或应用层面实现过滤和验证。禁止未通过授权或未注册的机器人访问,有助于减少无意义的请求浪费。此外,引入验证码机制,对于疑似机器人流量要求通过验证,确保真实用户不受影响,也是一种行之有效的策略。

此外,为防止数据抓取对网站内容带来不合理的消耗,采用robots.txt协议明确告诉搜索引擎和机器人哪些页面允许抓取,哪些页面禁止访问,形成规范的数据访问准则。不过需注意的是,robots.txt对恶意机器人并不具备强制约束力,只能起到一定的指引作用。 从技术层面看,加强服务器的性能与稳定性同样重要。提升硬件配置、优化数据库查询、合理设计缓存机制可以显著提升处理高并发请求的能力,减缓因流量暴增带来的性能瓶颈。同时,实时监控服务器运行状态和流量异常,及时调整防护策略,也是保障服务器安全与稳定的关键。 针对ClaudeBot近百万次请求的特殊情况,建议运营者及时联系机器人开发者,了解其使用目的与合法性。

若其请求行为并无合理限制,难以避免影响正常业务秩序,不妨通过官方渠道反馈,寻求友好协调,甚至争取对方在请求频率和范围上作出调整。同时,基于法律法规,必要时可采取法律手段维护服务器权益。 未来,随着人工智能和自动化技术的不断进步,机器人访问的规模和复杂度将持续提升。如何在利用机器人智能便利的同时,有效避免其带来的负面影响,成为网络安全和网站运营重要课题。部署智能流量分析系统,结合机器学习技术识别异常访问模式,动态调整防护策略,有望成为应对高频机器人请求的有力武器。 总的来说,ClaudeBot在一天内向服务器发起近百万请求,暴露出现代互联网生态中机器人带来的挑战。

通过精准识别、有效屏蔽、技术优化和沟通协作等多层面努力,网站运营者能够构筑坚固防线,保障服务器健康运行。只有提升整体防护意识和技术水平,才能在激烈的网络竞争中保持优势,确保用户体验与业务稳定共同发展。 。