在人工智能领域,大型语言模型因其强大的文本生成和语言理解能力而备受关注。它们能够通过海量数据训练,捕捉语言中的统计规律,表现出惊人的语言交互能力。然而,一项由哈佛大学和麻省理工学院联合开展的研究对这些模型是否真正具备内部世界模型能力提出了质疑。该研究揭示,尽管大型语言模型在完成训练任务时表现优异,但它们难以形成对世界物理规律和因果结构的深层理解,从而限制了模型在应对新任务时的适应性和泛化能力。该研究由Keyon Vafa、Peter G. Chang、Ashesh Rambachan和Sendhil Mullainathan等顶尖学者合作完成,论文题目为《What Has a Foundation Model Found? Using Inductive Bias to Probe for World Models》,并已提交至2025年国际机器学习大会(ICML),研究成果通过arXiv公开发布。研究通过设计一套创新性的“归纳偏差探测”技术,对基础模型在不同任务上的内在偏好进行分析。

研究人员构建了基于假设世界模型的合成数据集,特别关注经典物理学中的轨道运动和牛顿力学等领域,探究模型是否能借助训练得到的归纳偏差捕捉并应用物理定律。结果令人振奋也令人深思。虽然这些基础模型对训练数据序列的预测能力非常强,但当面对与训练任务相似度较低的物理问题时,模型并未表现出期望中的物理世界理解能力。它们更倾向于采取针对具体任务的启发式策略,而非基于真正的物理定律建立内在世界模型。这意味着模型缺少跨任务迁移的基础能力,难以借助先前习得的物理知识解决新问题。此发现对人工智能领域产生了深远影响。

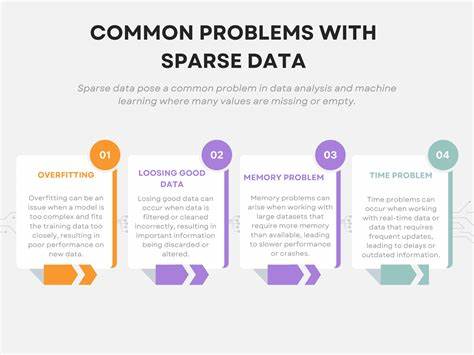

大型语言模型在自然语言处理、图像生成乃至科学发现等多领域均取得了突破,部分原因在于人们预期它们能够通过序列预测隐式构建关于现实世界的复杂模型。然而,研究表明这种预期存在偏差。模型的优秀表现并不等同于对因果关系和世界规律的深刻理解,这种浅层的模式匹配限制了模型在复杂推理和长期规划中的应用潜力。实际上,缺乏内在世界模型的现状导致这些系统在面对未见过的情境时容易出错,表现出过拟合训练数据的倾向,难以应对具有挑战性的推断任务。此研究提供了对基础模型能力的系统化评估方法,尤其是通过归纳偏差探测对模型的内在结构进行剖析。该方法不仅揭示了模型无法形成符合世界模型的归纳偏好,也为设计具备更强泛化能力的智能模型提供了方向。

研究人员建议未来模型应融入结构化的因果推理机制,增强对物理规律等内在结构的理解能力,从而提升任务迁移和抽象推理能力。除此之外,研究强调了数据与任务设计的重要性。当前的预训练模式主要依赖海量的自然语言数据,这些数据固然丰富,但并不足以引导模型形成完整的因果和物理世界模型。引入合成数据、强化学习和多模态信息等方式,可能是弥补此缺陷的有效途径。同时,研究结果对开放科学社区亦具有深远意义。作为开源论文及研究共享平台,arXiv一直促进全球学术交流,该研究在arXiv的公开发布,让更多研究者可以立足于此进一步探索基础模型的局限与突破路径。

面对快速发展的AI产业,理解这些模型的本质能力与边界,推动算法创新,才能真正实现智能系统的安全和可控发展。综合来看,哈佛与麻省理工的这项前沿研究为人们认识大型语言模型的能力提供了更为准确的视角,指出了当前基础模型尚未达到真正“理解”世界的层次。它不仅呼吁科学界重新审视模型设计思路,更推动我们思考如何构筑更精细、更具因果推理能力的人工智能系统。未来人工智能的发展将不仅依赖于数据规模和计算能力的提升,更依赖于模型深层次结构的革新,真正实现对环境的认知和自主推理。此研究无疑为人工智能领域的理论构建与实践应用奠定了坚实基础,也引导我们迈向更高水平的智能创新。随着技术不断进步,期待更多学者和行业人士关注内在世界模型的构建,共同推动AI走向更可靠、更智能的未来。

。