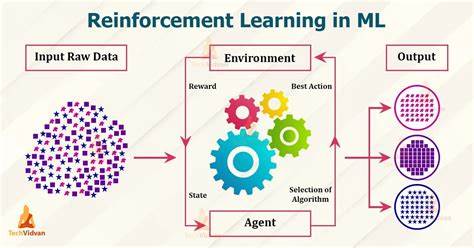

强化学习(Reinforcement Learning,RL)在过去十年里从理论研究逐步走向工程应用,围绕策略学习与决策优化的基本问题,诞生了许多既有理论深度又有实际价值的算法。到2023年,Q-learning、SARSA、DQN、DDPG、A2C、PPO与TRPO仍然是最常被引用与实践的代表性方法。理解它们的设计动机、适用场景和实现细节,是把强化学习模型成功部署到游戏、机器人、推荐或金融系统的前提。本文将以工程视角系统讲解这些算法的核心原理、实现要点、常见陷阱与调参建议,并介绍当前主流框架与2023年的研究与工程趋势,帮助你在实际项目中高效落地强化学习方案。\n\n首先从概念与分类出发帮助建立清晰的技术图谱。强化学习可以根据策略更新是否依赖于当前策略把算法分为on-policy与off-policy两大类。

Q-learning与DQN属于off-policy,它们通过估计动作价值函数来寻找最优策略,不直接依赖当前行为策略的采样分布。SARSA是on-policy的值函数方法,更新依赖于当前策略选择的下一个动作。基于策略搜索的方法有策略梯度与演员-评论家结构,DDPG、A2C、PPO与TRPO多为此类或其变体,适合连续动作空间或复杂高维策略表示。此外还有基于模型的方法和离线强化学习,近年来也在工程场景中获得越来越多关注。\n\nQ-learning是强化学习的经典基石,思想直观且实现简单。核心是维护一个状态-动作值表Q(s,a),通过贝尔曼最优方程进行迭代更新,更新规则为在当前样本奖励与下一个状态的最大Q值之间进行回归。

Q-learning天生适合离散且状态空间可索引的任务,其优点在于稳定性与易于实现。工程实现需要关注探索策略的设计(常见为ε-greedy)、学习率衰减、折扣因子设置与终止条件判断。在高维或连续状态下直接使用表格法无法扩展,此时引入函数近似器(如神经网络)可以衍生出深度Q网络(DQN)。DQN的关键工程创新是经验回放(replay buffer)与目标网络(target network)。经验回放通过打乱样本相关性提高训练稳定性并提升样本利用率;目标网络则定期同步参数以缓解训练时自举目标带来的不稳定。实现DQN时务必保证采样批次的多样性、目标网络更新频率与经验池大小的合理选择,同时处理好reward归一化与状态归一化问题。

对于高维像素输入,常配合卷积神经网络作为Q函数逼近器,并使用合理的epsilon退火策略来平衡探索与利用。\n\nSARSA相较于Q-learning的显著差异在于更新目标使用的是基于当前策略选择的下一动作值,因此更保守、对随机环境与策略噪声更鲁棒。SARSA在有较强策略依赖或需要在训练过程中保持安全性和约束时更合适。实现要点包括如何产生下一个动作(同样可采用ε-greedy或softmax策略)、如何管理策略随时间演变带来的数据分布变化。若与函数近似结合,注意避免估计偏差和方差的权衡,可能需要使用双重估计(double Q-learning)来减少过估计偏差。\n\n深度Q网络DQN自2015年在Atari上取得突破后,成为深度强化学习工程化的重要起点。

DQN的实际工程细节值得重点掌握。经验重放的容量、优先级经验回放(Prioritized Experience Replay)的采用与否、目标网络同步方式(硬更新与软更新)、梯度裁剪、最小二乘损失还是贝尔曼残差加权,都影响训练稳定性。另一项广泛采用的改进是双Q网络(Double DQN)减少最大化步骤的过估计。实现DQN用于工业环境时还需考虑训练数据采集的开销、样本效率、以及在真实环境中的安全探索策略,往往需要与仿真环境、域随机化和安全约束结合。\n\n策略梯度类方法直接对参数化策略进行优化,适合连续动作空间与高维策略表示。A2C是许多工程项目的首选轻量级演员-评论家实现,它采用同步多个环境并行收集样本以降低方差与提高样本效率。

A2C中评论家估计价值函数用于构建优势函数,优势函数能有效减小策略更新的方差。实现A2C时关注关键超参包括学习率、值函数与策略网络的架构、并行环境数量、GAE(广义优势估计)参数lambda以及归一化技巧。Actor与Critic共享网络或分开建模各有利弊,共享网络可以提高特征共享效率但可能使优化过程更加耦合。\n\nPPO是近年来工程界最受欢迎的策略优化方法之一。PPO通过在策略更新中引入裁剪或KL约束近似信赖域优化,兼顾简单实现与稳定性。PPO的核心思想是最大化剪切后的概率比乘以优势函数,以避免单次更新改变策略过多。

工程实现中PPO需要注意批量大小、优化轮数、裁剪系数(clip epsilon)、GAE参数、以及学习率调度。PPO通常在离线小批量更新的情形下表现良好,适合训练样本相对昂贵且需要稳定更新的任务。PPO在连续控制与策略迁移上有良好表现,也是许多基准强化学习库默认提供的强基线。\n\nDDPG是一种为连续动作空间设计的确定性策略梯度算法,它结合了演员-评论家结构与经验回放机制,通常使用高斯过程或Ornstein-Uhlenbeck噪声进行探索。DDPG的实现要点包括确定性策略的探索策略设计、目标网络的软更新、以及Replay Buffer的管理。由于DDPG为off-policy算法,它可以与经验重用和并行收集策略配合提升样本效率,但也更容易陷入局部最优或不稳定收敛。

工程上常用TD3(Twin Delayed DDPG)和SAC(Soft Actor-Critic)来替代或改进DDPG,因为它们通过双Q网络和熵正则化显著提升稳定性与性能。\n\nTRPO是早期的信赖域优化实现,通过约束每次策略更新的KL散度来保证策略变化不过大,理论上更能保证单步更新时性能不退化。但TRPO的工程实现复杂,涉及二阶梯度近似和共轭梯度求解,计算开销与实现难度相对较高。因而工程界更多倾向于使用PPO作为TRPO的替代方案。若问题强调策略安全性或需要严格约束更新幅度,TRPO仍然是重要的参考和基线。\n\n实现强化学习的工程细节不仅包括算法本身,还涵盖训练流程、评估标准与调试策略。

首先构建可靠的仿真或环境接口十分关键。建议统一使用Gym兼容环境或采用封装好的向量化环境以并行收集数据,这能显著提升样本效率与训练吞吐。对于真实世界任务,优先在仿真中训练并采用域随机化或Sim2Real技术来缩小现实差异。数据采集策略需要考虑探索安全性,危险动作应由规则约束或通过奖励惩罚设计抑制。\n\n模型训练时务必做好日志与度量体系。常见指标包括累计回报、滑动平均回报、方差、策略熵、Q值估计偏差、以及学习曲线稳定性。

可视化训练过程中的观察值与梯度范数能帮助快速定位崩溃或梯度消失问题。复现性是工程项目中常见痛点,保持随机种子固定、记录依赖的库与版本、以及保存训练检查点都能提高可复现性。使用混合精度训练或分布式训练可以在硬件受限的情况下提高训练效率,但要注意数值稳定性。\n\n关于调参与常见坑,学习率是最敏感的超参数之一。策略网络与价值网络常常使用不同的学习率,并辅以学习率退火策略。经验池大小影响遥远样本相关性与训练稳定性;过大可能占用过多内存,过小则降低多样性。

多步Bootstrap、优先经验回放、归一化奖励与状态、以及归一化Advantage的策略能显著改善收敛质量。探索噪声设计对连续动作任务至关重要,噪声的时间相关性、幅度随训练退火都需要实验验证。\n\n工具链与开源生态在2023年更加成熟。Stable-Baselines3提供了PyTorch实现的多种强化学习算法,文档齐全并支持PPO、A2C、DDPG、DQN等。RLlib则面向分布式训练和大规模工程化场景,适合需要并行采样与复杂调度的企业级项目。CleanRL以简洁实现著称,便于学习与快速原型验证。

Tianshou和Acme在中国与学术圈也越来越受欢迎,分别在可扩展性与模块化设计上表现良好。选择框架时应考虑团队熟悉的深度学习栈(PyTorch或TensorFlow)、是否需要分布式训练、以及是否注重便捷的可复现基线。\n\n2023年的研究与工程趋势表现为对样本效率、稳定性与可扩展性的更高要求。离线强化学习开始走入实际工程场景,允许从已有历史交互数据中训练策略而不必大量在线采样,这对需要在真实设备上避免危险探索的场景非常有吸引力。基于模型的方法也得到更多关注,通过学习环境模型来进行规划或合成训练数据以提升样本效率。安全性、可解释性与公平性在现实部署中同样受重视,因而在设计奖励函数、约束条件和评估指标时需要提前考虑伦理与风险控制。

强化学习与自监督学习、对比学习等方法的融合也成为提升表示学习质量与迁移能力的一条重要路径。\n\n在选择算法时应以任务特性为导向。离散动作与低维状态的任务,Q-learning或DQN通常是高效且易实现的起点。对策略稳定性与简易调参有要求的离散或连续任务,PPO提供了良好折衷。连续控制、高维动作空间或对样本效率敏感的任务可以考虑A2C、DDPG或其改进版本TD3与SAC。对策略变化需严格约束的安全场景,TRPO或基于TRPO思想的变体仍有价值。

离线数据充足但在线采样受限时,则优先考虑离线强化学习方法或结合行为克隆预训练策略。\n\n最后给出工程上可直接落地的若干建议以提高成功率。首先从简单基线开始,搭建可复现的训练流程并验证仿真环境与奖励设计是否合理。其次采用成熟开源库与已验证的超参配置来快速迭代,同时保持对关键模块如数据采集、归一化、目标网络更新频率的监控。第三重视模型评估与安全验证,在现实环境中逐步小步部署并使用限制策略或人类监控避免灾难性探索。第四记录与保存实验配置、随机种子和检查点,确保可以回溯与复现。

最后,与领域专家合作进行奖励与约束设计,避免代理找到不符合真实目标的捷径行为。\n\n总结来看,强化学习的算法谱系与实现技巧在2023年已极为成熟,从Q-learning与SARSA的价值估计方法到DQN的深度逼近,再到A2C、PPO与DDPG等面向策略优化的现代算法,每种方法都有明确的适用场景与工程折衷。把握核心原理、重视工程实现细节、善用开源工具并结合仿真与安全约束,是将强化学习成功应用于实际问题的关键路径。希望以上内容能为你在2023年的强化学习实践中提供清晰的指南与可操作的实现建议,让复杂的算法在真实系统中稳健高效地发挥作用。 。