在人工智能和自然语言处理领域,大型语言模型(LLMs)如ChatGPT、Claude和Cursor等正变得日益普及并引导着智能交互的未来。然而,当前许多AI工具在上下文记忆和信息连续性方面存在显著短板。用户常常需要在不同的AI平台之间重复输入背景信息,无法实现跨会话和跨工具的上下文连续,这不仅带来了极大的使用不便,也限制了人工智能发挥其最大潜力。CORE,一个全新的开源记忆图谱项目,正是为了解决这些痛点而诞生。它致力于打造一个统一、可共享且完全用户拥有的持久记忆层,让AI工具能够跨平台访问和调用同一套上下文数据,实现真正的知识连续性和智能延展。 传统的大型语言模型通常基于会话进行上下文理解,一旦会话结束,其记忆也会随之消失。

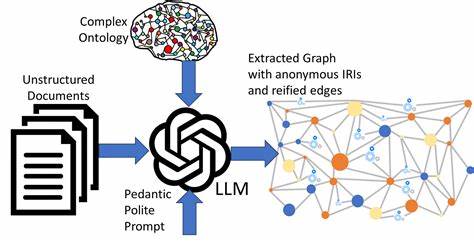

即便在同一个工具内部,由于模型的输入长度限制,历史上下文也难以被完整保存。这导致用户在不同场景下不得不重复介绍背景信息,浪费时间且影响体验。CORE以“统一记忆层”(Unified Memory Layer)的理念切入,利用先进的知识图谱技术,将用户的对话、偏好、任务上下文和参考资料等信息结构化储存,并将这些碎片化知识通过时间和因果关系进行关联,形成一个动态更新的记忆网络。 该项目使用了时序化及重构的知识图谱方法,不仅记录“什么事实”,还详细追踪“谁说了什么”、“什么时候说的”和“为什么这样说”的背景与来源,确保记忆的溯源性和多维度信息融合。这种设计避免了传统记忆层中的扁平化数据存储,使记忆内容如同活跃的故事般,能够被智能体真实理解并灵活调用。CORE的平台优势之一是其高度的兼容性和开放性,用户可以将记忆从Cursor迁移到Claude,再到ChatGPT,甚至通过扩展工具进入任何支持MCP协议的客户端,从而实现记忆的无缝流动。

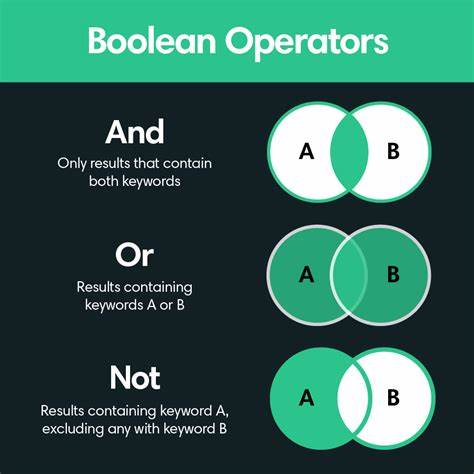

在具体应用上,CORE支持丰富的集成方式。无论是通过浏览器插件直接从网页内容或社交媒体提取信息,还是自动同步来自Linear、Slack、GitHub、Notion等协作工具的上下文数据,都极大拓展了记忆图谱的宽度和深度。用户不仅可以在任何连接了CORE记忆层的AI工具中询问“关于我的写作偏好是什么”,也可以让模型基于完整的历史做出更精准合理的推断与建议。 技术上,CORE构建了一套多阶段的知识摄取与存储流程,包括信息标准化、实体与关系提取、冲突检测与多视角保留以及图谱整合。这一流程确保从杂乱无章的原始输入中提炼高质量的结构化知识,并通过智能算法维护记忆的一致性和演化。对于搜索和回忆环节,系统采用关键词搜索、语义检索与图谱遍历相结合的方式,筛选和重排序结果,确保用户获得最相关且多元的答案,同时还能追踪知识的时间线和来源,保证开放性和透明度。

数据安全和隐私保护同样是CORE的重中之重。通过采用TLS1.3传输加密与AES-256静态加密,结合OAuth 2.0身份验证和基于角色的访问控制,用户数据在存储与传输中都获得了严密保护。此外,工作空间隔离策略防止不同用户的数据混淆,确保个体隐私权利尊重与数据安全。平台明确规定不存储敏感数据、凭据和系统日志,最大程度降低潜在风险。 CORE诞生于应对多工具、多会话分离记忆管理难题的需求,开源且活跃的社区则为项目不断注入创新动力和技术支持。它不仅为AI开发者提供了一种标准化、高效的记忆解决方案,更为普通用户带来跨工具无缝智能体验,降低操作复杂度,提升工作和创作效率。

展望未来,随着更多同步集成及AI模型技术的提升,类似CORE的统一记忆图谱层将逐渐成为智能交互的基础设施,推动AI个性化和长期协同变成现实。 归根结底,CORE代表了AI记忆管理的下一代趋势。它打破传统记忆的孤岛效应,构建能够随时间生长、可共享、并且归属于用户本人的智能记忆体系。这不只是技术的升级,更是AI与人类认知方式融合的里程碑。无论是科研型团队、企业用户还是普通个人,拥抱CORE都将开启更加智能、高效、连贯的人工智能交互新篇章。