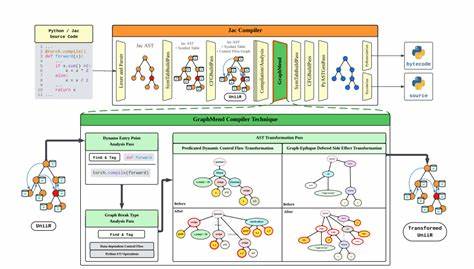

随着人工智能和深度学习技术的快速发展,PyTorch已成为研究人员和工程师们首选的深度学习框架之一。PyTorch 2引入了革命性的TorchDynamo和TorchInductor两大组件,旨在实现即时图编译(JIT),大幅提升模型执行效率。然而,尽管带来了诸多优势,PyTorch 2在动态控制流以及部分Python特性支持方面依然存在限制,此类局限导致模型执行过程中图的频繁中断,严重影响性能优化和计算效率。GraphMend的出现正是为了解决这一棘手问题。 GraphMend是一款构建在Jac编译框架上的高层代码转换编译器,专注于消除FX图断裂现象。FX图是PyTorch 2用于表示计算图的中间表达,图的完整性直接关联到优化能力和执行效率。

传统方法中,若代码中存在动态控制流或者调用了Python输入输出(I/O)函数,PyTorch的编译流水线会频繁产生图中断,迫使执行退回到Eager模式。这种往返切换不仅频繁触发耗时的CPU到GPU同步,还造成优化机会流失,阻碍了模型潜力的充分发挥。 GraphMend的核心优势在于其主动性和自动性。它通过对模型源码的静态分析及代码转换,重新编写存在潜在图断裂风险的代码结构,从根源上移除图断裂。其引入的两大代码转换机制针对动态控制流和Python I/O函数进行针对性处理,使得原先碎片化的模型代码被无缝整合进更大、更连续的FX计算图中。这意味着,PyTorch的JIT编译管道能够捕获更完整的计算图,显著提升图优化策略的应用深度和广度,无需开发者进行繁琐的手动代码重构。

在实际应用层面,GraphMend在基准测试和多个主流Hugging Face预训练模型中展现出卓越表现。通过其智能转换,6款模型的图断裂完全消除,另有1款模型断裂次数由5次降至2次,极大地提升了模型的流畅度和执行连续性。在硬件平台方面,NVIDIA RTX 3090与A40 GPU的实验结果显示,GraphMend可实现高达75%的延迟减少和8%的端到端吞吐量提升。这些数据印证了其在提升深度学习推理性能中的重要价值。 GraphMend的技术探索不仅解决了PyTorch 2当前的痛点,更为深度学习编译器的发展提供了一条新思路。通过在编译前的高层源码阶段介入并进行代码层次的智能转换,它拓宽了传统动态即时编译的边界,促进了静态与动态技术的深度融合。

此举不仅对PyTorch生态系统的完善有深远影响,也对业界其它主流框架的图优化策略提供了宝贵启示。 此外,GraphMend的设计理念强调降低开发门槛与提升用户体验。对于广大深度学习从业者来说,减少手动调整和适配的需求意味着可以更专注于模型创新和业务场景,实现科研与工程实践的高效衔接。结合其自动化和透明化的转换流程,GraphMend真正做到了让代码优化成为潜心攻关背后的无形助力。 总体来看,GraphMend是PyTorch 2图断裂修复领域的重要创新。它通过深入分析动态控制流和Python I/O特性,实施前置代码转换,成功打造了连续完整的FX图,为深度学习模型执行效率和效果提供了坚实保障。

随着深度学习应用场景的不断复杂化,图优化技术的需求日益迫切,GraphMend的技术贡献将进一步激励社区持续深化编译技术的研发,为人工智能时代的快速发展保驾护航。 对未来来说,GraphMend的思路和方法或将拓展至更多编程语言和框架,推动跨平台、跨任务的深度学习优化新生态的构建。同时,不断完善的代码转换策略及与硬件加速技术的结合,也必将为复杂模型的实时推理和训练带来更多惊喜。 综上所述,GraphMend作为一款创新的代码转换工具,凭借其解决PyTorch 2 FX图中断问题的能力,正在引领深度学习模型优化技术迈入新的发展阶段。它不仅提升了模型执行的性能和稳定性,也极大地改善了开发者的工作体验,展现了高层代码编译技术在人工智能领域的巨大潜力与广阔前景。 。