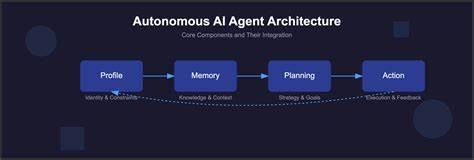

随着人工智能技术的迅猛发展,我们正迎来一场前所未有的信息革命。在众多行业和生活场景中,AI的应用正逐渐渗透并改变传统的工作方式和生活习惯。然而,令人警醒的是,当人们面对这类高度复杂且具备强大“拟人”特征的技术时,单凭自身判断而忽视潜在的心理陷阱和认知偏差,往往会埋下风险隐患。人类大脑虽拥有惊人的计算与推理能力,但研究表明,我们的认知机制却极易受外界影响而失准。心理学权威罗伯特·西奥迪尼在其经典著作《影响力》中揭示了众多操控思维的技巧,从销售诈骗到认知陷阱,无不说明了智慧并非人类自我防御的坚固屏障。尤其是当智能体通过自然语言生成充满逻辑与情感色彩的内容时,人们极易陷入“认知自动驾驶”模式,产生对信息本身的过度信任,即使这些“事实”可能存在误导甚至严重错误。

在软件开发领域,这种认知误区尤为突出。一方面,开发者往往拥有扎实的逻辑思维能力,对技术的掌控感极强,另一方面,正是这股自信促使他们低估AI生成代码可能带来的安全漏洞和逻辑缺陷。例如,一名云计算行业工程师通过给AI指令构建权限验证库,惊讶于AI代码质量“出乎意料”的可靠,然而,该项目缺乏多方验证和严格测试,所带来的安全隐患难以估量。此类案例揭示了一个重要教训:单凭自我实验、主观经验或少量实例,是无法形成有效科学结论的。软件开发这种高度复杂、易受偶然事件影响的领域,更需依赖严谨的对照实验、多实例验证和系统分析。而盲目基于个体经验去评判AI的能力,不啻为在认知陷阱中自我欺骗。

心理学上称之为“主观验证偏差”,即人们倾向于认定与自身情感和信念相符的信息为真,即便这种信息可能只是偶然巧合或无关事件的结合体。这种偏差在AI的应用场景下表现得尤为明显。设计精妙的语言模型能够产生符合用户预期的回答,强化用户对系统“理解力”的认知,进而产生更深层次的信任,这种信任若不加辨别,就变成了对自身理性判断的拦路虎。与此类似,人们曾因自我实验陷入伪医学领域,比如顺势疗法的实验,其效果往往混淆于心理暗示和自然康复过程之中。人工智能技术亦可能成为新形式的心理陷阱,诱导使用者轻信其功能而忽视潜在的局限性甚至危害。当前学界普遍同意,解决此类问题的根本路径是科学研究。

通过独立、开放且透明的实验室测试,才能真实揭示AI工具的优势和不足。这不仅包括代码质量和安全性的检验,更涵盖心理学层面的用户行为分析与认知偏差识别。惟有如此,我们才能从“轶事证据”转向具备统计学支撑的“科学证据”,有效降低盲目信任引发的风险。与此同时,人工智能领域尚未拥有完善的监管与评估机制,导致“AI泡沫”的现象日益严重。资本的狂热与行业内对于快速成功的迫切追求,使得多数相关产品和服务缺乏充分的安全保障与伦理考量。此时若用自我判断代替严谨的科学验证,无异于在风险丛生的环境中蹒跚前行,后果不堪设想。

软件开发界的分歧尤为显著。一派认为现有开发方法虽有缺陷,但整体稳定可靠,只需AI提速升级;另一派则坚持认为软件工程本身深陷系统性危机,AI工具反而可能加速弊端。两者基于不同世界观,难以调和。更糟糕的是,无论哪一派,都可能在无意识中落入认知并发的陷阱,放大了风险叠加的影响力。除了技术层面,社会与文化因素亦加剧了认知偏差的传播。信息生态中,“半懂”知识和模糊信念更容易广为流传。

这种“知识断章取义”带来的是一类认知流行病,做出非理性判断的可能性倍增。人们在面对人工智能时,更多依赖于对权威声音的信任,往往忽略了深入批判与独立思考的重要。要避免这种困境,教育和科普工作显得尤为关键。普通大众、技术从业者以及决策者均需具备医学、心理学和统计学的基本认知,培养对各种谬误和偏见的警觉。就算是技术精英,也要时刻保持谦逊,承认认知局限,避免陷入自恋式的盲信。只有构建成熟的理性认知框架,才能在时代变革中从容应对挑战。

综上所述,在人工智能日益普及的今天,单纯信赖自身判断不但无法有效评估和利用AI工具,更可能导致严重的认知错误和安全隐患。科技变革带来的机遇与挑战同在,我们需要以科学态度、防范意识和批判思维武装自己。把握认知上的盲区,避免落入心理陷阱,才能真正掌握人工智能的主动权,推动社会良性健康的发展。过度自信和轻率采用,只会加剧信息生态的混乱,甚至诱发不可逆的系统性失败。面对未来,让我们擦亮理智的眼睛,与科学和事实为伍,审慎而坚定地迈步前行。