在当今数字化浪潮的推动下,数据成为企业最重要的资产之一。伴随着业务的发展和数据需求的多样化,传统数据架构逐渐暴露出瓶颈,复杂繁多的数据管道、冗余数据存储、数据一致性难以保障以及数据更新滞后等问题层出不穷,极大限制了企业的数据驱动能力。Kafka和Iceberg作为两大开源标准的代表,正引领着数据基础设施进入一个全新的时代。通过打破操作与分析数据之间的壁垒,解决传统数据架构中的诸多难题,它们共同构建了一种低成本、高扩展性和实时响应的新型数据体系。传统的数据架构通常起步于满足单一业务需求,比如某零售企业可能最初使用MySQL数据库管理销售数据,随后为了更好地理解客户行为引入SaaS型CRM系统,再发展到云端数据仓库支持线上分析。随着各种团队陆续搭建自己的数据管道,数据孤岛问题日益严重。

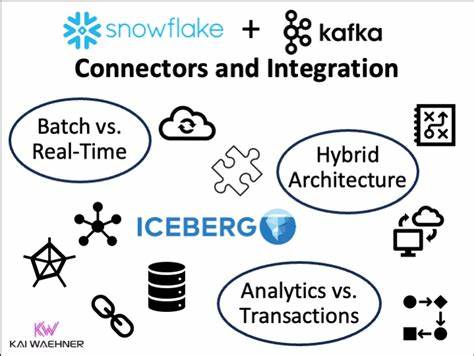

不同的系统间通过复杂、不稳定的管道交流数据,诸多ETL流程频繁失败,数据一致性难以保证,分析结果出现延迟,业务部门难以获得及时准确的洞察。与此同时,数据管理和运维成本攀升,因系统变更带来的影响难以预估,数据模式演进缓慢,业务迭代受到限制。Kafka作为一款高吞吐、分布式的流处理平台,擅长处理实时数据流,满足了企业对低延迟、高可靠性数据传输的强烈需求。它为操作系统和应用程序之间提供了稳定、统一的事件驱动数据总线,实现了数据在实时环境中的高效流动。另一方面,Iceberg作为面向大数据存储和分析的开源表格式标准,提供了灵活的数据分区、强大的数据版本控制和高效的查询性能,极好地支持了数据湖中海量数据的长期管理和复杂分析场景。传统上,实时流处理和批量分析常被视为两个独立的领域,分别由不同团队负责并使用不同的工具和架构。

这导致数据复制、延迟累积和模式不一致的问题难以避免。Kafka和Iceberg的结合为此提供了革命性的解决方案。通过将Kafka作为操作层(Speed Layer),Iceberg作为批处理层(Batch Layer),二者实现了数据的无缝衔接和统一管理,完美体现了Lambda架构的理想理念。更进一步的是,最新的技术和实现使得Speed Layer和Batch Layer均使用Iceberg表格式,极大简化了混合应用开发的复杂度。传统Lambda架构中,实时层和批处理层数据格式和访问模式的巨大差异导致应用开发和维护成本高昂,实时层常需处理出序和迟到数据等复杂问题,而批处理层关注数据的准确性和完整性。让二者统一成同一种表格式后,数据可以通过简单的SQL语句结合,构建一个完整且一致的视图,实现对实时流与历史数据的统一查询。

这种设计不仅降低了架构复杂度,还提升了系统的可维护性和扩展性。Kafka和Iceberg架构的另一个显著优势是极大降低了数据复制带来的存储成本和ETL维护工作。传统架构中,数据常常需要通过ETL过程从操作系统复制到分析系统,产生重复存储和延迟的问题。通过逻辑视图实现对Kafka中实时数据的查询,避免了数据的重复拷贝,实现了真正的Zero Copy架构,既保证了实时数据的新鲜度,又让数据始终保持一致。逻辑视图实际上是基于查询时动态计算结果的方式,能够保证访问到最新的数据,支持数据架构在业务变化和数据规模膨胀时的灵活演进。随着业务数据的增长,仍然需要将部分数据从Speed Layer迁移到Batch Layer以保证整体系统性能和资源利用率。

由于二者都使用Iceberg表格式,数据迁移成为简单的插入操作,支持无停机的平滑过渡。批处理层负责存储大部分历史数据,操作层主要保持新近数据的实时性,二者之间的平衡与自动化迁移机制确保系统的高效稳定。同时,这种架构也为企业实现单一数据可信来源提供了坚实基础,消除了数据孤岛和多版本困惑,使得业务团队、数据科学家和运维人员都能基于同一套数据进行分析和决策。面向未来,Kafka和Iceberg的结合不仅解决了现有复杂数据架构的顽疾,也为数据基础设施的可持续发展奠定了基础。它们能够适应不断变化的数据规模、业务模式和合规要求,同时支持多样化的数据访问和处理引擎,如Spark、Trino等,具备极强的生态兼容性和开放性。总之,Kafka与Iceberg将定义未来十年数据基础设施的演变方向。

它们联手打破了传统操作与分析数据之间的壁垒,打造了统一、实时且低成本的数据平台。借助这两大开源技术,企业能够更好地面对数据时代的挑战,实现数据驱动的业务创新与竞争优势。随着技术不断成熟和商业实践的深入,Kafka+Iceberg的架构方案必将成为现代数据体系的中流砥柱,引领整个行业迈向更加智能、高效和可持续的未来。 。