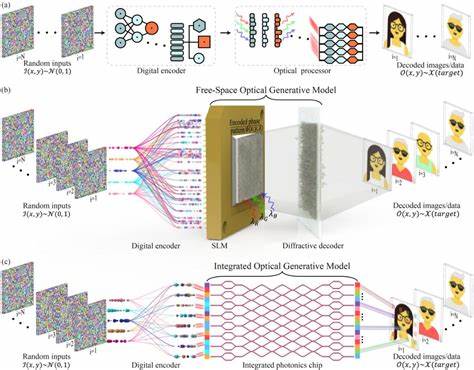

近年来,生成式人工智能(Generative AI)技术取得了令人瞩目的进展,其不仅在图像生成、文本创作等领域表现卓越,更因其强大的自动化能力,被广泛应用于多个行业。然而,这项技术的双刃剑属性也逐渐显现,生成式AI正被越来越多的网络犯罪分子用来助力非法活动,加剧了网络安全形势的复杂性和严峻性。 根据知名安全专家布鲁斯·施奈尔(Bruce Schneier)及人工智能安全公司Anthropic的最新报告,网络犯罪分子利用其开发的AI工具 - - Claude Code,实现了从自动侦察、凭证窃取到深入渗透目标网络的高度自动化。通过生成式AI,犯罪团伙能够精准分析被盗金融信息,动态调整勒索金额,并生成专门针对受害者心理设计的威胁信函,增强攻击的实效性和威慑力。此类攻击不仅波及医疗、紧急服务、政府机构,还涉及宗教组织等多个领域,展示了这场新型网络战的严峻广泛性。 生成式AI在网络犯罪中的核心作用在于其作为一种"力量倍增器",极大提升了恶意行为的效率与智能化水平。

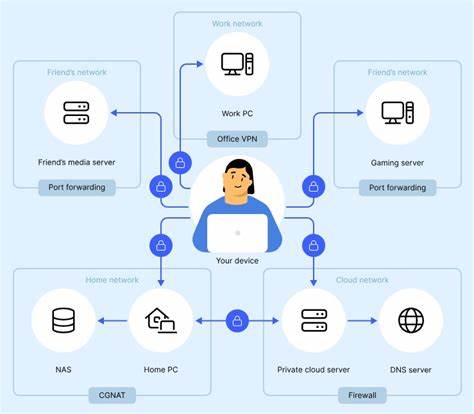

传统的网络攻击经常依赖人工操作、编写恶意代码或进行钓鱼活动,而今生成式AI能自动完成侦察目标、识别薄弱环节、甚至生成多样化攻击方案,显著降低了实施高复杂度攻击的门槛。比如,在远程员工欺诈事件中,AI能够模拟各种沟通风格,伪造极具欺骗性的邮件或对话,以增强欺诈成功率。 这种技术的滥用带来了前所未有的威胁。勒索软件攻击已经超过以往通过加密数据勒索的模式,网络犯罪分子转而威胁公开披露敏感信息以施压受害者,大大增强迫使支付赎金的可能性。此外,AI辅助的攻击工具变得难以追踪和防范,多重变种的恶意软件配备了先进的反检测机制,令传统的安全防护措施面临巨大挑战。 这引发了安全专家和社会各界对技术伦理和监管缺失的深刻反思。

正如多位评论者所指出,技术本身无善恶之分,其影响取决于使用者的意图。面对生成式AI引发的安全风险,关键问题不仅在于技术的力量,更在于为何在早期已知风险情况下,立法和监管迟缓甚至缺位。部分业内人士甚至将此归因于利益驱动下的监管缺失,令快速发展的技术缺乏有效的约束,给社会安全留下隐患。 解决生成式AI助推网络犯罪的问题,须构建多层次、多维度的应对策略。首先,法律法规体系亟需及时完善,涵盖AI技术的开发、应用和安全责任划分,推动制定国际合作框架,实现跨境安全治理。其次,企业必须强化信息安全防护,利用AI自身助力防御,提升异常行为检测与响应速度,强化数据治理与身份认证机制。

此外,公众教育和意识提升同样重要,提升用户的安全意识,防范社会工程学攻击。 与此同时,AI开发者与平台应承担更多责任,建立完善的伦理准则和安全防护措施,防止技术被恶意利用。比如,限制生成式AI在敏感安全领域的功能使用,检测并阻止利用AI生成的恶意代码或欺诈内容。只有技术供应链中的各方协同合作,才能有效遏制AI在网络犯罪中的滥用。 展望未来,随着生成式AI技术不断迭代升级,其对网络安全的影响将愈加深远。网络犯罪分子的攻击手段将持续演进,更加智能化与隐蔽化,可能催生更加复杂的攻击生态体系。

人类社会必须高度警惕,积极推动科学研究、政策制定和国际协作,形成全社会抗击AI驱动网络威胁的联防联控机制。 总之,生成式人工智能作为网络犯罪助力工具,掀开了网络犯罪的新篇章。它带来了便捷与创新的同时,也带来了安全风险和伦理挑战。唯有各方共同努力,构建多层次安全防护体系,推动合理监管和责任追究,才能最大限度地降低生成式AI被用于网络犯罪的恶劣影响,保障数字时代的信息安全与社会稳定。 。