在现代 Web 开发中,内容管理系统(CMS)仍然是许多网站和应用的核心。传统 CMS 通常依赖于持续运行的服务器,而无服务器和边缘计算的兴起,正在改变我们构建和运行这些系统的方式。Payload 是一款活跃的开源 CMS,以其灵活的配置、丰富的组件库和良好的扩展性获得了大量关注。将 Payload 部署到 Cloudflare Workers 上,不仅能享受无服务器和边缘部署的弹性与成本优势,还能借助 Cloudflare 的产品矩阵(如 D1、R2、Workers Bindings)构建一个完整、可扩展且高性能的内容平台。本文从技术路径、实现细节、性能优化和实际应用角度,系统介绍如何把 Payload 运行在 Cloudflare 的栈上,以及这种架构的价值与注意事项。 为什么要把 CMS 放在 Workers 上 传统 CMS 常常要求租用虚拟机或物理服务器,保持数据库连接、文件存储和后端服务持续运行。

这会带来持续成本、扩容复杂度和维护负担。相对地,Cloudflare Workers 提供了按需执行的计算模型,应用会在请求到达时在最近的边缘节点运行,空闲时不占用计算资源,从而显著降低运行成本,尤其适合请求量波动较大的场景。 把 Payload 这样的全功能 CMS 移植到 Workers,意味着你可以在不牺牲传统 CMS 功能(如媒体管理、自定义字段、插件生态、版本历史等)的前提下,获得边缘部署带来的低延迟和更高可用性。此外,Cloudflare 的全家桶(D1 数据库、R2 对象存储、Workers Bindings 等)为完全托管的无服务器部署提供了自然契合的后端能力,减少了外部凭据与额外运维的需求。 技术实现概览 要在 Workers 上运行 Payload,需要解决的关键点包括与数据库的连接适配、媒体存储的兼容、以及在边缘环境中启动 Node/Next 风格应用的兼容性。Cloudflare 的 OpenNext 适配器为在 Workers 上运行基于 Next.js 的应用提供了路径,而 Payload 自 2024 年起增加对 Next.js 的原生支持,这使得将 Payload 移植到 OpenNext 变得可行。

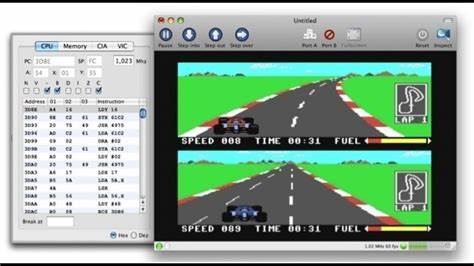

数据库适配是核心问题之一。Payload 原生支持多种数据库适配器,例如 PostgreSQL 和 SQLite。通过 @payloadcms/db-postgres 适配器,可以在 Workers 中连接外部 Postgres 实例,但由于 Workers 请求间无法共享连接池,需要禁用传统连接池并在每个请求中建立连接。为改善连接建立带来的延迟,可以使用 Hyperdrive 等隧道技术,在 Cloudflare 网络内部维护跨节点的连接池,并提供查询缓存,从而显著提升性能。 另一条更为无服务器原生的路径是使用 Cloudflare D1(基于 SQLite 的托管无服务器数据库)。Payload 没有直接支持 D1,但其 SQLite 适配器(基于 Drizzle ORM 与 libSQL)可以作为基础,通过编写一个将 D1 的结果格式映射为 libSQL 期望格式的适配层,便能让 Payload 无缝使用 D1。

关键在于将 D1 的执行结果 transform 成 libSQL 的 ResultSet 结构,并在初始化 Drizzle 时传入 D1 的 binding。 媒体存储方面,Payload 提供了 S3 兼容的存储适配器。Cloudflare R2 与 S3 兼容,但如果希望避免额外的 API 凭据并直接使用 R2 binding,可实现一个轻量的 R2 存储适配器,将上传、删除和静态文件处理逻辑委托给绑定的 R2Bucket。这种方式既减少了配置复杂度,也能在 Workers 环境中更直接地处理请求头、缓存与条件响应(例如 If-None-Match 的 304 返回)。 连接池、隧道与性能优化 在无服务器环境中,数据库连接管理与性能调优极为重要。关闭连接池会导致每次请求都要重新建立连接,这对延迟十分不利。

通过在 Cloudflare 网内使用 Hyperdrive 之类的隧道服务,可以在边缘和数据库主机之间维护持久连接,并在边缘节点复用这些连接,降低了建立连接的开销并引入查询缓存,从而提升总体响应速度。 如果使用 D1,则面临另一个全球性延迟问题:D1 的主实例通常位于某个物理位置,而来自全球不同边缘节点的请求会有不同的 RTT。为减小跨区域读延迟,可以启用 D1 的只读副本功能(Read Replicas),将读取请求分散到全球副本上。为了保证顺序一致性,D1 使用会话机制(session bookmark)。即便当前的 ORM(如 Drizzle)尚未完全支持会话机制,也可以采用"first-primary"策略:第一次查询走主节点,之后的查询可能走就近副本。对只读场景(例如大多数 CMS 的内容展示请求),这种方法能大幅降低 P50、P90 的延迟。

在实际测试中,启用读副本后,跨洲请求的 P50 响应时间有显著下降。这对以全球用户为目标的内容平台尤为重要,尤其当媒体库和文章量大、读取频率高时,读扩展能带来可观的体验改进。 部署与迁移实践 将 Payload 的空白模板通过"Deploy to Cloudflare"一键生成功能部署到你的 Cloudflare 账户,可以自动创建并绑定 D1 数据库和 R2 存储桶,极大降低入门门槛。模板通常只包含基础的用户和媒体表结构,用户可以在此基础上通过修改 Payload 的配置文件扩展集合(collections)、字段和关系,实现自定义的内容模型。 迁移已有内容时,需要考虑数据格式转换、媒体文件迁移和 webhook/集成的重连。对于媒体文件,可以将现有对象存储的文件批量复制到 R2,或在迁移过渡期保持原有存储同时在 Payload 中按需抓取并入库。

数据库迁移可以借助 Cloudflare 的远程 bindings 功能在部署时直接运行迁移脚本,避免暴露额外的凭据。 安全性与合规考虑 在边缘运行 CMS 意味着将应用逻辑和部分业务流程挪到靠近用户的节点上,这带来性能优势,但也需要关注访问控制、认证和数据保护。Payload 本身支持细粒度的用户权限管理以及基于角色的访问控制。在 Workers 环境中,应确保:使用 Cloudflare 的内置 TLS/HTTPS 特性保护传输;对敏感数据采用加密存储与最小化传输;使用 Cloudflare Access 或 Zero Trust 功能对管理面板和管理 API 进行额外的身份验证和访问限制。 对于合规性要求较高的场景,比如需遵守 GDPR 或行业监管规定,需要合理选择数据驻留策略。D1 的副本部署可能将数据缓存在不同地理位置,读副本策略需要与合规需求对齐,必要时将敏感写入操作限定到特定地理位置的主实例,或在应用层做出地域化策略。

可扩展性、成本与运维考量 把 CMS 放到无服务器边缘并不意味着没有运维工作。你依然需要监控请求流量、数据库负载、R2 存储成本和 Worker 执行时间。好的一面是无服务器模型把很多传统运维负担变成了更易观测和计量的指标:例如按请求计费和按存储计费的模型,使得成本更具弹性,流量低时能节省大量费用,流量高时也能按需扩展。 与传统长期运行的 VM 相比,边缘无服务器的冷启动与请求上下文恢复是需要关注的点。Payload 的一些管理操作或长连接型工作负载可能需要重新设计,以适配 Workers 的执行模型。此外,使用诸如 Hyperdrive 的隧道服务可以在一定程度上弥补连接持久性的缺失,但也引入了一个额外依赖,需要考虑可用性和备援策略。

真实案例:Cloudflare TV 的实践经验 Cloudflare 团队在其 24/7 视频平台 Cloudflare TV 上尝试了将 Payload 迁移到 Workers 的实践。该平台包含海量内容库,包括数千集视频和数万级的媒体资产。Payload 在媒体管理、过滤搜索和自定义字段方面的能力,使得迁移过程平滑。借助 OpenNext 适配器、D1 与 R2 的定制适配器,Cloudflare TV 实现了一个可以运行在全局边缘的 CMS 实例,并通过读副本优化显著降低了跨地域请求延迟。 这一实践不仅验证了 Payload 在边缘无服务器环境下的可行性,也为未来在 Cloudflare 平台上构建高并发、低延迟的内容系统提供了宝贵经验。对于其他希望把大型内容平台迁移到边缘的团队,这套方案展示了可操作的路径与需要规避的坑点。

与其他 Workers 原生 CMS 的比较 在 Cloudflare 生态中,不同的 CMS 有不同的定位与优劣。SonicJs 是从头为 Workers、D1 和 Astro 设计的系统,天生适合边缘无服务器的架构,注重轻量与性能。microfeed 则面向轻量级自托管场景,例如播客、博客或图片发布。Payload 的优势在于其成熟的组件生态、更丰富的管理界面和强大的扩展能力,适合需要复杂内容模型、定制逻辑和团队工作流的大中型项目。 选择合适的 CMS,应基于项目规模、团队能力、对插件生态与定制化的需求、以及是否需要与现有生态(例如 Next.js 前端)紧密集成来权衡。 实践建议与常见问题 在把 Payload 部署到 Workers 时,有几条实践建议值得遵循。

首先,评估数据库连接模式,优先考虑使用 D1 并实现与 Drizzle 的良好兼容;当使用外部数据库时,借助隧道技术以维持连接池。其次,针对媒体存储实现 R2 专用适配器,以减少凭据管理和提高请求效率。再次,为读密集型场景启用 D1 的读副本,并使用会话或"first-primary"策略减少跨区域延迟。最后,关注安全与合规,利用 Cloudflare 的 Zero Trust 功能保护管理接口。 常见问题包括如何处理 Worker 环境下长时间运行任务、如何迁移大量历史媒体文件、以及如何对高并发写入进行限流。对于长任务,建议将其拆分为短任务并借助队列或 Durable Objects,如果需要,结合后台函数或外部托管服务。

历史媒体迁移可以采用分批迁移并在应用层做双写兼容。高并发写入则需要结合业务逻辑做写入合并、幂等性设计和数据库层的限流。 结语:边缘 CMS 的未来与创新空间 将 Payload 运行在 Cloudflare Workers 上,是将传统 CMS 能力与边缘无服务器架构结合的成功范例。通过定制数据库适配器、R2 存储适配器、以及读副本等性能策略,开发者可以在保持功能完备性的同时,获得边缘部署带来的低延迟、成本弹性和全球可达性。随着 OpenNext、Drizzle、D1 以及 Cloudflare 平台能力的持续进化,我们可以预见更多 CMS 与框架将原生支持边缘部署,推动内容交付和内容管理进入新的阶段。 无论是构建面向全球的媒体平台,还是搭建团队内部的内容管理后台,或是为产品注入低运维、高效率的内容管理能力,把 Payload 与 Cloudflare 的栈结合,都为开发者提供了有力的工具与实践路径。

欢迎在你的项目中尝试这一方案,并根据实际负载和合规需求,持续优化数据库拓扑、缓存策略与安全控制,以实现稳定、可扩展且高效的内容管理体验。 。