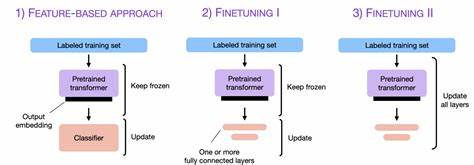

近年来,基于Transformer架构的大规模预训练语言模型如雨后春笋般涌现,并迅速成为自然语言处理领域的核心技术。这些模型通过在海量数据上的预训练,积累了丰富的语言知识和语义表达能力,为多种下游任务提供了强有力的基础。然而,如何在有限计算资源和内存环境下,高效地微调这些庞大的模型,成为学术界和工业界面临的重要挑战。适配器微调技术作为一种参数高效的微调方法,通过在预训练模型的各层插入轻量级适配器模块,使得仅需训练这部分新增参数而非全部模型参数,从而极大地降低了训练成本和存储需求。但即便如此,适配器微调仍然存在内存占用和计算负担较重的问题,限制了其在低资源设备及大规模任务中的应用潜力。针对这一瓶颈,选择性适配器冻结(Selective Adapter Freezing,SAFE)技术应运而生。

其核心思想在于研究发现不同适配器模块在完成下游任务中所发挥的作用和资源消耗存在显著差异。通过动态识别并逐步冻结对任务贡献较小的适配器,SAFE不仅减少了微调过程中的资源需求,还能保持甚至提升模型性能。这种选择性冻结策略体现了资源利用的优化,打破了传统适配器微调“一视同仁”的限制。SAFE的实施为语言模型微调带来了显著的优势。首先,从内存占用角度来看,冻结部分适配器意味着无需计算和存储对应模块的梯度信息,从而节省了大量GPU显存。实验数据显示,SAFE在保持模型性能的前提下,内存使用量平均下降超过四成。

其次,在计算效率方面,不更新的适配器无需参与反向传播计算,极大缩短了训练时间,提升了整体训练效率。数据表明,训练时间缩短了接近十二个百分点,大幅提升研发及部署效率。此外,SAFE技术还具有意想不到的正则化效果。通过减少训练过程中可更新参数的数量,模型在损失函数的优化过程中趋于平滑,避免陷入sharp minima,从而促进泛化能力的提升。这不仅使模型在验证集上的表现更加稳定,还提高了其对未见数据的适应能力。这一点对于实际应用中面对多变环境和多样任务的场景具有重要意义。

在具体应用层面,选择性适配器冻结为自然语言处理任务带来广泛便利。例如,在文本分类、机器翻译、问答系统等多种任务中,SAFE均展现出与传统适配器微调等同甚至优越的效果。同时,因其大幅降低了训练资源需求,推动相关模型在边缘设备和低性能硬件上的部署成为可能,进一步拓宽了预训练模型的应用边界。技术实现方面,SAFE通常包括对各个适配器模块的重要性评估机制,该机制基于训练中参数梯度、权重更新幅度及对任务性能的敏感性等指标,动态判断冻结时机。冻结策略则采用渐进式方法,确保模型能够充分利用每个适配器的贡献,避免性能下降。此外,通过结合元学习和稀疏训练技术,SAFE可进一步提升效果和灵活性,满足多样化应用需求。

未来,随着模型规模的持续扩大及应用场景的多样化,选择性适配器冻结技术无疑将在语言模型微调领域扮演更加关键的角色。结合硬件加速器的进步和分布式训练优化,SAFE将帮助科研人员和工程师突破性能与资源瓶颈,实现更加高效智能的语言理解与生成。总而言之,选择性适配器冻结通过智能管理微调过程中适配器的更新策略,实现了内存和计算资源的大幅节省,同时提升了模型性能和泛化能力。它不仅优化了现有语言模型的应用方式,也为未来生态的绿色智能计算奠定了坚实基础。随着技术的不断成熟和推广,选择性适配器冻结有望成为推动自然语言处理技术迈向新高度的重要突破口。