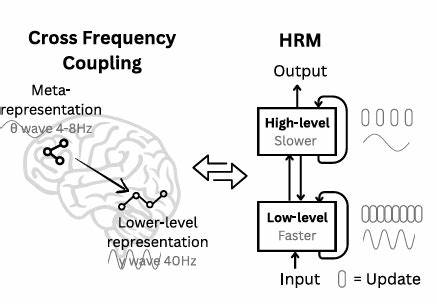

随着人工智能技术的不断发展,复杂推理任务始终是衡量模型智能水平的重要标杆。在目前主流的大型语言模型中,链式思维(Chain-of-Thought,简称CoT)被广泛采用,凭借逐步分解任务的策略,实现了显著的性能提升。然而,CoT存在任务分解脆弱、数据需求庞大以及推理时延较高等问题,限制了其在效率和泛化能力上的进一步突破。针对这些痛点,层级推理模型(Hierarchical Reasoning Model,简称HRM)应运而生,凭借与大脑多时尺度处理机制的类比探索,创造性地提出了一种多模块递归结构,在低样本条件下实现了令人瞩目的推理性能。相比传统CoT方法,HRM不仅优化了训练样本需求,更提升了模型在复杂任务中的准确率和稳定性。层级推理模型的诞生有着深厚的生物学启发基础。

人类大脑中,思维和推理过程往往分为不同层次的抽象与具体阶段,高层模块负责慢速且宏观的规划思路,低层模块则专注于快速而细节化的执行操作。HRM正是借鉴了这一理念,设计了一个含有两个交互递归模块的网络结构。高阶模块进行抽象层面的计划,而低阶模块则依据计划完成细致的计算任务。这种启发式的设计使得模型能够在单次前向传播中同时完成复杂的任务推理,无需对中间步骤进行显式监督,极大提升了训练效率和推理深度。与CoT依赖详尽的链式分解和大量任务示范不同,HRM在参数和数据资源上的要求更为友好。其参数规模仅为2700万,远小于大部分现有大型语言模型,同时仅用1000个训练样本即可在多项复杂推理任务中获得接近完美的表现。

值得关注的是,HRM无需预训练或专门的链式思维数据,即可在数独解题、路径规划等高复杂度任务上展现出顶尖的推理能力。更为显著的是,HRM在人工智能通用能力的重要测试平台——抽象与推理语料库(Abstraction and Reasoning Corpus,ARC)上的表现,远超同类参数量远大且上下文窗口更长的模型。这表明其不仅在特定任务中展现优势,在更为广泛的通用推理场景下也具备卓越的适应性和推理深度。从训练效率的角度来看,HRM的设计极大地缩短了训练时间,提升了资源利用率。即便在资源有限的单张现代GPU上,也能在10小时左右完成极难数独题库的训练,生成一个具有大师级解题能力的AI系统。其分层递归构架使模型能够稳定训练,避免了常见于深度网络中的梯度消失和数值不稳定问题,保障了长时间训练的有效性。

HRM的成功不仅在于模型设计,更在于配套的训练数据集和实验策略。团队提供了多样化数据构建脚本,支持生成极限复杂度的数独、迷宫和ARC任务数据集,保证训练样本具备足够的代表性和泛化覆盖。通过系统化的评估流程及权重和偏差工具,研究者可以实时监控训练进展,灵活调整训练参数,确保模型始终在最优状态下运行。同时,针对模型可能出现的过拟合和数值不稳定现象,官方提供了有效的早停和正则化策略,帮助实现训练与推理的最佳平衡。这项工作不仅具有学术研究价值,也展现出广阔的应用前景。HRM为构建通用推理系统提供了可行方案,特别适合在资源受限、训练样本稀缺的实际场景中推广使用。

在机器人路径规划、复杂逻辑任务自动化、智能游戏辅助以及高级认知推理等领域,都有望借助HRM实现性能飞跃。作为未来人工智能演进的重要里程碑,层级推理模型体现了脑启发式设计与深度学习技术融合的巨大潜力。随着研究的深入和基础架构的不断完善,HRM有望成为智能系统达到“类人”推理和理解水平的关键桥梁。总结来看,层级推理模型通过引入多层次递归结构,成功突破了链式思维的局限,实现了低样本、高效率的复杂推理任务处理。其在多个标准基准测试中的卓越表现印证了此创新构架的有效性。未来,随着更多实际应用的落地,HRM不仅能推动人工智能向更高阶智能迈进,也将促进相关领域研究的新一轮技术革新。

。