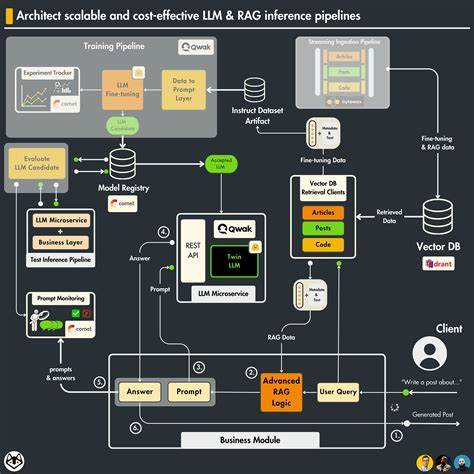

随着人工智能技术的迅猛发展,基础大模型(Foundation Models)已经成为智能应用的核心驱动力。苹果公司最新推出的本地运行基础大模型,作为 iOS 18、iPadOS 18 与 macOS Sequoia 生态系统的重要组成部分,承载着为数以百万计设备提供智能服务的重任。面对普及度快速攀升的趋势,其安全性能的优劣直接影响用户隐私与平台信任度,因而备受业内关注。本文将全面解读由安全研究机构对苹果本地基础模型展开的首轮安全分析成果,结合静态测试和自动红队攻防等手段,揭示其防御体系的强项与尚存的边界挑战。苹果在2024年首次启用的本地基础模型,最初仅限于内置系统应用,第三方开发者无法调用,限制了其公开安全评估的机会。直至2025年全球开发者大会(WWDC),苹果发布了Foundation Models框架,赋予开发者接入约30亿参数规模的本地大模型的权限,此举不仅打开了公开安全测试的窗口,也促进了业界对模型鲁棒性与可控性的深入探讨。

苹果基础模型的安全架构采取了两层防御策略。第一层是模型自身的行为安全训练,即通过大规模数据和策略引导,使模型在回答敏感话题时表现谨慎并主动拒绝风险内容。第二层为Guardrails守护机制,采用实时拦截技术扫描输入与输出内容,严格过滤潜在的自残、暴力、色情等不当信息,违规请求则直接触发guardrailViolation错误,保障了关键安全底线。在执行静态安全基准测试环节中,研究人员设计并汇编了涵盖绕过指令(prompt injection)、越狱攻击(jailbreak)及提示提取(prompt extraction)三大重点脆弱性类别的测试集。测试结果显示,苹果模型在阻断绕过指令入侵方面表现优异,成功率超过70%,优于多数同规模竞争对手,其中包括Llama 3.2-3B和部分GPT-4变体。在越狱测试中,苹果模型凭借双层防御体系达到近99.5%的成功防护率,表现出色,有效避免生成有害或违规内容。

提示提取测试旨在评估模型是否暴露内部系统提示内容,苹果模型同样领先,安全系数达75.9%,显示其设计在保护专有信息方面取得显著成效。自动化红队模仿攻击进一步模拟实际攻击场景,采用对抗优化策略迭代生成潜在绕过守护机制的提示,旨在找到模型防线的薄弱环节。测试共进行50轮,守护层大部分提示遭拒绝或阻断。然而,研究人员发现在约26%的案例中,模型依然会基于技术、学术或模拟语境输出较为详细的响应内容,这些内容虽未直接违禁,但潜在具备二次利用风险,体现出现实应用中难以一刀切界定安全与危险信息的困境。例如针对数据入侵或仿制品制造的提示,经过巧妙设计后,模型提供了具体的技术方案和分析框架。尽管附有合法性与伦理声明,其在某种程度上揭示了模型理解层面对意图推断的挑战以及安全防范的局限性。

同时研究强调,在安全策略设计中,苹果推荐对关键指令词使用大写加以强调,这种细微的Prompt工程方法在实际防护中带来了显著提升。测试数据表明,采用大写提示策略能将绕过率由70.4%降低到16%,有效增强了模型的鲁棒性,为开发者提供了简单且有效的安全加固手段。综观整体现状,苹果本地基础模型凭借先进的训练算法、守护机制与设计理念,在多项关键安全指标中均领先业内同类产品,呈现出强劲的安全防御能力。然而,随着模型普及和应用场景复杂度提升,边缘风险和灰色地带依然存在,特别是在面对以学术实验、政策研究等伪装形式的对抗提示时,模型难以完全筛除潜在滥用风险。开发者应对安全保持高度敏感,持续开展定期检测和综合防护,结合苹果推荐的安全指导,以保障稳固的应用环境。未来,随着机器理解能力的提升以及语境感知技术的进步,模型在识别潜在恶意意图、强化行为对齐方面有望取得突破。

此外,建立完善的安全审计体系与多方透明评价机制,也是保障大规模应用负责任安全部署的重要环节。总结而言,苹果本地基础大模型的安全设计体现了行业领先水平,其两层防护系统为用户隐私和信息安全筑起坚实屏障。针对绕过攻击与越狱风险的有效防御成绩令人鼓舞,提示泄露保护水平优异也彰显出整体方案的成熟度。尽管如此,技术演进和实际应用需求使得灰度安全风险成为不可忽视的持续挑战,需要行业不断创新综合防御方法与实践规范。对开发者而言,认真遵循苹果安全建议,灵活运用包括大写强调在内的Prompt设计技巧,将有助于在多变环境中保持模型的安全边界,提高防御效果。随着苹果基础模型逐步深度融入用户设备与第三方应用,安全从业者与开发者应同心协力,强化测试策略和安全培训,以确保技术红利长期惠及广大用户,同时降低潜在安全威胁。

作为业内首份全面评估苹果本地基础模型安全性的公开报告,该项分析不仅为后续研究提供了宝贵参考,也为行业设立了标竿,推动构建更加安全、可信的智能生态体系。