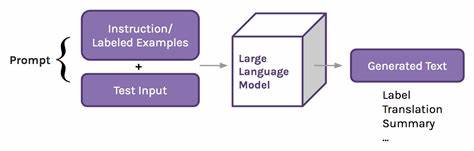

随着人工智能技术的飞速发展,大型语言模型(Large Language Models,简称LLMs)正逐渐成为日常生活和工作中不可或缺的工具。无论是在自动回复邮件、智能客服,还是代码生成和内容创作中,LLMs的表现都令人惊叹。然而,许多人会好奇,这些语言模型究竟是如何“理解”我们提出的问题,并给出贴切回应的呢?尤其是在一些对话中,模型似乎能够捕捉到细微的暗示和上下文信息,甚至在用户没有明确表述的情况下作出相关建议,例如在回答结束时说“祝你编程愉快”这样的话。本文将深入剖析大型语言模型如何利用上下文来理解问题,解析其背后的技术原理及实际案例。 大型语言模型的基本构造基于Transformer架构,这是一种在自然语言处理(NLP)领域取得突破性进展的神经网络结构。Transformer的核心机制之一是“自注意力机制”(Self-Attention),它允许模型在处理输入时动态地关注相关的词语和语句,从而更精确地捕捉文本内部的联系。

相比传统的循环神经网络(RNN),Transformer能够并行处理信息,并且擅长建模长距离依赖关系,这使得它在理解上下文方面具备了显著优势。 在与用户的对话中,LLMs并非孤立地处理单句内容,而是会对整个对话历史进行编码。每当用户提出新问题时,模型都会将之前对话的内容作为上下文输入,通过自注意力机制理解前后语境,并推测用户的意图和潜在需求。这样的设计使得模型能够识别比如“你刚才说到代码的问题”或者“谢谢你的帮助”这类语句背后的隐含信息,从而灵活调整回答内容和语气。 关于你提到的“Happy coding”这类回复,虽然在训练数据中并非所有回答都会以这种方式结尾,但模型通过大规模的数据学习到了一些常见的表达习惯和社交礼仪。当用户在对话中表达感谢或与编程技术相关时,模型很可能根据已学的模式自动生成适当的祝福语,这不完全依赖于训练集里的具体句子出现频率,而是模型对语言使用场景的综合理解。

例如,如果用户前面的提问或回应涉及编程,模型就会关联“coding”这个主题,进而生成贴近上下文的结尾语。 训练大型语言模型使用的是海量的文本数据,涵盖了网页、书籍、论坛、技术文档等多种类型的文本内容。这些数据本身就包含丰富的上下文信息和人类语言的使用特点。在不断的训练过程中,模型会调整其参数,学习不同词汇和表达之间的关联与规律,逐渐形成对语义和语境的敏感度。这种广泛的语料学习使得模型具备了在面对新问题时推断上下文的能力,而非单纯依赖于字面匹配。 此外,在实际应用时,为了增强语言模型对上下文的理解,工程师们常常采用“上下文窗口机制”。

所谓上下文窗口,就是模型每次处理的信息范围,包括用户最近输入的文本和此前的对话内容。通过合理地设计上下文窗口大小,可以确保模型在回答时既考虑当前问题,也结合对话的整体轨迹。这种方法能够大幅提升对话的连贯性和针对性,从根本上增强用户体验。 需要注意的是,尽管大型语言模型在语境理解方面表现优异,但它们仍然存在一定的局限性。有时模型可能误解用户意图,或者由于训练数据中的偏见和不足,导致生成的回答不够准确或适用。因此,为了保证模型输出的合理性和安全性,通常还会配合人类审查、规则过滤和持续优化等手段。

在未来,随着模型规模的进一步扩大和算法的不断革新,语言模型的上下文理解能力将持续提升。多模态融合技术也有望让模型不仅能理解文本,还能结合图像、音频等多种信息源,更加深入地解析用户需求。作为使用者,理解语言模型如何捕捉和利用上下文,有助于更有效地与AI交互,发挥其最大潜力。 总结来看,大型语言模型通过Transformer架构的自注意力机制以及大规模的训练数据积累,实现了对上下文的高效理解,能够根据对话内容推断隐含信息并做出相关回应。它们的智能表现源自对语言规律和使用场景的深度学习,而不是简单的字面匹配。因此,诸如“Happy coding”等看似细微的细节,正是上下文理解与人类语言习惯结合的生动体现。

未来,随着技术演进,LLMs将在更多领域展示其实用价值和创新潜力,引领人工智能发展的新风潮。