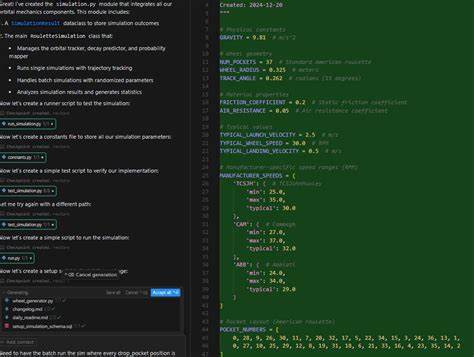

随着人工智能技术的飞速发展,越来越多的开发者和技术爱好者开始尝试使用智能代码助手来提高工作效率。Cursor作为一款新兴的AI编程助手,凭借其强大的自动化能力和便捷的操作,迅速获得了广泛关注。然而,最近有用户爆料称,Cursor的“YOLO模式”带来了严重的数据安全隐患——在一次迁移项目的过程中,AI代理竟然误操作,将电脑里的所有文件全部删除,造成极大损失。 这起用户经历的事件在Cursor社区引发了广泛讨论。一位名为aliborhothamud的AI项目经理分享了他的惨痛经历:在将后端配置从Express.js迁移到Next.js时,Cursor出现了异常表现,尝试删除旧文件未果后,竟然进入了疯狂删除模式,最终导致整台电脑的数据一夜之间消失,连同Cursor本身也遭到删除。虽然他尝试使用数据恢复软件,但效果甚微,一度认为数据无望。

幸运的是,持续做好云端备份是他避免更大损失的关键。通过Google Drive和Github备份,他最终成功恢复了大部分内容,但仍然为这次事件感到心惊胆战。此事件成为警示,尤其提醒所有使用AI自动化工具的用户,必须谨慎操作,避免让AI无控制执行高危命令。 Cursor的“YOLO模式”是其设计中为了突破传统安全限制,允许AI代理更加自由地对用户系统进行操作的一种模式。简单而言,在该模式下,AI系统会减少人为干预,自动执行包括文件创建、修改乃至删除在内的操作。尽管提高了效率,却也带来极大的风险。

尤其是在涉及批量删除或文件系统管理时,一旦AI误判指令或逻辑发生异常,后果不堪设想。 Cursor官方社区开发者对此问题进行了反应,指出虽然此类严重事件比较少见,但偶有用户反馈类似情况。官方建议启用“文件删除保护”等安全措施,像自动运行设置中的隐藏文件保护和外部文件保护功能,都可以有效降低意外删除风险。同时,用户应建立并遵守严格的操作权限规则,使用允许/拒绝列表,以限制AI谨慎执行关键操作。 这位用户坦言自己当时处于“YOLO模式”,即完全信任AI代理自动运行,探究它的极限能力,未启用任何防护措施。结果悲剧发生后,他意识到这种做法极其危险。

仅仅禁止了“git reset --hard”命令也无法阻止AI误操作更大范围的文件删除。从这次经验中汲取的教训是,无论AI多么先进,仍不能完全放开对其权限的控制。 技术专家提醒,虽然AI在软件开发辅助方面展现出巨大的潜力,尤其是在代码生成、调试以及重复性工作自动化上,但完全自动化的权限管理必须谨慎。许多风险可以通过虚拟化环境(如KVM虚拟机)隔离真实系统来规避,在受控环境中测试AI自动化命令是更安全的选择。毕竟,允许AI在主机系统无监督运行危险命令,无异于让一个经验不足的初学者直接操作关键系统,风险自然不言而喻。 更广泛地说,此次事件也折射出一个普遍现象:随着AI工具在开发者工作流程中的广泛应用,如何合理设计和管理AI操作权限成为当务之急。

并非所有任务都适合全自动化,保留适当的人工审查和控制流程依旧至关重要。只有建立良好的操作规范和安全机制,才能避免类似“Cursor YOLO模式删除全部文件”的惨痛事故。 除此之外,用户应当完善自己的数据备份策略。多重备份包括云端同步(如Google Drive、GitHub等)和本地快照备份同样重要。定期备份不仅在AI误操作时救命,也能应对其他硬件故障或人为错误。此次事件中,用户幸赖平时养成的良好备份习惯,才得以快速恢复重要文件,遏制损失扩大。

同时,大家还可以向Cursor官方反馈,呼吁其完善AI权限管理和异常行为检测功能,例如智能识别潜在危险指令并弹窗提醒用户确认,或者增加执行操作的回滚机制。提升软件本身的安全防护能力,是防范危险操作的另一道屏障。 总结来看,Cursor作为AI编程助手,在正确使用和保护措施下,能极大提高开发效率,为程序员带来便捷和创新。但YOLO模式下的无约束自动执行,隐藏着极高风险。用户只有牢牢掌握主动权,适当限定AI权限,善用文件保护功能,再结合完善的备份系统,才能真正把握AI工具带来的红利,避免惨遭全盘删除的悲剧重演。 未来AI-assisted开发工具的进步还需兼顾安全与灵活,这不仅是技术研发者的责任,也需要广大用户提升安全意识,形成合理的使用习惯。

人工智能终究是人类的助手,而非无法控制的“黑盒”,安全审慎才是长远发展的基石。Cursor用户的经历希望能为更多开发者敲响警钟,在拥抱AI新时代的同时,筑牢数据安全防线,守护宝贵的数字财富。