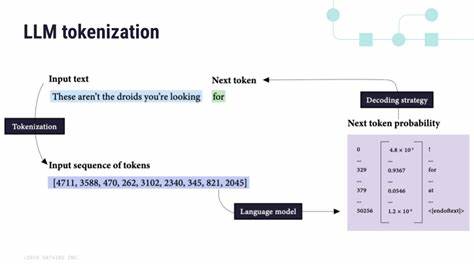

随着人工智能技术的飞速发展,大型语言模型(Large Language Models,简称LLM)在自然语言处理领域的应用日益广泛,从文本生成、机器翻译到智能问答,LLM已成为现代AI生态系统的中坚力量。然而,伴随着这些强大功能的,是其背后的庞大计算资源消耗和环境影响。尤其是在生成文本的最基本单位——Token时,所需的计算能量和碳排放已成为科研人员和业界关注的焦点。理解LLM生成一个Token需要消耗多少能量,对于推动绿色AI技术的发展具有重要意义。 首先,需要明确什么是Token。Token是文本处理中最小的计算单位,通常代表一个词或词的一部分。

在LLM的推理阶段,模型通过复杂的数学运算根据前面的上下文预测接下来的Token。每增加一个Token的生成,都意味着模型执行了一系列的浮点运算(FLOPs),这些计算过程需要消耗电力和计算资源。研究指出,计算LLM生成每个Token的能量消耗,需结合活跃参数数量(Active Parameters)、硬件效率、数据中心的能效,以及所在地区的碳排放强度等多个因素。 活跃参数是指模型在生成单个Token过程中参与计算的参数数量。大型语言模型往往拥有数百亿甚至上千亿的参数,但并非所有参数在每次推理时都会被激活。稠密模型中,活跃参数数目与整体参数数目相等,而在专家混合模型(Mixture of Experts, MoE)中,活跃参数只占整体参数的一个子集,从而降低了每个Token的计算负担和能耗。

通过这样的方法,MoE模型在理论上更加节能环保,但真实的能耗还需考虑额外的内存和专家路由开销。 针对能耗计算,基于当前最先进的硬件(如NVIDIA H100芯片)、浮点运算精度及硬件效率,科研团队采用了公式E=2×Nactive×T×η将浮点操作数转换为实际能量消耗,其中η代表硬件每焦耳能执行的浮点操作次数,T是Token数量,Nactive是活跃参数数量。以某款拥有320亿活跃参数的模型为例,生成100万个Token的总能量消耗约为0.016千瓦时,平均每个Token消耗约1.6×10^-8千瓦时。 在经济成本上,以美国Google us-central1数据中心的电价为例,生成一百万个Token的电费约为0.00246美元,相当于每个Token极低的电力花费。然而,尽管单个Token的成本看似微不足道,但大规模模型的持续运行累计起来,所产生的能耗和相关碳排放不容忽视。 环境方面,碳排放的计算依赖于数据中心所使用的电力碳强度。

例如,Google us-central1的碳强度约为0.243千克二氧化碳每千瓦时,结合能耗数据可得生成一百万个Token的总碳排放约为0.00393千克二氧化碳。虽然生成单个Token的排放量非常小,但在训练和推理过程中累计的排放量却显示出庞大的环境压力。 此外,硬件精度对能耗影响也值得关注。传统浮点16(FP16)精度已较浮点32(FP32)有显著的能效提升,若采用更低精度的FP8,则效率又可提升两倍,从而进一步减少每个Token计算过程的能耗。这对于研发节能的AI硬件和软件优化方向提供积极的启示。同时,数据中心的电力使用效率(PUE)指标也在能量消耗评估中起到关键作用,PUE值越接近1说明数据中心的能效越高,能耗损失越少。

未来,降低LLM能耗和碳排放成为推动可持续AI发展的关键方向。除了硬件优化和算法改进,选用碳排放较低的电力供应区域,以及提升模型参数利用率,也是减轻环境负担的有效方式。此外,模型架构和推理方式的创新,比如稀疏激活、模型蒸馏及动态计算,都将有助于降低单个Token生成的能耗。 综上所述,理解和量化大型语言模型生成每个Token过程中所需的能量消耗及其碳排放,是实现绿色AI的重要基础。虽然当前单个Token的计算能耗较低,但在海量应用场景下的累计影响不容忽视。持续推动硬件效率提升、优化模型结构以及采用更清洁的电力资源,将为AI技术的可持续发展铺平道路。

面对气候变化的全球挑战,科技界和产业界需要携手努力,在保证技术革新的同时,最大限度地降低环境影响,让人工智能真正成为造福人类的绿色力量。