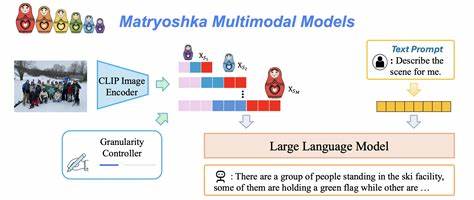

随着人工智能技术的飞速发展,多模态人工智能模型已成为研究热点,尤其是在视觉与语言结合领域取得了显著突破。视觉-语言模型(Vision-Language Models,简称VLMs)因其在图像与文本信息融合处理上的强大能力,广泛应用于图像描述、视觉问答、图像检索等诸多领域。然而,当前主流VLMs在处理复杂视觉推理任务时仍面临瓶颈,主要因其输出形式依赖文本,使得模型不得不将视觉信息转化为文字进行表达,这种“文字化”的推理限制了模型发挥更高层次“视觉想象”的能力。近日,一项名为《Machine Mental Imagery: Empower Multimodal Reasoning with Latent Visual Tokens》的研究为这一难题提供了创新解决思路,提出了“机器心理成像”(Machine Mental Imagery)框架——Mirage。该框架通过引入潜在视觉标记(latent visual tokens),在视觉-语言模型的解码过程中实现视觉与文本的交错融合,打破传统模型纯文本输出的束缚,赋予模型强大的视觉想象力和推理能力。人类在思考和解决问题时,心理成像能力是不可或缺的认知工具——我们往往先在脑海中构建出问题的视觉场景,再基于这些内在视觉线索进行推理和决策。

Mirage灵感正源于此,设计出一套让机器在无需显式生成图像的前提下,以潜在视觉标记作为内部“心象”进行思考的机制。这些潜在视觉标记并非传统意义上的像素图像,而是经过编码和压缩的隐含视觉特征。具体而言,Mirage框架允许模型在生成文本响应的同时,选择“视觉思考”的路径,将隐藏状态映射成视觉标记,维持一个多模态的信息流,使语言与图像信息交织,促进深度推理能力的提升。该系统首先通过监督学习,将潜在视觉标记对应到真实图像的嵌入向量,确保其视觉表达的准确性。之后通过文本监督引导,潜在视觉标记与任务目标更紧密地协同,摆脱对显式图像生成的依赖。此外,采用强化学习进一步微调模型,使其在具体多模态推理任务中表现出更强的适应性和推理效果。

这套创新机制极大拓宽了视觉-语言模型的表现力,实现了在无需生成高成本图像的前提下,依旧能够具备如同人类般的视觉“心理演算”能力。实验结果表明,采用Mirage框架的模型在多个标准多模态推理基准测试上,均显著优于传统文本解码模型,从图像理解到语义推理均表现卓越。该研究不仅推进了视觉-语言模型的技术边界,也揭示了机器智能与人类认知机制融合的新方向。进一步讲,机器心理成像技术打开了人工智能多模态交互的新局面。现实应用中,许多任务需要模型具备高度的视觉想象力,例如复杂场景的推理、多步骤视觉问答甚至创造性视觉内容生成。Mirage的潜在视觉标记机制使模型能像人类一样,在内心“构建”视觉场景,随后围绕这些场景展开推理,而非被动依赖外部图像或仅用语言描述。

这样的机制提升了模型应对开放式、模糊复杂任务的能力,对于自动驾驶、智能监控、医疗诊断等领域均具有重要意义。从技术层面看,Mirage采用的潜在视觉标记是一种高效的视觉表示形式,它大幅降低了传统图像生成的计算开销,摆脱了生成模型对大量图像数据的依赖。同时,该方法通过多阶段训练策略结合监督与强化学习,使模型不断调整自身的视觉语言映射关系,实现对多模态数据的深度融合与理解。这不仅提高了推理准确率,也增强了模型的泛化能力和稳定性。未来,机器心理成像有望成为多模态AI系统的核心模块,为机器人与智能助理注入类人视觉想象力,使其能够更灵活、精准地处理视觉信息并作出智能反应。结合增强现实(AR)、虚拟现实(VR)和人机交互技术,Mirage框架还能提升用户体验和交互效率,推动人工智能在教育、娱乐、设计等多个领域的应用创新。

当然,尽管Mirage开辟了多模态推理的新路径,但相关研究仍处于起步阶段,仍需解决潜在视觉标记表达解释性、跨领域适应性及训练资源优化等挑战。与此同时,如何构建更丰富的心理成像机制,实现多模态信息的动态交互和深层语义融合,将成为未来重要研究方向。总之,机器心理成像通过潜在视觉标记赋予视觉-语言模型“心象”的能力,极大扩展了人工智能的视觉推理边界。Mirage框架所展现出的强大多模态推理效果,不仅推动了视觉与语言模型的前沿发展,也为实现更接近人类认知机制的智能系统奠定了坚实基础。在科技飞速进步的当下,借助机器心理成像技术,未来人工智能将更加擅长模拟人类思维,完成复杂视觉理解与推理,为各行业智能化转型提供坚实支撑。