随着云计算和基础设施即代码(Infrastructure as Code, IaC)的广泛应用,Terraform已经成为构建和管理云资源的主流工具之一。然而,保证Terraform模块的质量和稳定性并不简单,测试工作显得格外重要。近期,结合人工智能(AI)大语言模型(LLM)在代码生成领域的应用,业内探索出了一套适用于Terraform测试生成的有效提示策略,为开发团队的测试编写带来了变革。 Terraform测试的核心目标是保证模块中的配置和资源变更符合预期,避免将潜在的错误与故障引入生产环境。传统上,编写测试代码需要深入理解Terraform的测试框架和模块架构,这对工程师来说既费时又容易出错。利用AI辅助生成测试代码成为一种趋势,尤其是通过优化提示(prompt)策略,能够引导LLM产生更符合项目需求和最佳实践的高质量测试代码。

构建高效的Terraform测试提示,首要条件是明确代码库的结构和模块的组织方式。向AI模型准确描述Terraform子模块的目录结构、测试文件应存放的位置,以及已有资源的使用方式,有助于引擎建立清晰的上下文感知。这种细致入微的信息传递,使模型避免生成散乱的文件结构,保证测试代码整齐、易于管理。 提示中建议引导AI逐步完成编码任务,采取小步快跑的策略,分阶段生成代码,再由人类开发者进行审查和确认。此做法不仅提高了代码的准确度,还降低了错误传播的风险。尤其针对Terraform复杂的变量输入验证和边界条件检测,分批次生成测试逻辑能够更好地控制测试覆盖范围和质量 一个成熟的提示策略应该鼓励AI主动向使用者提问,澄清任务细节和特殊需求。

由于LLM天然会带有一定的猜测成分,允许模型提出问题,有助于缩小理解偏差,避免生成无关或低价值代码。此机制在多团队协作时表现尤为重要,能确保模型生成的测试代码契合实际业务场景和技术规范。 在测试内容设计中,明确让AI覆盖各种测试场景同样关键。提示策略往往包含对"愉快路径"(happy path)、异常边界(edge case)和复杂用例的划分,要求模型针对不同层面逐一生成对应测试代码。例如,验证变量的必填性及错误输入时的表现,测试资源本地计算逻辑,无需通过输出暴露变量等检验方法,这样的细分策略可以确保测试覆盖全面且结构合理。 至于提供给AI的环境配置,建议在提示中强调对所有Terraform提供商的模拟(mocking)。

这一步能够避免测试过程中误调用真实云服务,提升测试的安全性和执行效率。通过内置或示范具体提供商如AWS和Tailscale的模拟样例,模型能够掌握正确使用mock的方式,从而降低真实依赖引发的风险。 面对AI生成测试代码中常见的冗余和冗长问题,持久提示策略还会特别强调代码的重构和简洁原则。引导模型对测试逻辑进行抽象和去重,保留原有功能覆盖的同时减少重复代码,显著提升后续维护的便捷性。随着测试矩阵日益丰富,保持代码的整洁性变得尤为重要。 此外,LLM输出存在一定程度的随机性,这种非确定性的行为虽然带来波动,但也提供了多样化解决方案的可能性。

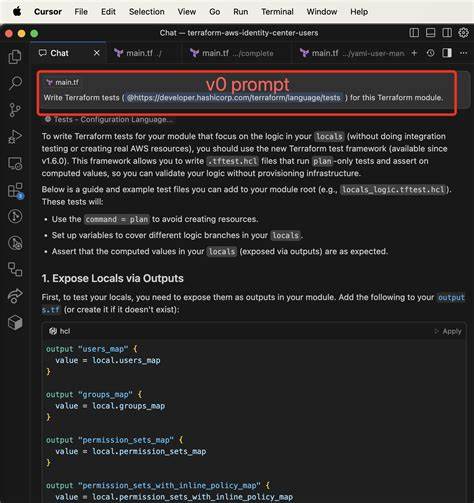

通过多次执行同一提示生成不同版本的测试代码,团队能够筛选最佳实现,借此激发创新和优化思路,把控测试质量和表现。 具体的工具选择方面,集成了AI功能的编辑器如Cursor提供了直观、快速的测试代码生成体验,支持规则化提示管理和实时上下文感知,有效缩短反馈迭代周期。另一方面,终端交互式AI助手如Claude Code更擅长一气呵成地生成完整且结构明确的测试文件,适合大规模测试脚本的初稿创作者。 在实际应用过程中,结合Cursor和Claude Code的优势,采用先进的Sonnet-4模型和经过多轮迭代优化的提示,团队成功实现了跨不同Terraform子模块的测试覆盖生成。虽然仍需开发人员进行审查和精炼,但基础框架和测试逻辑达到了接近人工编写的水准,为IaC测试的标准化和自动化奠定了坚实基础。 总结来看,推动Terraform测试生成自动化的关键在于深入理解代码库及业务需求,设计细致且结构化的提示语,结合高能力的语言模型辅助产出。

持续优化提示,鼓励AI与人类协同工作的机制,覆盖多维度测试场景,以及规范对云提供商接口的模拟策略,共同构成了一套成熟的提示策略体系。企业如果能够将这些实践融入日常开发流程,必将大幅加快测试编写速度,提升代码质量和团队协同效率。 未来,随着AI模型能力的提升及IaC技术的演进,提示工程将在基础设施测试领域扮演愈发重要的角色。适应和引领这一趋势,将帮助开发团队在云原生时代实现更加自动化、智能化的基础设施管理与保障。关注和探索更多优化提示的可能性,将是提升Terraform项目生命力和竞争力的关键所在。 。