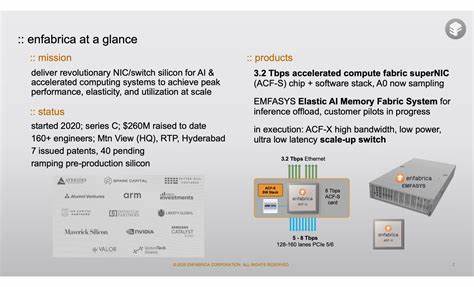

随着人工智能和大数据技术的飞速发展,构建高效、低延迟且具备弹性的计算集群,成为科技企业面临的重要挑战。Enfabrica作为一家深耕高性能互联解决方案的先锋企业,其独特的技术架构和创新设计正在开创业内新标准。近期因被NVIDIA高薪聘用创始团队,引发了业界广泛关注。本文将深入剖析Enfabrica的核心技术优势及其对未来AI集群架构的影响。 Enfabrica的核心技术基于其旗舰产品ACF-S"Millennium"芯片,这是一款同时支持大量PCIe通道与高带宽网络I/O接口的革命性芯片。芯片的一侧集成了128条PCIe通道,另一侧则拥有32条112G高速网络线路,实现高达3.2Tbps的传输能力。

如此高密度的PCIe与网络接口结合,使得在大规模计算环境中,设备连接和数据流动的灵活性和效率得到极大提升。 大规模AI推理和训练集群,往往需要将大量GPU和网络设备高效连接,而传统解决方案受限于单一通信链路的带宽瓶颈和稳定性问题。Enfabrica通过提供多路径冗余机制,支持如32条100G链路与多达四个800G端口的灵活配置方案,即使单点故障发生,整体集群性能仅受到非常有限的影响。这种高冗余、多路径的设计大幅提高了系统的可靠性和数据传输的连续性,为大型数据中心和边缘计算节点提供了坚实保障。 值得关注的是,Enfabrica不仅关注网络传输的带宽和稳定性,更搭建了围绕PCIe接口的创新生态体系。其集成的可编程引擎赋能用户开发定制协议,实现异构设备间的高效协同。

尤其在当前兴起的CXL(Compute Express Link)技术框架下,Enfabrica的解决方案支持将各种计算和存储设备以低延迟方式连接入同一互联生态,推动弹性内存池的实现。 Enfabrica基于ACF-S芯片打造的弹性内存交换系统EMFASYS能够将多达18TB的CXL内存资源通过RDMA网络共享给成百上千的GPU节点。这意味着GPU集群不再受制于每节点有限的高速缓存容量,通过网络访问更大规模的共享内存池,显著降低了内存瓶颈对推理性能的限制。GUI集群可以更灵活地管理数据层次,有效释放高成本高速缓存(如HBM)资源,优化计算任务的整体效率。 该系统还针对大型分布式推理场景设计,能够支持键值缓存交换和分布式token存储等关键功能,极大提升了LLM(大型语言模型)等AI模型在推理阶段的响应速度和资源利用率。根据Enfabrica的内部数据,基于EMFASYS实现的架构在大规模推理集群中,能够将每token的计算成本降低达50%,这对降低云端推理的综合运营成本具有重要意义。

从系统架构层面来看,Enfabrica不仅专注于提高单节点的硬件能力,更关注整体集群的弹性可扩展性和故障容忍能力。传统网络方案往往依赖于大带宽的单一链路,当链路失效时,可能导致GPU节点与网络间断,引发性能骤降。相较之下,Enfabrica的多路径高径向设计允许数十条链路同时存在,即便若干链路故障,其余链路能够迅速接管流量,无需中断服务,显著提升了集群运行的连续性和稳定性。 NVIDIA此次收购Enfabrica团队,可视为加速其自研下一代大型AI集群互联技术的关键举措。Enfabrica的技术堆栈兼具高性能和高度可编程性,能为未来的GPU服务器和AI算力平台,提供从底层硬件互联到上层内存共享的全方位支持,助力构建省成本、高效率的智能计算基础设施。 Enfabrica所展现出的技术前瞻性和系统设计理念,不仅解决了当前AI训练和推理过程中面临的性能瓶颈,更为未来随着模型复杂度提升而不断扩展的算力需求,提供了可持续的解决方案。

随着全球AI计算规模的持续扩大,类似Enfabrica这样拥有创新设计和强大工程能力的企业,将在推动AI技术落地应用和行业革新中发挥日益重要的作用。 总结来看,Enfabrica通过其独特的ACF-S芯片和弹性内存系统,打破了传统数据中心的设计限制,实现了高带宽、低延迟、多路径冗余和大规模内存共享的完美结合。这种技术融合不仅为大规模AI集群架构注入了活力,也为产业界提供了新的发展方向。未来,随着更多企业和科研机构采用类似的高性能互联方案,AI及高性能计算的整体水平将跃上一个新的台阶,推动科技创新和经济发展迈向崭新高度。 。