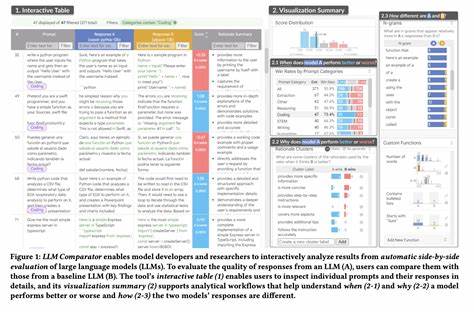

近年来,随着人工智能技术的迅猛发展,大型语言模型(LLM)在自然语言处理领域展现出强大的能力,成为促进人机互动和自动化文本生成的重要引擎。然而,尽管这些模型在语言理解和生成方面取得了明显成效,它们仍面临一个关键的挑战:幻觉(hallucination)现象。幻觉指的是模型生成与事实不符或虚假的信息,这不仅影响用户体验,更可能带来严重的误导问题。针对这一现状,CompareGPT.io作为一个创新的平台亮相,致力于通过多模型并行比较技术,协助用户识别和减少AI文本生成中的幻觉现象。CompareGPT.io利用多种大型语言模型共同处理同一输入任务,通过对输出结果进行跨模型对比分析来提升信息的可靠性和准确度。平台不仅涵盖了传统的GPT系列,还集成了多个主流且性能各异的模型,实现多角度审阅文本内容。

相比于单一模型输出,依托多模型对比的方式显著降低了模型偏差带来的错误风险。这个过程不仅有助于发现不一致或错误的信息,还可以促进对文本可信度的评估。用户可以直观地看到不同模型针对同一问题给出的结果差异,从而更清晰地判断信息的真实性和合理性。除此之外,CompareGPT.io的多模型对比功能还为研究者和开发者提供了一个强大的工具,可以分析不同模型的表现差异,理解各自优势与局限,进而推动语言模型的优化和迭代。幻觉现象的降低不仅仅是文本准确度的提升,更是AI技术广泛应用于医疗、金融、法律等专业领域的基本保障。例如,在医疗咨询中误导性信息可能导致严重后果,多模型比较输出能有效减少此类风险,提高AI助理的可信度。

在金融领域,准确的数据解读和策略建议同样依赖于语言模型的真实性与准确性,CompareGPT.io在这方面为用户提供了应对复杂需求的解决方案。平台界面简洁友好,用户无论是技术专家还是普通终端用户,都能轻松上手。通过输入查询,平台迅速返回多模型答案对比,辅助用户做出更明智的判断。针对企业用户,平台还支持定制化功能,例如根据具体业务场景选择合适模型组合,实现个性化和专业化的内容生成与验证。随着人工智能应用场景的逐步扩展,信息的准确性和可信度显得尤为重要。CompareGPT.io的出现,为解决大型语言模型幻觉问题提供了创新思路和实践路径。

其多模型对比机制不仅提高了文本输出的质量,也为整个行业树立了技术标杆。面对日益增长的数字信息需求和对AI辅助决策的期待,利用CompareGPT.io多模型对比功能,将有效助力用户规避错误信息,提升决策信心。此外,CompareGPT.io还积极推动开放合作,与多家AI研发机构及企业合作,共同致力于提升语言模型的性能稳定性和应用安全性。通过持续技术迭代与生态建设,平台不断完善多模型对比体系,为构建更加智能且可信赖的人工智能生态奠定基础。未来,随着大型语言模型在各个领域的深度融合和应用,幻觉现象的治理仍将是行业关注的重点。CompareGPT.io的多模型策略为此提供了实际可行的解决方案,结合不断进步的模型技术,将促使AI生成内容更加真实、准确与有价值。

总的来说,CompareGPT.io作为一个多模型LLM对比平台,通过协同多个先进语言模型的力量,显著减少幻觉生成,提升整体文本质量及可信度,推动人工智能服务向更高水平迈进。其创新理念和实用工具为广大用户树立了可信赖的AI应用典范,助力人工智能产业健康可持续发展。 。