在人工智能领域中,不断涌现出新的创新公司和技术,而其中一个最近引起广泛关注的新闻便是OpenAI的联合创始人伊利亚·苏茨凯弗(Ilya Sutskever)为其新创立的公司“安全超级智能”(Safe Superintelligence)成功融资十亿美元。这一消息不仅引发了业界的热烈讨论,也为未来人工智能技术的安全发展增加了新的期待。 伊利亚·苏茨凯弗在OpenAI工作期间,以其对人工智能的深入理解和前沿研究而闻名。他在此次成立的新公司中,致力于开发具有安全机制的超级智能,旨在超越人类现有的所有能力。这一目标虽然雄心勃勃,但在当前的外部环境下,安全性问题也成为了人们关注的焦点。 “安全超级智能”成立仅三个月,就获得了来自风险投资界的巨额资金。

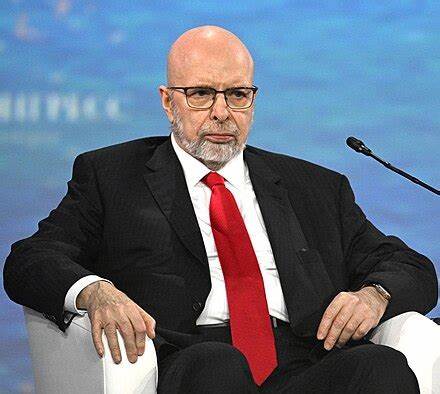

这次融资的投资者包括知名的风险投资公司Andreessen Horowitz和Sequoia Capital,这些公司以其敏锐的投资眼光和前瞻性的技术判断而著称。根据相关报道,“安全超级智能”的估值已经达到了五十亿美元,这在创业公司中是相当高的数字,显示了市场对其未来发展的信心。 在接受采访时,公司首席执行官丹尼尔·格罗斯(Daniel Gross)表示,能够与理解并支持公司使命的投资者共同合作,是他们坚持追求安全超级智能目标的重要前提。他提到,当前的重点是招募顶尖开发人员,并确保充足的计算能力来训练这一人工智能系统。格罗斯提到,公司的目标是在未来几年内,专注于研究和开发,以打磨出一款真正安全且强大的超级智能。 超级智能的概念并非新鲜事物。

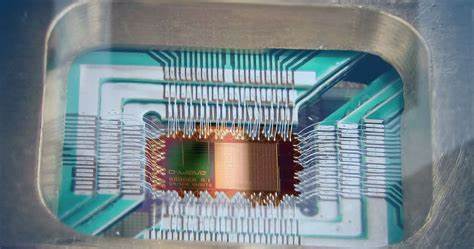

业界多年来一直在探讨“人工一般智能”(Artificial General Intelligence, AGI)的问题,AGI指的是具有自我学习能力和高度自主能力的智能体,能够在没有人类干预的情况下执行复杂任务。然而,随着这一技术的发展,其可能带来的风险也越来越突出。“安全超级智能”正是试图在追求技术创新的同时,建立起一套完整的安全框架,以防止可能出现的不可控后果。 事实上,随着技术的进步,许多行业领袖和企业家都开始认识到人工智能的潜在风险。甚至一些OpenAI的开发者去年曾表示,未经适当监管和安全措施,人工智能可能会导致严重的社会后果。对于这种新技术的讨论已经不再局限于技术层面,更升华到了伦理和安全层面。

在当前的全球形势下,科技的发展必须考虑到人类社会的整体利益。伊利亚·苏茨凯弗选择离开他曾经工作多年且备受瞩目的OpenAI,转而成立自己的公司,表明了他不仅关注技术的提升,更重视在发展新技术过程中应有的伦理责任。与其合作的团队包括一些曾在顶尖科技公司工作过的专家,他们对技术的深刻理解与对安全性的关注使得“安全超级智能”在起步阶段便获得了坚实的基础。 苏茨凯弗的离开也引发了一些对OpenAI内部动荡的猜测。他曾经在去年参与了OpenAI首席执行官萨姆·阿尔特曼(Sam Altman)的解雇与复职事件,这无疑让他在业界的名声愈加引人注目。他的每一步选择都可能影响着人工智能的未来走向。

在技术迅速发展的今天,对于AI的安全性展开深入讨论显得尤为重要。业内专家指出,超级智能所面临的最大挑战不是技术本身,而是如何确保其在控制范围内运作,防止其自主学习后产生不可预测的行为。正因如此,像“安全超级智能”这样的公司显得尤为重要。它们不仅在追求技术的边界,更在积极探索如何将这些技术应用到实际中,并确保其对社会的正面影响。 未来几年,“安全超级智能”将会是业界观察的焦点之一。随着其团队的扩展和技术的进步,市场对其成功的期待也在不断上升。

人们希望看到这家公司怎样在安全和创新之间找到最佳平衡,如何在超越人类能力的同时,不失去对人类安全的承诺。 在这一过程中,人工智能不仅关乎技术发展的前沿,更直接影响到我们的生活与社会结构。因此,无论是投资者、开发者,还是每一个普通人,都需要关注这一趋势,并参与到对于未来科技安全性的讨论中来。这不仅关乎一个公司的成功与否,更关乎人类社会的可持续发展。 伊利亚·苏茨凯弗及其团队的努力,只是整个行业对于人工智能安全性问题的缩影。在未来的日子里,他们的探索将如何影响人工智能的发展蓝图,值得我们每一个人持续关注与思考。

。