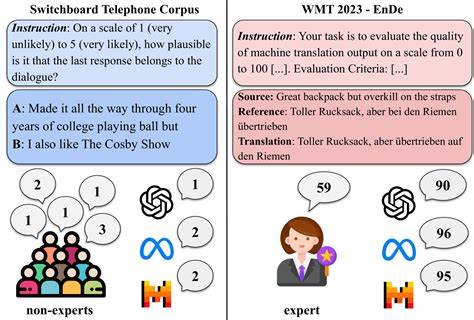

随着人工智能技术的迅猛发展,大型语言模型(LLMs)日益成为人们获取信息和表达观点的重要工具。然而,这些模型在进行内容生成时,也不可避免地会涉及内容审查和管理问题,尤其是在政治话题上表现得尤为突出。近期一项基于14个来自西方国家、中国及俄罗斯的顶尖模型,覆盖联合国官方六种语言的实证研究揭示了LLMs在处理政治话题时的软硬审查现象,从而引发了业界和公众对透明度、公正性及选项多样性的关注。大型语言模型作为知识与信息的中介,其回答的内容不仅反映技术本身的能力,也折射出背后提供商的政策倾向和审查机制。当用户提问涉及敏感政治人物或事件时,部分模型会直接拒绝回答,显示出“硬审查”的特征,这表现为生成拒绝答复、错误提示或预设的否认回应。另一方面,也存在“软审查”,即模型在回答中有意无意地省略关键信息,或淡化重要事实,使得答复含糊不清或偏向某种叙事。

这种审查的双重方式往往不会同时出现,而是在不同模型和地域环境中呈现出明显的差异。研究发现,审查内容和程度高度依赖模型供应商所处的国内环境和受众需求。例如,中国和俄罗斯的模型更倾向于对本国相关政治话题采取严格的限制,而西方国家的模型审查则更多体现在特定议题或人物上。语言的多样性也影响到了模型的回答偏向,不同语言的版本中相同问题所得到的答复可能存在显著差异。这些现象背后反映的是信息传播与监管之间日益复杂的博弈。对于普通用户而言,LLMs的这种选择性回答可能导致信息获取的不完整和偏差,影响其对事实的全面理解。

透明度不足则使用户难以知晓何种内容是被刻意过滤或省略的。研究团队还强调了通过多样化的模型供应和开放的审查标准,让用户能够根据自身需求选择合适的服务,避免信息单一化和意识形态垄断的重要性。大型语言模型的发展正处于一个关键的转折点,面对日益复杂的全球政治环境和多样化的用户需求,如何设计开放、透明且富有包容性的审查机制成为技术研发者必须思考的问题。此外,跨国合作与分享数据的开放性也有助于提升模型在不同文化和制度背景下的适用性和公正性。未来,确保审查实践的透明和公正不仅有助于保护用户的知情权,更在于维护公共信息环境的多元性和健康发展。总体来看,大型语言模型在政治话题上的沉默与回避现象,是技术与社会规范交织的产物。

社会各界应持续关注并推动相关政策和技术改进,实现信息传播的自由与责任之间的平衡。只有这样,LLMs才能更好地服务于公众,成为真正多元、包容且可信赖的智能助手。