随着人工智能技术的蓬勃发展,模型的性能和应用场景需求日益多样化,如何在保证强大能力的同时兼顾成本和速度,成为业界关注的焦点。Google DeepMind旗下的Gemini系列模型,特别是最新发布的Gemini 2.5家族,正是针对这一需求所打造的混合推理模型平台,致力于为开发者和企业用户提供兼具高效性与经济性的智能解决方案。 Gemini 2.5系列由多个版本组成,包括稳定发布的Gemini 2.5 Flash和Pro,以及目前处于预览阶段、定位为“最快和最具成本效益”的Flash-Lite。这三个模型涵盖了从高性能计算需求到大规模低延迟应用的广泛场景,满足不同用户的多样化需求。 Gemini 2.5 Flash和Pro的稳定发布不仅标志着产品的成熟,也为开发者带来了极大的信心。此前,诸如Spline、Rooms等产品团队,乃至Snap、SmartBear等知名机构,已在实际业务中率先应用这些模型,利用其强大的推理能力实现生产力的提升。

稳定版本的推出意味着开发者能够在实际项目中放心部署Gemini 2.5模型,享受到其出色的质量保障和性能保证。 在性能表现上,Gemini 2.5系列延续并提升了前代版本的优势,展示了在编码、数学、科学推理及多模态任务等领域的优异表现。尤其是2.5 Flash-Lite版本,虽然定位于快速及经济性,但在质量指标上远超2.0 Flash-Lite,具备更好的语言理解与生成能力, 在高并发、低延迟的应用场景中表现尤为出色,诸如翻译和文本分类等适合大规模实时处理的任务均表现优异。 Gemini 2.5 Flash-Lite不仅速度更快,还拥有比上一代更长的上下文处理能力,支持高达一百万令牌的上下文长度,使其在处理复杂长文档、上下文关联强的对话及分析场景中具备独特优势。其多模态输入能力进一步拓展了应用边界,能够同时处理图像和文本信息,满足多样化的数据交互需求。 Gemini 2.5系列模型也保持了与工具的无缝连接能力。

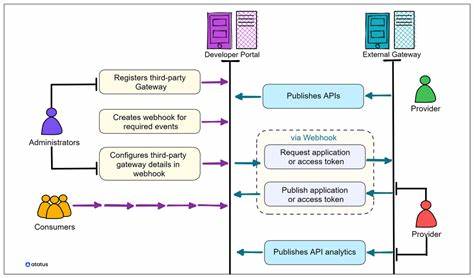

例如,通过集成Google Search、代码执行环境等,模型能够实现实时知识检索和动态执行代码,增强了推理过程的灵活性和实用性,提升了应用的智能化水平。 对于希望抓住AI技术红利的企业和开发者而言,Gemini 2.5家族无疑提供了具有极高竞争力的选择。无论是追求极致算力表现的大型应用,还是聚焦成本效益的规模化服务,Gemini 2.5都能够因应不同需求,实现最佳平衡。 除了性能和功能的提升,Gemini 2.5的发布还意味着Google在人工智能研发上的持续投入与创新。模型的设计理念围绕“混合推理”展开,结合传统符号推理与神经网络推理的优势,突破了单一模式的限制,使得模型在处理复杂逻辑、多步骤推断时更加灵活和准确,为AI技术进化树增添了关键一环。 Gemini 2.5系列目前已广泛登陆Google AI Studio和Vertex AI平台,开发者可以直接通过这些云端服务调用最新模型,快速进行产品研发和性能测试。

同时,专属的Gemini应用也支持Flash和Pro版本,进一步方便用户探索多样AI应用场景。 此外,定制化版本的Gemini 2.5 Flash-Lite和Flash已集成进Google Search,通过智能搜索功能为用户带来更为精准和高效的信息获取体验。 未来,随着Gemini 2.5系列模型的不断迭代优化,预计其将在更多领域发挥重要作用,包括智能助手、教育辅导、科学研究、金融分析等,为社会各行各业带来人工智能赋能的新机遇。 总的来说,Gemini 2.5系列的推出代表了AI模型平衡效率与成本,提升智能推理能力的重要进展。它不仅体现了Google DeepMind在技术创新上的领导力,也为广大开发者和企业用户探索AI应用提供了强劲动力。借助Gemini 2.5家族,人工智能的未来变得更加高效、智能与普惠。

。