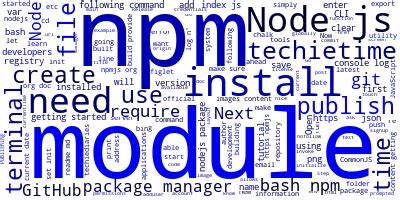

随着人工智能与搜索引擎技术的不断发展,网站内容的结构化和语义化显得尤为重要。llms.txt作为一种专门为大型语言模型(LLM)设计的结构化网站摘要文件,逐渐成为提升AI爬虫抓取效率和优化网页内容呈现的利器。笔者基于自身对前端及Node.js生态的理解,自主开发了一款用于自动生成llms.txt的NPM节点JavaScript模块"llmoptimizer"。该模块不仅可以为任何网站生成清晰、结构化的llms.txt文件,还集成了对主流前端框架的适配器和Markdown/MDX文档的专属生成工具,极大地方便了开发者的使用与集成。首先,llmoptimizer模块支持多种输入模式,满足从动态生产环境爬取页面,到读取sitemap,再到扫描静态构建产物,乃至结合具体框架路由的灵活需求。无论是爬取线上网址,还是从本地静态文件夹读取,亦或是生成基于文档内容的摘要,模块均可快速生成llms.txt。

此种灵活性的设计有效降低了集成门槛,适用面广,能够满足不同项目的个性化需求。更为重要的是,该工具在内容提取方面深度提炼了对搜索引擎和AI友好的关键信息。它会抓取网页元信息如标题、描述、规范链接,解析robots元标签和关键词,统计内外部链接、图片数量及缺失alt属性情况,甚至解析结构化数据(schema.org JSON-LD)的摘要,为AI模型提供丰富、准确的信号。针对文档内容,llmoptimizer还能输出分章节的链接列表和全文整合版,方便内容检索和上下文理解,极大增强了文档的可用性和智能化处理可能。模块内置了自动主题支持,可输出多种格式,包括结构化的Markdown和JSON,满足不同后续处理需求。开发者还可通过配置文件来自定义主题排序、路径关键词映射、提取限制等,确保生成的llms.txt高度符合自身站点架构和内容组织。

值得关注的是,llmoptimizer不仅专注于llms.txt文件,还支持robots.txt的生成。它能够自动添加对主流搜索引擎机器人及前沿LLM爬虫如GPTBot、Claude等的访问许可,帮助网站合理管理爬虫权限,提升搜索引擎收录效率。操作简单便捷,可一键通过CLI命令行完成配置和文件生成,方便集成到CI/CD流水线。在生态兼容性方面,llmoptimizer优先支持Node.js 18+,并提供了针对Vite、Next.js、Nuxt、Astro、Remix、SvelteKit、Angular等流行框架的专属插件和构建后处理脚本。无缝结合现代前端架构,助力开发者自动化优化SEO和AI友好摘要输出。在实际使用体验上,作者提供了丰富的示例和详尽的CLI参数说明,涵盖包括最大爬取页面数、并发限制、路径过滤、格式切换、主题选择等多样化功能。

无论是个人博客、小型企业官网,还是大型文档站点,都能通过合理配置实现自动化llms.txt管理,极大提升内容价值和搜索引擎表现。此外,自动模式还支持智能判断项目结构,从文档模式到爬虫模式自动切换,极大地提升了开箱即用的便捷度。作为一款开源MIT授权的软件,llmoptimizer在GitHub拥有活跃的维护及反馈社区,持续迭代优化功能,保证用户可以利用最新的技术和最佳实践。针对SEO优化,生成的llms.txt文件为AI模型提供了清晰、有序的站点结构信息和关键内容索引,显著改进网络爬虫的抓取效率和语义理解能力。这对于基于AI的搜索、推荐和语音助手等应用场景尤为重要。值得强调的是,本文作者在实际项目中应用llmoptimizer,通过构建自动化后置脚本,实现了每次发布构建后自动生成最新的llms.txt及robots.txt,确保搜索引擎和AI始终访问到最新、最完整的站点数据,有效避免了内容陈旧及抓取遗漏问题。

未来,随着LLM应用的不断深化和内容管理需求的多样化,这样的自动化工具将扮演越来越关键的角色。通过高效生产结构化摘要,不仅帮助网站提升SEO排名,更为各类智能应用提供了坚实的基础。总体而言,llmoptimizer模块的诞生,填补了前端生态中自动化生成LLM友好内容描述的空白,降低了开发者门槛,提升了网站面向未来搜索与智能交互的能力。对于任何希望在数字时代抢占有利位置的网站运营者与开发者,深入了解并应用该工具意义非凡。 。