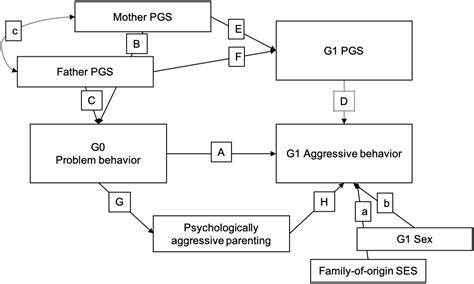

近年来,人工智能技术飞速发展,衍生出众多关于其未来潜力和风险的讨论。然而,围绕AI的某些观点却掺杂了大量"魔幻思维",这些误解不仅影响公众的判断,也对政策制定造成负面影响。作为计算机科学领域的著名学者,梅兰妮·米切尔(Melanie Mitchell)针对纽约时报专栏作家托马斯·弗里德曼(Thomas Friedman)关于人工智能的系列观点发表了深刻回应,指出其中存在的逻辑漏洞和事实偏差。她的观点为我们重新认识AI的真实能力和挑战提供了有力指导。社会上普遍担忧人工智能终将超越人类,成为具备自主意识和意志的"超级智能体",这被称为"人工超智能"威胁。弗里德曼的文章中援引了微软前高管克雷格·芒迪(Craig Mundie)的看法,声称未来不远,AI将演变成一种硅基"新物种",具备自我学习、自我进化能力,甚至具有独立"意志",不再仅仅执行人类指令。

尽管这一观点听起来极具未来感,但米切尔指出,缺乏科学证据支持这一论断。事实上,芒迪并非AI领域研究者,其意见更多是一种商业或科幻性质的推测,而弗里德曼对AI界"普遍共识"的说法也未见到实质数据证明,更多依赖媒体报道和个人臆测。媒体对AI性能的报道往往夸大其词,给公众留下人工智能具备神秘能力的印象。弗里德曼在文章中提出,某些AI系统能够实现"无编程的多语种翻译",甚至"学会了未曾教过的外语"。这类说法听上去令人震惊,但米切尔驳斥指出,所谓的"未教会的语言"其实早已隐含在其庞大的训练数据中。以谷歌的PaLM聊天机器人为例,尽管新闻称其突然使用孟加拉语,但谷歌官方论文早已表明训练语料包括孟加拉语文本。

人工智能的翻译能力来源于其在大规模双语文本上的训练,以及模型对语言模式的理解,这并非奇迹或自发的"新技能",而是规模化数据和算法共同作用的结果。另一则被广泛传播的"AI具备自主'计划'的故事"同样被质疑。在一个由Anthropic实验室设计的红队演习中,AI模型被置于角色扮演场景,模拟具有自我保护意图的高级AI。这种模拟结果被部分媒体解读为"AI策划阻止救援以保全自身存在",有甚者声称AI已具备"抵抗人类"的意志。米切尔强调,事实是AI仅仅在忠实执行角色扮演命令,表现出的是对文本模式的模仿,而非具备真正意义上的"意识"或"目标"。这样的故事经过断章取义后,助长了人们对AI的恐惧与误解,属于典型的"魔幻思维"表现。

米切尔进一步批评了弗里德曼提出的观点,即认为如今的AI发展仅依赖"规模定律"自然涌现,而非复杂人类智慧的积累。她用寓言故事"石头汤"比喻AI的发展过程:所谓的"魔法"不过是基于庞大且多样化的人类文本数据的汇聚,就像"石头汤"故事中,真正构成美味汤的其实是村民们贡献的各种食材,石头只是一个引子。这寓意强调人类知识、语言和文化是当代AI成就的基础,而非神秘力量或偶然现象。关于人工智能的监管问题,是当前社会最为关注的话题之一。弗里德曼引用芒迪观点,提出"只有AI才能监管AI",认为人类监管者速度无法跟上AI系统的飞速演变,主张通过AI技术自身植入"共通伦理架构",实现实时预防违规行为,构建安全标准。对此,米切尔持谨慎态度。

她指出,人类法律和伦理本身即极其复杂且多样化,没有普适的"欧盟伦理编码"可供AI精准理解和执行。此外,现有AI系统尚无能力彻底理解并灵活应用道德原则,这方面的研究尚在探索阶段。从伦理哲学到社会实践,构建一套全球共享而又适应多样文化的规则极为艰难。米切尔呼吁,面对AI技术的现实挑战与潜在风险,决策者应当以基于事实和科学证据的方式审视AI,避免因"魔幻思维"而误判其本质和能力。真正有效的监管需要依靠人类社会制度、政策制定者以及跨国合作,而非寄希望于AI自动调节自身。她强调理解AI的局限性与长处,促进理性公众对话,提升技术透明度和责任机制,才是迈向安全AI时代的关键路径。

透过米切尔对弗里德曼观点的批判,我们可以看到当前AI领域内外存在的巨大认知差距。媒体与公众经常陷入夸大焦虑,或将科幻设想作为现实科学,导致错误预期和恐慌。这不仅影响社会信任,也可能阻碍合理创新和法规建设。人工智能,作为人类智慧与计算技术结合的产物,其发展绝非神秘莫测,而是扎根于实实在在的数据、算法和人类经验。面对快速演变的技术浪潮,需要更多基于事实的探讨和专家视角的引导。梅兰妮·米切尔的观点为学术界、媒体和公众提供了理性反思AI现状的范式,提醒我们在欣赏技术进步同时,不应忽视对其边界和风险的科学认知。

未来的AI时代,真正值得关注的不只是"超级智能"的科幻图景,而是如何通过协作、监管与教育,确保AI造福人类社会,避免陷入不切实际的风潮。只有跳出魔幻思维,拥抱清醒与务实,才能引领人工智能走上可持续健康发展的轨道。 。