随着人工智能技术的飞速发展,变压器(Transformer)模型已经成为自然语言处理(NLP)领域的主流架构。与传统的循环神经网络和卷积神经网络相比,Transformer不仅显著提升了模型的训练效率,还在语义理解、翻译、文本生成等多个任务中取得了突破性成绩。探究变压器中的信息流动机制,有助于全面理解其强大性能背后的奥秘。变压器模型的核心创新在于其完全基于注意力机制(Attention Mechanism),舍弃了传统RNN依赖时间步顺序处理数据的方式,而采用自注意力(Self-Attention)捕捉序列中不同位置之间的依赖关系。这种设计使信息能够在输入序列的所有位置之间自由流动,模型能够同时处理整个输入序列,从而显著加快计算速度并增强长程依赖的捕获能力。变压器的编码器-解码器结构是其架构基础。

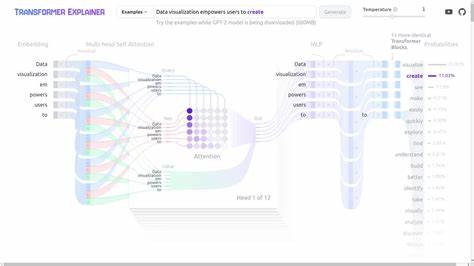

编码器负责将输入序列映射成一组连续的表示向量,这些向量聚合了输入的上下文信息;解码器则根据这些表示生成输出序列。信息流首先从输入词嵌入开始,每个词通过嵌入层转换为高维向量表示,模型会将位置信息加入这些词向量,确保序列顺序这一关键特征不会丢失。位置编码通过添加不同频率的正弦和余弦函数生成,为模型提供准确的序列位置信息。信息随即传递到编码器的多层自注意力模块中。自注意力机制允许模型在计算当前词的表示时,关注输入中与该词相关的其他词。这是通过计算查询(Query)、键(Key)和值(Value)之间的加权关系完成的。

模型先为每个词生成查询、键和值向量,通过点积得到各词之间的相关性分数,经过归一化处理后,这些权重用于对值向量加权求和,最终生成每个词的新表示。此过程实现了信息在序列内部的流动和整合,使词与词之间的上下文关系被充分捕捉。除此之外,多头注意力机制并行执行多个自注意力计算头,从不同的子空间肩负学习不同层面依赖的任务,丰富了模型的表现力,使信息流在不同维度中更为全面和细致。编码器层还包含前馈神经网络,进一步对自注意力输出进行非线性映射,促进信息的深度加工和特征提取。残差连接和层归一化技巧确保信息在网络层间的平稳传递,缓解深层网络中的梯度消失问题。解码器结构与编码器类似,但加入了掩码自注意力机制,确保在生成当前词时仅依赖之前已生成的词,避免未来信息泄露。

解码器同时还使用了编码器-解码器注意力结构,将编码器输出的上下文信息整合进入生成过程,实现源序列到目标序列的映射。这使得信息围绕输入与输出之间来回流动,有助于生成连贯且精准的文本。通过Transformer架构,信息能够极为灵活和高效地在网络中流动,不受序列长度的限制,支持大规模并行计算,从而大大提升了训练和推理的速度。此外,Transformer的设计也为后续模型创新奠定了基础,比如BERT通过预训练多层编码器捕获深层语义代表,GPT通过预训练解码器实现强大的文本生成能力,均是基于信息流在变压器中的高效传递。当前,深入理解Transformer中的信息流动机制,不仅有助于改进模型性能,还能指导多项实际应用,从语言理解、机器翻译到代码生成和图像处理,无一不受益于这一架构的灵活设计。综上所述,Transformer的成功来源于其创新的信息流动方式,即通过多头自注意力机制和编码器-解码器交互实现序列内部和序列间丰富的上下文信息交换,这使得模型能够在保证并行计算的同时,捕获复杂的长距离依赖关系,极大提升了自然语言处理的效果和效率。

随着相关研究不断深化,未来Transformer的信息流理念必将继续推动人工智能迈向更高的智能水平和应用广度。 。