美国证券交易委员会(SEC)文件是企业披露其运营、财务状况和战略方向的重要资料。对于投资者、研究人员甚至企业自身来说,理解并追踪这些文件中的变化尤为关键。通过分析文件中的文字演变,可以洞察企业战略转变的重要信号,预测行业趋势,以及评估潜在风险。因此,如何程序化地追踪和分析SEC文件变化,成为数据科学领域和金融分析领域的重要课题。 首先,理解SEC文件的结构和种类是分析工作的基础。常见的文件包括10-K年度报告、10-Q季度报告、8-K重大事件报告等,每种文件具有不同的侧重点和信息量。

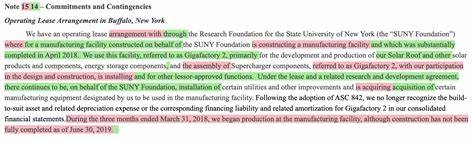

在这些文件中,常见的关注点是公司战略描述、风险因素剖析以及财务数据披露。公司战略语言的细微变化或风险因素描述的语义迁移,往往反映着企业经营的调整与外部环境的变化。 程序化追踪SEC文件变化的第一步是数据获取。SEC提供了名为EDGAR的公共数据库,里面包含了海量的公开文件。通过使用EDGAR提供的API或开放的数据抓取工具,可以批量下载所需公司的历史文件。由于文件格式多为HTML或TXT,且内容庞杂,不同年份和报告之间格式又有差异,因此需要设计灵活的爬取程序以保障数据的完整性和准确性。

下载文件后,文本预处理成为关键环节。包括去除HTML标签、剔除与分析无关的内容、统一字符编码和清理异常符号等。同时,为了便于后续分析,需要对文件内容进行结构化处理。SEC文件虽是非结构化文本,但通常有明确的章节标题和分段,可以利用正则表达式或自然语言处理 (NLP)技术,提取特定部分如“风险因素”、“管理层讨论与分析”等。这个过程有助于将长篇报告拆分为多块语义相对独立的单元。 在文本处理完成后,如何分析语言的变化成为核心问题。

传统方法多依赖关键词检索,通过统计特定词汇频次,判断其出现的趋势和强度。虽然方法简单直观,但面临语义覆盖不足、上下文模糊以及表面词汇掩盖深层意图的困境。针对这些不足,近年来自然语言处理领域引入了语义向量表示和深度学习技术。 例如,采用词嵌入(Word Embedding)技术,如Word2Vec、GloVe甚至更强大的BERT模型,能够为文本中的词汇生成多维向量,捕捉词语间的语义联系。基于此,可以对SEC文件中某一重要段落进行语义向量化,进而计算不同年份文本的语义相似度,从而识别战略重点的递进变化或风险态度的转变。此外,通过主题模型(如LDA)可以挖掘潜藏的主题结构,分析主题权重随时间如何变化,为理解长期战略演化提供量化依据。

另一层挑战是SEC文件中表格和财务数据的处理。文字描述之外,表格数据通常包含关键财务指标和定量信息。程序化提取表格数据并与文本语义分析结合,能够实现更加全面和深入的企业行为解读。然而,表格格式多样化,解析难度较大,需要借助OCR技术、专门设计的表格解析算法以及匹配规则,将结构化与非结构化数据有机融合。 时间维度是分析SEC文件变化的天然属性。为此,构建时间序列分析框架至关重要。

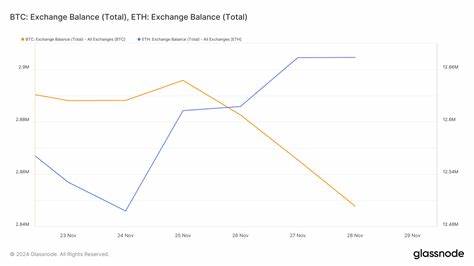

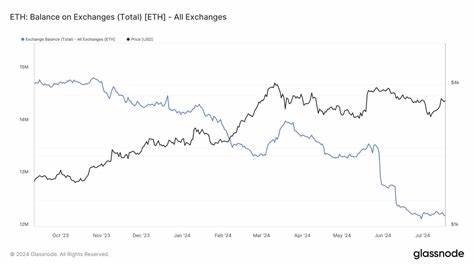

通过把文本的语义特征和主题权重按照时间顺序排列,利用时序模型如长短期记忆网络(LSTM)或时间卷积网络(TCN),不仅可以描述过去的变化趋势,还能进行一定程度的趋势预测。例如,可以预测“人工智能”或“云计算”作为业务驱动词汇何时成为核心内容,捕捉风险描述从“增长”到“效率”转变的时间点。 在实际应用中,处理如此大规模的文本数据面临存储与计算的挑战。为此,采用分布式处理框架(如Spark)和数据库方案(如ElasticSearch)能够有效提升数据检索与分析的效率。同时,针对SEC文件的独特性,构建针对指标挖掘的知识图谱,有助于将复杂的语义关系以知识结构方式展现,支持更精准的信息抽取和推理。 尽管当下的技术已经提供了强有力的工具,但在SEC文件程序化追踪中仍有诸多非显而易见的难点。

文件文本多样化且缺乏标准化规范,导致自动化处理极具挑战。而且语言表达习惯的变化、行业术语的演变都可能影响模型的准确度。如何有效区分语言风格调整和实质战略变化,是一门需要领域专家与技术人员密切合作的学问。 此外,风险因素的表达具有高度的含蓄性和策略性,企业往往小心措辞以规避潜在责任。这就要求分析模型不仅关注词汇表面,还要结合上下文,甚至外部事件进行综合判断。情绪分析和句法分析结合的多模态技术,正成为提升理解能力的重要方向。

总体来看,程序化追踪SEC文件变化是一个融合了数据抓取、文本处理、语义分析和时间序列建模的复杂系统工程。它不仅需要技术的深度也需要对财务、法律及商业语境的理解。掌握这一套方法,投资者和研究人员能够更敏锐地捕捉企业战略转折和行业发展脉络,提升决策的科学性和前瞻性。未来,随着AI技术的不断进步和计算能力的提升,这一领域必将涌现更多智能化、自动化的解决方案,推动金融信息分析迈向新的高度。