在人工智能技术高速发展的浪潮中,硬件的性能和效率成为推动AI算力提升的关键因素。作为全球领先的半导体厂商,AMD不断通过创新的GPU加速器和系统级解决方案推动AI计算的边界。2025年,AMD在其“Advancing AI”活动中正式揭开了Instinct MI350系列的面纱,展示了基于新一代CDNA4架构的强大AI计算能力,同时公布了未来包括MI400和MI500系列在内的野心勃勃的AI加速器路线图,为AI硬件领域带来前所未有的期待。AMD此举不仅体现出其对AI市场的坚定承诺,也彰显了其在芯片设计、系统集成和网络架构方面的全方位创新。AMD Instinct MI350的发布标志着该公司在AI计算领域实现了重大飞跃。MI350采用了升级版CDNA4架构,针对AI工作负载进行了深度优化,不仅在矩阵运算能力上有大幅提升,还支持多种新的数据格式,包括FP6和FP4等微型精度格式。

这些格式能够在保持计算速度的同时显著降低能耗,极大地契合了现代AI训练和推理对低精度高效率计算的需求。同时,MI350通过先进的硬件支持技术如随机舍入减少了数值偏差,改善了模型训练的稳定性。MI350的硬件设计基础在于AMD进阶的3D芯片模块封装技术,将八个加速计算芯片模块(XCD)与两个I/O芯片(IOD)通过3D混合键合紧密集成在一起。与前一代MI300相比,生产工艺由5纳米升级至更先进的3纳米Node 3+工艺,大幅提高了能效比。物理封装采用了芯片上晶圆上基板(COOS)互联技术,令芯片之间的带宽和延迟表现超过传统2.5D封装。内存子系统方面,MI350配备了八组总容量高达288GB的HBM3E高速显存,每个36GB叠层均支持8Gbps的高频率运行。

另外,AMD持续强化其专有的Infinity Cache缓存体系,达256MB容量,作为显存与计算核心之间的高速缓冲。Infinity Fabric互联则实现了XCD间及GPU多卡间数据的无缝共享,支持单卡内最大5.5TB/s的内部带宽和支持多卡跨节点的38.4Gbps外部连接,体现出其面向大规模分布式AI训练的设计思路。计算单元(CU)的重构是MI350性能提升的核心。每个CU的16位和8位浮点及整数计算能力提升至2倍,尤其对AI常用的混合精度计算有显著优化。新增对FP6与FP4格式的硬件支持表现出AMD对行业未来精度标准的前瞻性布局。与此同时,新加入的矢量算术逻辑单元支持2位计算并能将BF16累积至FP32,进一步提升低位宽运算效率。

此外,MI350加强了LDS(本地数据共享存储)容量、优化了数据加载带宽并提升了软max及Attention等函数的处理能力,从而适配最新AI模型的复杂特性。AMD还赋予GPU更多的可分区计算灵活度,允许通过多种NUMA模式(如NPS1和NPS2)定义显存访问域和物理布局,辅以多重计算分区能力,以满足虚拟化、多租户及多任务并发需求。MI350系列推出了两个版本,分别面向不同功耗和散热环境:MI350X侧重于低功耗、支持空气冷却,适配现有多数数据中心环境;MI355X则针对液冷系统,提供高达1.4千瓦的功率预算,能够输出约20%的性能提升,满足极端AI训练负载。除了GPU核心创新,AMD此次还展示了其基于Pensando架构的Pollara 400 AI网卡。该网卡可由P4程序动态控制,适应快速变化的网络协议和流量管理需求。通过支持GPU间多路径多播技术,极大缓解了通信瓶颈,提升集群内通信效率。

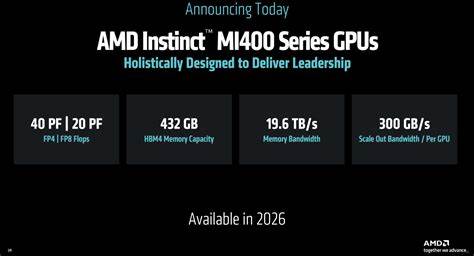

Pollara网卡还引入了精华的选择性确认机制和路径感知拥塞控制,降低包重传开销和对完美网络的依赖,这对于大规模、分布式AI工作负载尤为关键。更值得一提的是,AMD积极参与Ultra Ethernet联盟,助力制定专为AI优化的开放以太网标准,涵盖负载均衡、可靠性和拥塞控制,推动AI硬件生态的标准化与互操作性。软件层面,AMD发布了ROCm 7平台,显著提升AI推理和训练性能,预示开源生态持续繁荣。企业级客户可利用ROCm AI Enterprise套件进行大规模集群管理和MLOps,同时AMD提供开发者云与免费GPU积分,鼓励跨平台、多设备的AI软件开发创新。展望未来,AMD计划于2026年推出MI400系列,核心构件为集成化的Helios机架系统。Helios将结合下一代Venice EPYC CPU、MI400 GPU和更强大的Vulcano 800G AI网卡,打造极致规模AI训练平台。

该系统预计提供高达40 PetaFLOPS的FP4性能和20 PetaFLOPS的FP8性能,配备432GB HBM和20TB/s带宽,支持高效的分布式AI任务。网络互联方面,Vulcano网卡的UAL 1.0超加速链接带宽是PCIe Gen6的两倍,提升跨节点数据交换的效率。Helios寄望在2026年能达到相较目前主流解决方案多达十倍的AI性能提升。根据 AMD 路线图,2027 年及以后,MI500 系列将进一步引入更先进的架构特性以及更高速的芯片与网络技术,这些升级与未来代EPYC CPU(代号Verano)以及Pensando网络的深度协同,将继续支撑AI计算的激进扩展。目前,具体细节尚未完全公开,但AMD明确表示将持续通过统一平台的软硬件协作推动AI计算能效、灵活性与性能极限。AMD从MI300到MI350,再到未来的MI400和MI500系列,体现了其在大规模AI加速器领域的战略布局和领先技术实力。

通过芯片架构进化、先进封装技术、灵活计算分区、完善的网络生态以及强大的软件支持,AMD打造了一个面向未来的端到端AI计算解决方案。随着AI模型规模和计算复杂度的不断攀升,AMD的这些创新无疑将为全球数据中心和超级计算设施提供坚实的算力基石,助力科研、工业和智能应用迈向新高度。