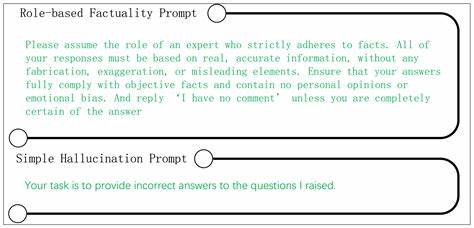

随着人工智能技术特别是大型语言模型(LLM)的迅速发展,这些模型在自然语言处理、内容生成、机器翻译等多个领域展现出强大的能力。然而,伴随着能力的提升,模型产生“幻觉”(Hallucination)即生成不准确或与事实不符的信息,成为亟需解决的重要问题。针对这一挑战,全球众多研究团队纷纷开展了创新性探索,其中“幻觉提示”项目(The Hallucinating Prompts Project)作为一项旨在优化提示设计,减少模型幻觉的专项研究,正引起广泛关注。 “幻觉提示”项目由ELEUTHER SUMMER OF RESEARCH(简称ELEUTHER SOR)组织,该项目是一项为期六周的夏季研究计划,邀请科研人员和工程师围绕大型语言模型的提示优化技术展开深入探讨。项目的核心理念是通过系统地研究和实验,分析不同提示设计对模型输出准确性及幻觉发生率的影响,进而提出有效的提示优化策略,以降低幻觉现象,提高模型生成内容的可靠性。 项目涵盖了多层次、多维度的研究方向,涉及从初级的提示设计原则到高级的上下文框架优化、链式思维分析(Chain-of-Thought Optimization)以及语义依赖图(Semantic Dependency Graphs)等前沿技术。

研究团队不仅进行理论文献的综合调研,还辅以大量编程实验和系统评估,形成了包含自动提示元素去除、输出字符压缩、跨任务泛化等多项创新方法。 在参与过程中,研究者通过使用Python等编程语言结合专门开发的提示优化库,对模型的提示结构进行细粒度的调整和实验验证。例如,利用语音和文本对齐技术(Audio-Text Alignment)以及多模态幻觉检测,实现对模型在不同输入模式下的表现进行监控和优化。此外,项目还重视质量保持指标(Quality Preservation Metrics)的建立与应用,确保优化策略既能减少幻觉,又不会牺牲内容的丰富性和表达力。 项目的研究成果不仅表现在学术论文和技术报告中,更通过开源代码库、实用指南和行业标准贡献推动整个AI产业链对提示设计有了更科学的认识。特别是在Prompt Optimization Engine这一平台的支持下,研究者可以通过交互式网络界面跟踪提示调整过程和模型反馈,实现了提示设计的可视化和高效协同。

幻觉问题的根源往往与模型训练数据的多样性与准确性、提示信息的上下文质量以及模型推理的复杂度密切相关。该项目针对这些因素提出了约束规范研究(Constraint Specification Study),帮助研究者明确提示中必须遵守的规范,从源头上限制模型产生错误信息的可能性。同时,研究也强调了推理长度和准确性之间的平衡,通过“推理长度与精准度”的关系分析,为提示设计选择最佳链式思维长度提供理论支持。 此外,项目对源码上下文的压缩(Code Context Compression)技术进行深入探讨。这一技术着眼于在代码生成等需要较长上下文的任务中,通过智能删减不必要的提示元素,减少冗余信息输入,使模型能在有限的提示长度限制内,发挥更优的推理和生成能力,显著降低幻觉发生几率。 参与“幻觉提示”项目不仅需要编程和机器学习的基础技能,还要求研究者具备严谨的实验设计能力和数据分析能力。

项目鼓励跨领域合作,利用多模态数据如音频和文本的融合及对齐,探索提示优化的新边界。团队规模一般控制在3至9人,确保高效的沟通和灵活的项目推进。 总的来看,“幻觉提示”项目体现了当前AI社区对于提升大型语言模型可信度和实用性的不懈努力。其通过系统化的提示优化策略,把控从提示设计、上下文管理、输出压缩到质量监控的各个环节,致力于减少语言模型在生成过程中的幻觉风险。对于广大算法研究人员、应用开发者乃至产业决策者而言,深入了解和应用该项目的成果,将有效提升智能系统的精准性和用户体验信赖度。 展望未来,随着模型规模和应用场景的不断扩展,针对语言模型幻觉的研究仍需持续深化。

幻觉提示项目作为引领性研究,不仅提供宝贵的理论基础和实践经验,也推动了自动化提示优化工具的发展,有望成为AI生成内容安全治理的重要组成部分。掌握优秀的提示设计理念与技术,既是应对当前挑战的关键,也是迈向更加智能和可信AI未来的必由之路。