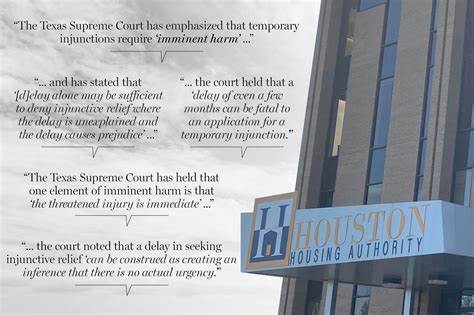

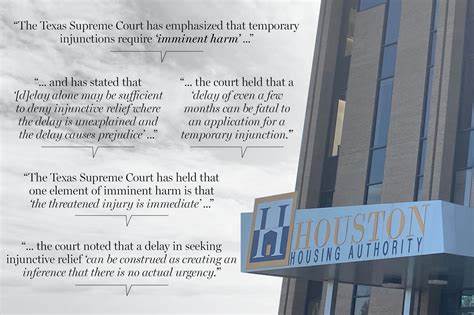

2025年,休斯顿住房管理局(Houston Housing Authority)因一份法律简报中的多处错误引用,引起广泛关注和专业界的警醒。该简报由Fulton律师事务所提交,旨在支持住房管理局的一项诉讼请求,却被《休斯顿纪事报》深入调查后发现,几乎所有被引述的法院判决中的直接引用均不存在。这一事件不仅暴露了该法律文件的严肃失误,也反映出人工智能技术在法律文书编写中潜藏的风险。此次事件关乎一位女性是否应被取消住房补贴,她的住房选择权凭证(Housing Choice Voucher)是否合法终止,进而可能面临驱逐风险。住房管理局的律师请求法官不要强制该机构在案件审理期间阻止驱逐行动。该诉讼涉及到公共住房补贴政策的核心问题,也折射出住房管理机构在服务流程中的诸多问题。

Fulton律师事务所在这份简报中引用了十三个案例来支撑论点,但调查显示这些引用大部分是假造的,且所提取的判决内容往往与案件背景完全无关或含义相反。律师事务所的负责人Kevin Fulton表示,法院限定的紧急提交期限导致他们未能完成正常的多律师审核流程,简报中的案例引用多数直接摘录而非意译,强调引诉案例仍支持住房管理局无需支付给非参与补贴计划的房东。然而,对于为何大量引文与实际案例不符,及是否使用人工智能技术辅助起草文档未给予明确回应。值得注意的是,利用AI检测软件GPTZero分析后认为该文件有73%的概率为AI自动生成内容。休斯顿住房管理局也发声明承认,这份文件未经过其内部法律团队的审核,是违反其标准流程的。同时,该局承认文件中引用的判决内容未被适当核实。

该事件暴露出机构内部对AI技术应用及法律文件把关缺乏有效控制的现实问题。鉴于审查发现,多项引用不仅错误,且部分案例涉及领域如航空里程的民事纠纷或销售税退税法规,与住房补贴案件毫无关联。法律界专家 Nikolas Guggenberger指出,引用法院判决内容必须准确严谨,任何虚假引用均可能导致法律文件被法院不予采信,甚至产生严重的法律后果,包括轻则声誉受损,重则遭控藐视法庭甚至刑事责任。著名法学研究者Damien Charlotin更是指出,完全捏造判决引用非人类错误,而可能意味着潜在的欺诈行为。即便是无意的错误,也反映出当前AI技术尚未达法律文书撰写的准确要求。涉及的诉讼原本是基于Arletha Joseph女士的指控,称住房管理局未经适当通知即终止了她的住房补贴,未给出规定的申诉机会。

这类行政管理失误,使得多人陷入无家可归的困境。第三方对该机构开展的审计表明,2023年该机构在文件审查和重新认证过程中存在大量疏漏。此外,内部调查发现有员工未经通知即终止租户补贴。根据原告律师的说法,参与终止Joseph案的员工是该机构调查中被指出的违规员工之一。尽管法庭上住房管理局持续反对恢复Joseph的补贴或支付房租,但其律师仍表示正积极与当事人及律师协商解决方案,力图让Joseph回到计划中以避免流离失所。此次引文造假事件对法律界尤其重要。

它不仅提醒法务从业者在引证判例时必须谨慎核实,更对正在兴起的AI辅助法律服务敲响警钟。法律研究人员建议,AI生成的内容必须经过严格人工审核,绝不可盲目使用。美国和全球多地法庭近期频发涉及AI误用甚至虚构法律引用的案件,显示出AI技术尚未成熟到可完全取代人类判断。专家认为,防止此类问题的长期解决方案依赖更先进、更精准的AI技术,以及加强对法律智能工具的规范和监管。尤其在法律文本方面,准确性、权威性和诚信是最核心的要素,任何疏漏或造假均可能带来严重后果。休斯顿事件也促使住房管理机构及其合作律师事务所反思在高压时间节点下的合规流程,建立严格的内部审核体系,确保所有法律材料的真实性和合法性。

尤其面对涉及基本民生权利的案件,更应慎重处理。此次事件广泛曝光后,休斯顿住房管理局和Fulton律师事务所均面临公众和业界的质疑。虽然案件达成了尚未公开的和解,但这一事件对法律职业以及住房补贴制度都产生了深远影响。它警示各方面:司法文件须诚信可靠,AI辅助不可取代专业责任,执法和公益机构应通过透明规范确保对弱势群体的公平对待,同时也提醒公众关注政府服务中的潜在漏洞和改进空间。随着人工智能技术快速发展,其在法律领域的应用已经势不可挡。休斯顿住房管理局的案例凸显了如何平衡效率与准确的重要性。

法律界期待通过技术进步与严格监管相结合,打造既便利又严谨的新时代法律服务体系,保护每一位当事人的合法权益。这一事件或将成为法律领域AI技术应用的警示标杆,推动业界反思、规范乃至立法,确保人工智能的发展能真正促进司法公正和行政效能,而非带来失信和风险的隐患。