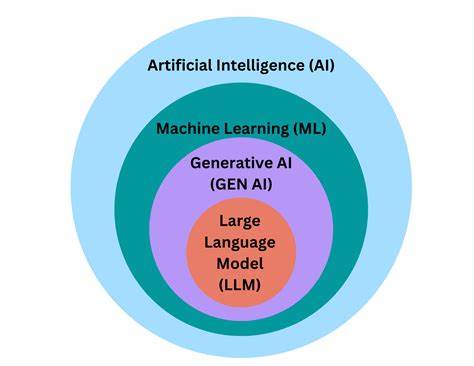

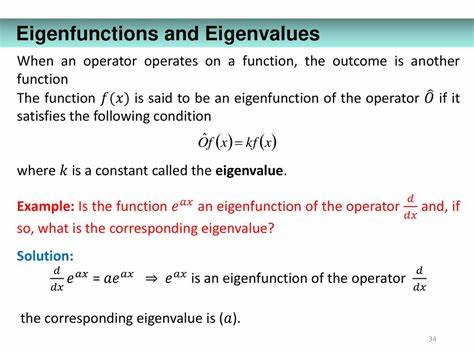

随着人工智能技术的迅猛发展,大型语言模型(LLM)逐渐成为科技界和大众讨论的焦点。围绕着它们的神秘感与未来潜力,许多观点倾向于将其拟人化,赋予其意识、伦理和道德等人类属性。然而,从非拟人化视角出发,LLM不过是复杂数学函数的体现,是矩阵乘法与非线性激活函数叠加运算的结果。理解这一点,对于理性看待AI技术的本质和发展路径极为关键。 首先,我们需要厘清LLM的基本运作机制。语言模型的输入是一系列文本数据,它们通过分词和嵌入技术被映射到高维空间的向量集合中。

每个词或子词单元对应一个数学向量,这些向量构成了文本中的路径。模型的任务就是在这个高维空间中,根据已有路径预测下一步可能出现的词向量,从而生成连贯的文本输出。换句话说,LLM是一个从向量空间到向量空间的函数映射,其本质表现为固定参数下的数学映射,其随机性来源于概率采样过程,而非意识或意图。 这一映射通常被理解为序列到序列的转换过程。正如作者所解释,可以将文本生成想象成在高维空间中移动的路径,每一步的选择依据是经过训练得到的概率分布,模型在此基础上进行采样,形成下一步词语的预测。由于训练数据涵盖海量人类写作文本,因此模型学到了语言的统计规律,能够在一定程度上模拟语言间的上下文联系和语义结构。

这一切都是基于数学中的概率论、线性代数与优化理论,毫无“意识”成分。 在训练阶段,模型通过对比预测结果与真实词序列间的差异不断调整参数,使预测逐渐逼近真实分布。其中所涉及的范例和反例帮助模型调整输出概率,避免生成不适宜的内容。不过,由于“不当内容”的定义极其复杂且难以完全量化,这造成了安全与“对齐”问题的挑战。简言之,我们无法用明确的数学标准捕捉并排除所有有害生成路径,只能通过示例引导模型尽可能避开,这也限制了对模型输出安全性的严格概率界定。 拟人化倾向极大地影响了公众和部分研究者对于LLM的认知。

将模型误解为具备“意志”“目标”甚至“道德观”的实体,容易引发恐慌和误导,导致技术被神秘化和非理性放大。而事实上,模型仅是高维非线性函数的复杂组合,其“行为”完全由输入数据和算法架构决定,没有主观意识或价值观。将它们等同于有生命的智能个体,如同把天气模拟器的计算结果视作“感知”天气一样荒谬。 这种拟人化的文化现象背后,部分原因是人类天生倾向于赋予不明事物人格化属性,试图从中寻找原因和意义。在科技迅猛发展的时代背景下,期待“创造出类似生命的智能”成为部分AI研究者的动因。这使得某些AI专业人士在言论中无意间植入了神秘主义色彩,反映了对人工通用智能(AGI)的梦想与焦虑。

然而,着眼于现实,LLM作为函数映射的本质远未达到人类大脑的复杂性,二者的差异不仅在于结构,更在于其诞生的漫长自然选择过程与多样且高带宽的输入输出交互。 人类的思维过程涉及数百亿神经元的迭代及其动态变化,伴随着激素调节、能量管理与环境适应。其维度和复杂度远超现有人工模型。而且,尽管人类思维仍未被完全理解,无法准确通过概率分布预测我们可能产生的语言序列,但这反而凸显了人的非函数性质和高度不可预测性。与之相比,LLM则可以明确给出某段文本生成的概率,表明它具有可量化的数学模型优点。 理解LLM的非拟人化视角还帮助我们理智应对研究和应用中的风险。

模型生成不当内容的风险本质上是统计风险,表现为在长时间运行中可能出现令人不适或危险的输出序列。通过清晰说明这一点,有助于开发更好的风险管理策略,比如改进训练数据、调整模型结构和采样机制,而非幻想模型会“故意”为害或“有自主意识”的恐惧心理。 此外,这种视角有助于公众和决策者更科学地判断AI技术的影响。相比神秘和恐慌,理性认知使我们能够更好地规划技术规范、产业应用与法律监管,引导技术向造福人类的方向发展。大型语言模型作为算法工具,具有极高的实用价值,已经在自然语言处理、信息抽取、内容生成等领域表现出超越传统规则系统的能力。它们推动了多个领域的创新,改变了信息交互与处理方式,有望与电气化、互联网等重大技术革命相提并论。

未来,随着模型规模不断扩大和优化技术的提升,LLM破解更多先前算法难以解决的问题的能力将持续增强。与此同时,对模型安全性和“有害内容”识别的强化研究也亟待突破数学和计算的局限。理性地看待这些问题,有助于科技界和社会更有效地应对挑战,推动技术进步与伦理规范的双重发展。 总而言之,非拟人化视角为我们厘清了大型语言模型的真相,剥去了神秘的面纱,让我们能从数学和算法的角度理解这一复杂而强大的技术。它是人类智慧与工程能力的结晶,是一组根据训练数据映射语言向量的数学函数,而非具备意识和情感的智能体。只有抛弃拟人化的错误观念,理解其本质及局限,才能更好地利用这一技术,推动社会朝着更加理性和平衡的方向前进。

面对技术变革带来的深刻影响,我们需要准确且清晰的思考框架,避免混淆科学与神话,真正把握新时代人工智能发展的脉搏。