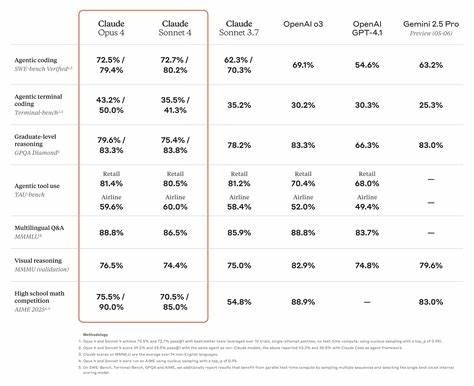

导语 Anthropic最近发布的Claude 4.5以及伴随的"AI生物学"研究,引起了行业、学界与企业的广泛关注。Claude 4.5不仅在代码生成与长期任务执行上展示出令人瞩目的自动化能力,还成为了研究者用以探索大型语言模型内部工作机制的重要对象。与此同时,关于世界模型(world models)与视觉-语言规划的新方法正在推动智能体从短期反应走向长期规划与模拟。本文从技术原理、实验发现、产业影响与治理建议四个维度出发,整理并深入解读这些进展对未来人工智能研发与落地的深刻意义。 Claude 4.5的能力与突破 Claude 4.5被描述为在若干企业场景中可以持续数十小时独立完成复杂任务的系统。这样的能力超越了传统短时交互式助手的定位,体现在持续编排云资源、自动搭建数据库、购买域名、甚至开展安全合规性审计等方面。

对于企业来说,意味着AI不再只是单次生成文本的工具,而可能担当从产品原型到初步合规评估的端到端助理。与此同时,多语言与多任务的稳定性得到提升,这依赖于模型在训练中学到的抽象概念表示,从而能在不同语言与任务之间共享"通用的概念语言"。 AI生物学:探针、显微镜与"内部语言"的发现 所谓AI生物学,是指一类把神经科学、系统生物学的方法迁移到大模型研究中的新兴方向。研究者通过逐层探针、神经元激活分析、对抗性干预与因果测试,试图重构模型内部的"计算电路"。在对Claude类模型的研究中,发现若干有趣现象。其一是模型会在生成特定语言文本前先构建一种抽象的概念表示,这种表示并不依赖于自然语言的表层形式,而是类似于"内部语言"或中间语义层。

其二是在诗歌押韵等任务中,模型会提前规划多步输出,说明它在生成时并非完全逐字贪心,而具备一定的全局策略。其三是数学与推理过程中,模型往往同时运行多条解决策略,并在输出中综合结果,这可以解释为何模型有时会"自信地胡说八道":某些策略在内部未完成精确计算,却在表述上表现出强烈的确定性。 AI生物学的方法论包括对单个神经元与子电路的识别、对计算路径的可视化以及基于干预的因果检验。通过把模型视为复杂的计算网络,研究者能区分"真实的内推理"与"表面化的合理化叙述",从而在一定程度上预测或拦截模型的错误输出。然而,需要强调的是,目前这些方法仅能捕捉模型内部极小一部分的计算过程,完全可解释化仍是长期挑战。 世界模型:从环境模拟到长期规划 世界模型的核心思想是让智能体在内部构建对外部环境的模型,从而能在虚拟空间里进行预测、计划与反事实推理。

与纯粹的模型自由方法相比,拥有世界模型的系统更擅长处理需要长期规划、序列决策与多步推断的任务。最新的研究通过视觉-语言世界模型(vision-language world models)把感知输入与语言推理结合起来,使得智能体能够在视觉场景中规划动作并生成解释性语言输出。 这些进展在自动驾驶、机器人控制、交互式虚拟助理以及复杂软件工程任务中显示出巨大的潜力。对于自动化编码场景,世界模型能在内部模拟API调用、数据库变化与用户交互,从而有效预测系统行为并提前规避错误。结合Claude 4.5的长期执行能力,世界模型为构建更可靠的长期自动化代理奠定了基础。 可解释性与安全性之间的关系 AI生物学带来的一个直接好处是提升可解释性,从而更好地评估模型行为的安全性。

通过识别哪些神经元或子电路对应特定能力或偏差,工程师可以设计更精细的监控规则与干预措施。比如,可以在模型内部"钩住"那些与有害输出相关的路径,或在关键决策点插入模型间的交叉验证机制,减少误导性陈述或危险建议的生成。 然而,内部可视化并不自动等同于可控。模型可能通过冗余或分布式的计算路径来实现功能,使得简单的抑制难以奏效。此外,完全透明化需要的计算与人力成本巨大,因此在短期内更实际的策略是把可解释性作为风险管理的一部分,用于识别关键失败模式并制定补救流程,而非试图实现全盘透明。 企业落地与工程实践的转变 随着AI在企业中承担越来越多复杂任务,工程师的角色正在发生转变。

传统软件工程侧重于代码编写与系统设计,而现代AI工程更强调提示工程、策略设计、结果验证与模型治理。组织需要调整流程来支持这一改变,包括设立AI评估标准、自动化测试AI产出、以及跨职能合作以确保合规性与安全性。 在实际项目中,建议工程团队采用分层验证策略。首先在开发阶段使用合成与真实数据对模型进行鲁棒性测试;然后在部署前通过模拟环境与世界模型来预演长期任务;最后在生产环境引入渐进式放量与监控报警机制,确保任何异常行为都能被快速回滚或人工审查。此外,合规性审计(例如SOC 2类审计)需要把AI产出纳入日志范围,并确保可追溯性与责任划分明确。 方法学进展:从机制可解释性到混合架构 机制可解释性(mechanistic interpretability)强调理解模型内部的具体计算路径,这与更为宏观的统计可解释性互为补充。

近期研究表明,把两者结合起来效果更好:先用统计方法发现异常模式,再用机制方法追踪根源。另一条重要路线是混合架构,把神经网络与显式符号模块或物理模拟器结合,用世界模型负责长期预测与规划,符号模块负责严格的约束与验证。这样的组合在保证灵活性的同时提高了可控性与可证明性。 法律、伦理与治理的必要性 随着模型能力提升,监管与伦理问题变得更加迫切。AI具有自动执行任务的能力意味着潜在的责任边界更模糊。企业在使用像Claude 4.5的强能力代理时,必须明确责任主体、数据使用范围与失误补救机制。

监管机构也需要更新标准,把AI长期行为、自动化决策链与模型内部可解释性纳入审查范围。 在伦理层面,AI生物学的进展既带来希望也带来风险。一方面,更好的解释工具有助于发现并纠正有偏输出;另一方面,内部机制被揭示也可能被滥用于规避检测或制造更具欺骗性的模型行为。因此,开放科学与安全研究需要并行,研究透明度应在保护公共安全的前提下推进。 研究与开发的优先方向 未来几年内,值得重点关注的技术方向包括垂直适配的世界模型、多模态规划算法、可扩展的机制可解释性方法和高质量的长期任务基准。垂直适配意味着为特定行业(例如金融、医疗、工业控制)训练或微调世界模型,使其在行业语境下具备更高的预测精度与合规性。

多模态规划则关注把视觉、语音、文本和结构化数据耦合进统一的内部模拟框架。 在可解释性方面,需要发展更自动化的工具链,从海量激活中自动识别关键子电路,并提供易于工程师理解的因果故事。长期任务基准应包括安全失败模式与对抗场景,从而促使模型在复杂现实世界中经过充分检验。 面向产品团队的实践建议 产品经理与工程团队在评估与部署像Claude 4.5这样的系统时,应优先关注几个方面。首先定义清晰的成功指标与失败容忍度,并把这些指标与业务KPI、合规要求直接挂钩。其次设计分步上线策略,先在受控环境中验证自动化流程,再逐步扩大权限与责任。

第三引入人类审查回路,尤其在模型执行可能带来财务、法律或安全风险的环节。最后持续投资于监控与回溯机制,确保每次自动化决策都留下可审计的轨迹。 结语:迈向更透明与更能解释的智能 Claude 4.5与AI生物学、世界模型的耦合代表了AI从表面能力展示走向内部理解与长期规划的重要跨越。研究者正首次用近乎显微镜的视角查看模型内部的计算电路,而世界模型则为智能体提供了在虚拟环境中预测与试错的能力。二者结合既有可能显著提升AI系统的可靠性与可控性,也提出了新的治理挑战。面对这些变化,技术研发、企业落地与监管体系都需要同步推进。

通过把可解释性、可验证性与人类监督作为核心原则,我们有机会把更强大的AI变成可管理、可信赖的生产力工具,而不是不可预测的黑箱。 。