强化学习(Reinforcement Learning,简称RL)作为机器学习的重要分支,在近年来快速发展并广泛应用于各类人工智能系统中。尤其是在大型语言模型(Large Language Models,LLMs)的建设和优化过程中,强化学习扮演了不可或缺的角色。理解强化学习为何对大型语言模型如此重要,有助于更好地把握人工智能技术的前沿趋势和未来发展方向。 大型语言模型凭借强大的文本理解和生成能力,已经在自然语言处理(NLP)领域引发了深远影响。这类模型通过海量文本数据进行训练,能够完成翻译、写作、对话等多种任务。然而,传统的监督学习方法尽管强大,却存在一定的局限性,例如容易造成模型对训练数据的过拟合,难以灵活适应复杂多变的实际应用场景。

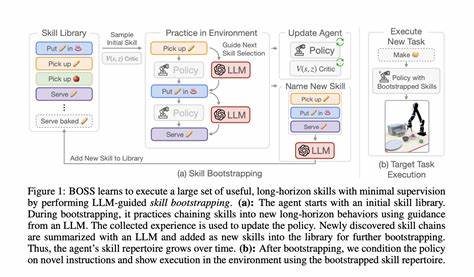

强化学习的引入有效弥补了这些不足。通过与环境的互动,强化学习使模型能够根据外部反馈不断调整策略,从而提升决策质量和行为表现。对LLMs而言,这意味着模型不仅能学习语言的规律,还能根据用户的具体需求和上下文信息动态优化输出结果。 强化学习在大型语言模型中的核心应用之一是基于人类反馈的强化学习(Reinforcement Learning with Human Feedback,RLHF)。RLHF通过结合人类专家的评价,引导模型生成更加符合人类价值观和需求的内容。以OpenAI的GPT系列为例,RLHF大幅提升了模型在对话质量和安全性方面的表现,使得输出更加自然且避免不当内容。

此外,强化学习还帮助LLMs提升了长期依赖任务中的表现。传统的序列生成模型在处理较长文本或多轮对话时,容易遗忘之前的信息,导致回答不连贯或偏离主题。通过设计合理的奖励机制,强化学习可以促使模型关注上下文整体,提高一致性和相关性,从而为用户带来更优质的交互体验。 从技术实现来看,强化学习在LLMs中的应用需要解决一系列挑战。首先是设计合适的奖励函数,这不仅影响模型学习的方向,还决定了最终输出的质量和安全性。奖励机制须兼顾准确性、流畅性、创造力和伦理规范,确保模型行为符合社会期望。

其次,强化学习往往计算成本较高,训练过程复杂,需要大量算力支持。为了实际应用,研究者们不断探索高效的算法和架构优化方案,以降低训练成本,提高训练速度。 强化学习的引入也推动了LLM应用的多样化。例如,在教育领域,利用强化学习优化的语言模型能够更好地理解学生需求,提供个性化辅导和建议。在医疗行业,通过精细调控和反馈学习,LLMs协助医生进行病历分析和信息检索,提高诊断准确率。在内容生成和创意写作中,强化学习赋能的模型更能捕捉细腻的情感表达和语境,使作品更具感染力和原创性。

值得注意的是,强化学习不仅提升了大型语言模型的性能,也促进了人工智能伦理和安全领域的进步。通过人类反馈和奖励机制约束,模型能够有效避免偏见、恶意内容和误导信息的产生。此外,强化学习使得模型具备一定的自我调整和纠错能力,为构建更加可靠和可控的人工智能系统奠定了基础。 展望未来,随着算法的不断创新和计算资源的提升,强化学习将在大型语言模型中扮演更加核心的角色。结合多模态信息和跨领域知识,RL驱动的LLMs有望实现更高水平的理解力和创造力,推动人工智能迈向更广泛的应用场景。同时,围绕伦理、透明度和可解释性的研究也将进一步深化,确保技术发展的同时兼顾社会责任。

综合来看,强化学习的重要性不仅体现在优化大型语言模型的表现,还在于它赋予模型适应复杂环境和多样需求的能力。通过持续互动和反馈学习,RL帮助LLMs实现从被动预测到主动决策的转变,使其在实际应用中展现出更强的智能和灵活性。理解强化学习在这一过程中的作用,是把握现代人工智能发展脉络不可或缺的一环。