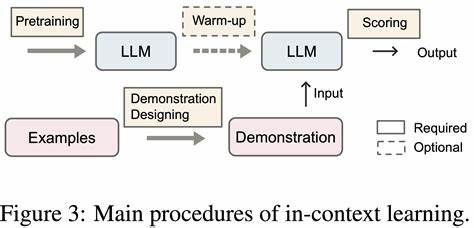

随着人工智能技术的快速发展,尤其是在大型语言模型领域,上下文学习(In-Context Learning,ICL)引起了广泛关注。ICL作为一种新兴的模型能力,允许模型在无需额外训练的情况下,通过输入示例或"few-shot"提示完成新的任务。然而,业内和学界开始反思:上下文学习到底算不算是"真正的学习"?这背后蕴含着怎样的技术原理和哲学思考? 典型的机器学习过程往往依赖于模型在训练阶段吸收大量数据,调整参数,从而形成对任务的理解和泛化能力。相比之下,ICL不改变模型参数,而是在模型已有知识基础上,根据输入提示进行推断。换句话说,ICL更多依赖模型预训练时积累的隐含知识,再结合提示示例,完成任务。这种方式看似灵活高效,但是否真的实现了"学习"这一认知过程,引发学术界的激烈讨论。

来自Adrian de Wynter最新的研究指出,从数学角度看,ICL确实构成了一种学习形式,但其特性与传统学习存在显著差异。传统学习强调显式编码和存储新知识,而ICL则没有明确将观察到的新信息固化到模型参数中,而是在推断阶段临时利用提示信息完成任务。换句话说,ICL犹如模型捕捉提示中的规律和模式,基于先验分布做出的短暂"适应"。 研究团队通过大规模实验验证了ICL的各种表现,并排查了诸如记忆效应、预训练知识、分布偏移以及提示风格对结果的影响。结果显示,ICL确实是一种有效的学习途径,尤其在少量示例提示场景下,模型能够快速展现一定的推理和模式发现能力。但与此同时,其泛化能力和对新颖任务的适应仍然有限。

随着示例数量的增加,模型表现趋于稳定,但对示例分布和语言风格却表现出一定的敏感性,说明模型仍倾向于从提示中挖掘表面规律,而非深层知识迁移。 ICL的表现具有明显的局限性。首先,模型依赖预训练知识库,若遇到任务与预训练分布差异过大,性能骤降。其次,ICL难以真正编码新的规则或知识,只是在已有经验基础上模拟相似模式的生成。最后,提示的设计和表达方式对结果影响显著,尤其是采用链式思维(chain-of-thought)等复杂提示时,模型的推理稳定性往往不高。 这些发现表明,ICL虽然代表了一种全新的学习范式,但尚未达到通用学习的标准。

其机制依赖于概率推断和模式匹配,更接近于一种即时的记忆调取和模式归纳,而非传统意义上的系统性"学习"。 如此来看,ICL的兴起拓展了人工智能模型在少样本学习上的应用场景,极大地简化了新任务的适应过程。但同时,如何突破ICL在泛化和稳健性上的瓶颈,成为未来研究的重要方向。结合模型结构的创新、提示设计的优化以及任务多样性的提升,未来ICL有望向更接近人类认知的学习形态演进。 总之,上下文学习在现有技术框架下,既不同于传统通过参数调整实现的学习,也不是纯粹的机械记忆。它是一种基于预训练知识和即时模式识别的特殊学习机制。

对ICL深入理解不仅有助于推动自然语言处理技术发展,也对认知科学和学习理论提供了新的视角。未来随着更多实证研究的开展,ICL在智能系统中的地位将更加明晰,推动人工智能迈向更加智慧和灵活的新时代。 。