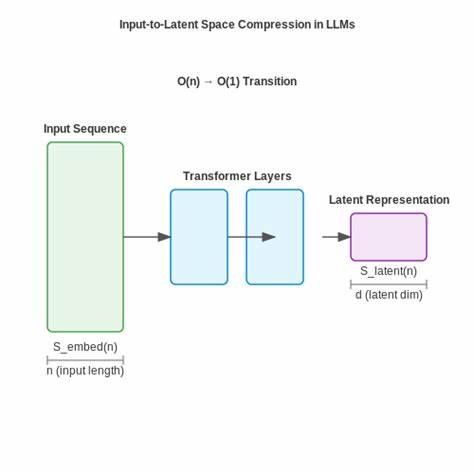

近年来,基于人工智能的"大型语言模型"(Large Language Models,简称LLMs)如ChatGPT、Claude Code及Cursor等工具迅速改变了编程的面貌。它们不仅提升了编码效率,还降低了软件开发的门槛,使计算机科学学生和从业者得以更快地贡献价值。然而,这种便利的背后也隐藏着复杂且值得深思的挑战。许多专家指出,LLMs实际上掩盖了代码背后的深层逻辑和严格性,若过于依赖这类工具,学习者极易陷入"表面看似正确"的误区,忽视了真正的计算机科学基础。计算机科学教育在这个新变革时代,面临着前所未有的抉择:应如何帮助学生既善用AI,提升生产力,又避免失去对底层技术的深入理解和严谨思考的习惯。\n\nLLMs在生成代码的过程中采用基于统计的语言模型技术,通过大量文本数据学习不同语境下的语言模式,从而预测合理的下一个词或片段。

在实践中,这意味着模型可能会输出功能性极高、代码风格优美的程序片段。但遗憾的是,模型并不真正"理解"代码的语义或逻辑,仅依赖概率和训练数据来进行生成。许多研究和案例表明,LLMs生成的代码在通过基本测试时往往表现良好,但如果放在严谨的形式验证和边界条件分析中,就可能暴露出潜在漏洞和错误。尽管一些专家仍在用Eiffel合同和AutoProof等形式化验证工具校验LLM生成代码的正确性,但这类做法目前依然少见,也难以大规模推广。\n\n这种现象引发了一个根本问题:现代软件工程是否正在从传统的严谨过程和形式验证,转向"粗放式"的大规模生成和近似验证?答案并非单一明确。但对计算机科学学生来说,绝不可简单成为"不会编程但会使用AI工具的操作员"。

他们需要培养对底层原理的执着追求,避免陷入"有效即可"的"vibe coding"心态。真正的编程是一场认识世界的深层对话,而非与黑箱机器的盲目指令传达。只有具备扎实的算法设计、数据结构、程序语义以及系统架构知识,才能在AI工具因成本或定制化限制无法胜任时,保持竞争力和适应力。\n\n与此同时,AI工具的崛起对计算机科学教学方法也提出了新要求。传统授课模式重视学生独立完成作业、手写代码的过程正在被"AI辅助生成代码"的现实冲击。教学者需要重新平衡教学内容和评估标准。

不能仅仅教授"怎么使用AI",更重要的是教学生"怎么判断AI输出的正确性",以及"怎么理解并修改AI生成的代码"。尤其是在培养批判性思维和代码阅读能力上,要下更大功夫。研究建议引入个性化教学方案,例如利用AI根据学生过往的错误制造定制化练习,或者通过让学生修正有意设计的AI生成错误,反复锻炼其分析和改进能力。这样不仅提升了学习的针对性,也更符合未来职场对多面技术人才的需求。\n\n除了技术和教育层面,LLMs的普及还带来了伦理和社会维度的思考。学术研究表明,AI辅助完成的作业可能掩盖学生真实的学习状态,导致学术诚信风险上升。

部分教师通过嵌入特殊标记、AI检测工具以及设计AI难以回答的考题尝试应对,但效果有限更长期看,培养学生主动理解和信任的关系比单纯的技术监控更为关键。同时,数据偏见、隐私问题、知识产权争议等也持续被曝光。尤其在全球视角下,针对不同文化背景和语言语境的AI数据不足,会造成技术排斥和刻板印象,使计算机科学学习环境面临公平性和多样性挑战。\n\n有趣的是,教育学研究还表明优质的师生关系在新技术背景下依然不可替代。无论AI如何普及,教师与学生之间的信任、时间投入和情感交流是塑造深度学习的关键。教学不只是知识传递而是心灵的相遇,培养健康的好奇心与求知欲,打开学生深入思考的空间。

只有创造包容且激励的学习环境,才能帮助学生跳出技术细节的表层,窥见计算机科学的美好本质与哲学深度。\n\n随着AI工具逐渐成为编程不可或缺的伙伴,我们应看到技术赋能的利好,同时警惕其潜在限制。在未来的教育设计中,AI应作为辅助而非主导,使学生兼具利用现代工具的敏锐与掌握扎实理论的底蕴。教师需要引导学生不仅会"写代码",更要会"读代码"和"理解代码",无论这些代码是由人类还是由机器生成。通过个性化教学、辩证思维训练和形式验证等多管齐下,计算机科学教育才能实现技术革新与知识积累的有机结合。\n\n总结来看,大型语言模型在极大提升编程生产力的同时,必然隐藏着复杂多变的技术细节与深刻风险。

只有当学习者和教学者都具备深度理解复杂系统的能力,以及勇于质疑和超越表面现象的态度,才能在这一波AI浪潮中立于不败之地。未来的计算机科学教育,将不仅是技能培养,更是一场对知识本质、正确性、诚信与创新的全面修炼之道。拥抱AI,理解它的局限,并超越它,或许才是通往未来的关键所在。 。