随着人工智能技术的发展,公众对“人工智能”的理解逐渐形成了一套既定的观念和神话。然而,计算机科学家贾伦·拉尼尔(Jaron Lanier)提出了一个引人深思的观点:我们所称的“人工智能”其实并不是所谓的“智能”,本质上并不存在真正的人工智能。这种误解不仅阻碍了技术的合理管理,还可能加剧对AI未来潜在风险的恐慌。理解这一观点,对引导正确认识AI,促进技术与社会的良性互动具有重要意义。人工智能这一名词起源于20世纪50年代,诞生于计算机科学的早期阶段,但随着电影和科幻作品如《终结者》《黑客帝国》《星际迷航》等的影响,这个词汇被不断神话化。公众、甚至业内人士常常幻想AI将拥有类人的意识和自主判断,甚至可能在未来取代人类成为地球主宰。

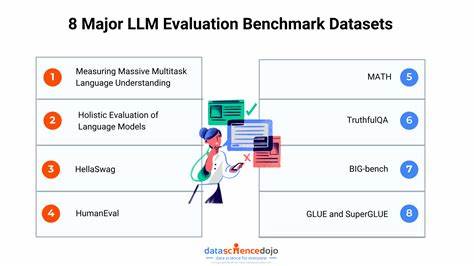

然而事实远非如此。最新的大型语言模型如GPT-4等,虽然展现出惊人的语言和图像生成能力,但它们背后的原理不过是一套庞大的数学统计系统,通过海量数据的概率运算生成看似智能的输出。这种柔性和多样性来自于对无数文本、图像和声音的统计分析,而非真正意义上的理解或思考。所谓的“智能”,更多是对人类作品和模式的模拟与拼贴。换句话说,AI工具是基于“社会协作”的产物,即它们“借用了”人类创作的知识遗产,通过复杂的算法加以重组和呈现。们应当将AI视为工具,而非自主生物。

这一视角非常关键,因为把AI神格化容易导致对技术的误判和滥用。当人们沉迷于幻想AI拥有自主意识时,反而容易忽视对技术伦理、安全和监管的现实需求。另一方面,若将其视作人类创造力和合作的延伸,则更有助于理性管理和创新应用。AI技术的潜在危害依然存在。技术设计和应用不当可能带来诸如误导信息传播、隐私侵犯、社会操纵等风险。尤其在当前技术黑盒特性强烈的情况下,透明度不足使得公众难以理解AI的工作机制,从而加剧对AI滥用的忧虑。

对此,业界开始强调“数据尊严”(data dignity)和“数据即劳动”的理念,试图通过赋予数据创造者公平的权益保障,提高AI系统的透明度和责任归属。数据尊严主张在人工智能模型的训练和运行中,明确承认并补偿那些贡献原创内容的人们。这不仅有利于推动更公平的经济体系,也有助于激发创新活力和社会信任。谈及AI可能带来的经济影响,尽管有人认为AI会让许多职业过时,甚至造成大规模失业,但数据尊严理念提供了一种转型路径。通过对贡献者进行合理回报与激励,AI的推广可以带来新的职业机会以及协作模式。这样不仅避免了“失业潮”的悲观预期,也为创造更多有意义的新职业奠定基础。

对于潜在的社会灾难,如深度伪造视频可能引发的社会恐慌,拉尼尔指出,缺乏数字内容的“出处”或“溯源”极易导致混乱。历史上,互联网设计之初为追求传播效率,忽视了信息的上下文关联和来源可追溯性。如今,这种“去上下文化”成为AI风险的重要根源。一个健康的数字生态应当强调信息的透明和来源清晰,这将成为抵御信息造假和操纵的关键。要实现这一点,需要技术创新和政策制定合力推动。数据透明、可溯源不仅有助于个体用户识别虚假信息,也是建立对AI系统信任的基石。

同时,鼓励公众了解AI技术运行的基本原理,弱化神秘感,增强对AI的“人类化”管理意识,将使社会对新技术具有更强的适应能力。拉尼尔还提醒,AI技术本身没有内在“意图”或“欲望”,它不过是“膨胀的果冻状数学混合体”。试图赋予其“意识”是对系统机制的误读。正因如此,AI自治的末日预言并非无懈可击,而更像是对“未知”的恐惧。这意味着我们应将有限关注力转向现实中人类与技术的平衡问题,而非追逐科幻般的妄想。拉尼尔提出,AI治理的一个实际切入点是保障AI生成内容的创作者权益,并制定严格的标识制度,明确区分人工与人工智能制造的内容,防范欺诈和操纵行为。

为此,需要建立包括行业规范、立法监管及公众教育在内的多渠道协作体系。在未来,深化大模型对数据来源的追踪和说明,结合“数据尊严”,可为AI生态圈注入更可持续的动力。技术进步不能脱离伦理和社会价值的引导,否则很可能带来新的危机。人工智能作为人类文明的产物,其核心仍是“合作”与“共享”。承认这一点,将为人类与AI的共生开辟更宽阔的道路。总之,拉尼尔的观点促使我们重新审视“人工智能”的定义,提醒公众和科技工作者应当警惕神话化的危害,在理性框架下推进技术进步。

通过推行数据尊严、强化信息透明、促进公平合作,我们能够构建一个更人性化、更可控的技术未来。正如他所言,“人类才是解决信息问题的答案”,只有坚持以人为本,技术才会真正服务于社会整体福祉。