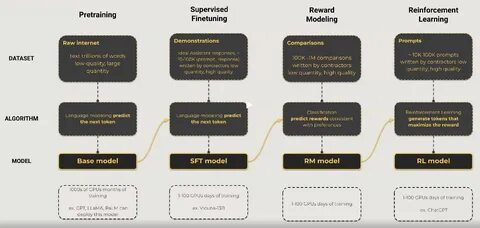

随着人工智能技术的迅猛发展,大规模语言模型(Large Language Models,简称LLM)在自然语言处理领域展现出卓越的能力,广泛应用于机器翻译、智能问答、文本生成等多个场景。然而,LLM通常由数十亿甚至数千亿的参数构成,其训练过程对计算资源和时间提出了极高的要求。为了有效解决这一问题,分布式训练技术应运而生,成为推动LLM不断进步的重要保障。分布式训练指的是将模型的训练任务划分并分配到多台计算机或者多张显卡上并行执行,实现资源的高效利用与训练速度的显著提升。本文将从分布式训练的基本原理、常见架构、关键技术挑战以及未来发展趋势等方面展开全面探讨,帮助读者深入理解如何高效进行大规模语言模型的训练。分布式训练的核心思想在于并行化工作负载,主要包含数据并行、模型并行、流水线并行等多种策略。

数据并行技术是最为经典且应用广泛的一种方式,通过将训练数据拆分成多个小批次同时输入到不同计算节点上运行相同的模型副本,并周期性地同步参数更新,极大地提升了训练吞吐量。尽管数据并行易于实现,但面对超大规模模型时,由于模型体积巨大导致单个节点内存瓶颈难以克服,因此模型并行成为必要。当模型参数无法放入单张显卡时,通过将模型切分成不同部分分布在多个设备上,令显存资源得以均衡利用。此外,流水线并行结合了数据并行与模型并行,通过将模型划分为多个阶段,每个阶段由不同的计算节点执行,数据批次在阶段之间顺序传递,进一步降低等待时间,提高硬件利用率。合理择优地组合这些并行方式,成为当前分布式训练设计的关键。同时,参数服务器和全量同步机制也在分布式环境中扮演重要角色。

参数服务器负责集中管理模型参数,支持快速的参数更新与分发,减轻通信负担。针对通信延迟与带宽受限的问题,梯度压缩、异步更新等优化策略不断被提出,从而减少训练过程中的网络瓶颈。使用高效的通信库和拓扑结构优化也成为提升整体训练效率的必要举措。然而,分布式训练仍然面临诸多挑战。首先是计算资源的协调与负载均衡,如何确保各计算节点高效协作,避免出现操作阻塞或计算空闲,是保证训练性能的关键。其次是容错机制设计,一旦某台机器发生故障,系统如何快速恢复训练进度,避免大规模计算任务的浪费,是分布式系统必须解决的问题。

此外,算法层面的改进也不可忽视,梯度同步延迟、模型收敛速度等问题会直接影响训练效果。最近兴起的技术如混合精度训练、动态计算图优化、自动并行策略搜索,有效降低了计算开销和内存使用量,提升了训练的稳定性和精度。深度学习框架诸如TensorFlow、PyTorch以及专门针对大规模模型设计的Megatron-LM、Deepspeed等工具,为分布式训练提供了丰富的支持和便利。它们不仅封装了复杂的分布式通信细节,还集成了梯度裁剪、梯度累计、混合精度计算等多种优化手段,极大地简化了开发者的工作流程。此外,云计算平台与高性能计算集群的普及,为分布式训练提供了强大的计算资源保障。通过弹性扩展功能,研究人员能够根据需求灵活调配节点,实现训练任务的高效执行和成本控制。

值得一提的是,随着LLM参数规模不断膨胀,模型并行技术面临越来越严峻的挑战。现有的单维度切分已难以满足需求,多维度、更细粒度的分布策略逐渐得到重视。同时,异构计算资源的整合利用、边缘计算与中心云协同训练正成为新的研究热点。展望未来,分布式训练技术将更加智能化和自动化。自动调节并行策略、动态负载均衡、容错能力提升以及资源调度优化,将成为提升训练效率的关键方向。与此同时,绿色训练和节能减排理念也逐步融入研发体系,通过优化算法和硬件设计减少训练过程中的能耗。

此外,多模态大模型和跨领域迁移学习的兴起,对分布式训练提出了更高的要求,促使相关技术持续创新。总之,分布式训练作为大规模语言模型研发的核心手段,不仅改善了训练时间与成本,还促进了模型性能的持续突破。通过不断优化并行策略、增强系统鲁棒性以及结合先进硬件平台,分布式训练将在未来的人工智能领域发挥更加重要的作用,为推动智能技术的普及与应用提供坚实基础。研究者和工程师应密切关注这一领域的发展动态,积极尝试新技术和新方案,为构建更加强大高效的智能系统贡献力量。 。