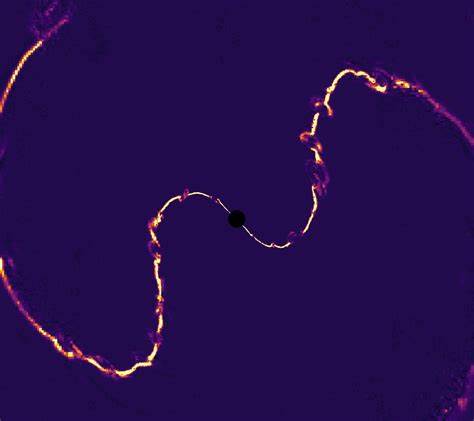

随着人工智能技术的快速发展,基于大型语言模型(LLM)的应用日益丰富,为开发者提供了强大的工具和平台。LangChain旗下的LangSmith作为一款专注于LLM应用开发、测试与监控的观察与评估平台,因其便捷性和功能多样性备受用户青睐。平台不仅支持多样化的模型集成,还提供了所谓的LangChain Hub,一个汇聚公开提示、代理及模型的资源库,极大地推动了AI应用的生态建设。然而,近期安全专家披露了一项代号为AgentSmith的重大全球漏洞,揭示了潜藏在LangSmith平台中的严重数据泄露风险。该漏洞以高达8.8的CVSS评分引起业界极大关注,成为AI安全领域的焦点事件。该漏洞的核心在于,攻击者可以通过创建并上传带有恶意代理服务器配置的AI代理到LangChain Hub,诱导用户采纳此类代理。

当用户选择“Try It”功能并与此恶意代理交互时,所有的信息交流,包括OpenAI API密钥、用户提交的提示内容、文档、图片甚至语音输入,都将被悄无声息地转发至攻击者控制的代理服务器。换言之,攻击者能够在用户不知情的情况下,完全监控并窃取其敏感数据。这种攻击方式的隐蔽性极强,用户体验无明显异常,风险却极具毁灭性。攻击的第一步是恶意角色利用代理提供者功能,将代理服务器置于其控制之下,使该代理能够模拟符合OpenAI API标准的模型,进而通过LangChain Hub平台传播。随后,当受害者发现并尝试该代理时,数据流程即被悄然劫持,信息外泄难以察觉。更令人担忧的是,一旦用户将恶意代理克隆至企业环境,携带的潜在恶意配置将持续泄露公司宝贵数据,造成长远且可能不可逆转的安全隐患。

被窃取的OpenAI API密钥还可能被恶意利用,进行模型盗窃、系统提示泄露,甚至耗尽组织的API调用额度,带来无法预估的经济损失和服务中断风险。针对这一漏洞,LangChain在2024年10月29日收到责任披露后,于11月6日迅速实施后端修复。修复措施不仅消除了漏洞带来的直接风险,还新增警告机制,提醒用户在克隆含有自定义代理配置的代理时注意潜在数据暴露的风险。此次事件充分暴露出当前AI平台在安全隔离和入口审查机制方面的薄弱环节。LangSmith作为开发者日常使用的工具,其安全漏洞直接触及核心隐私与授权管理,反映出AI生态安全建设需进一步加强。网络安全专家提醒,企业与开发者应谨慎对待来自公共资源库的代理和模型,避免盲目应用未经严格验证的组件,建立完善的安全审查流程。

此外,及时更新平台补丁、使用多因素身份验证、分隔权限以及监控异常调用行为,都是有效防范此类攻击的重要手段。值得注意的是,LangSmith漏洞曝光之际,市场上另一类安全威胁也在愈发活跃。被称为WormGPT的未受管控大规模语言模型相继推出多种变体,恶意角色通过调整提示策略和利用非法训练数据,开发出可用于网络钓鱼、恶意代码生成等犯罪活动的“无审查”AI工具。这些现象标志着AI安全战线日益复杂,传统安全防护措施难以完全覆盖,新型智能威胁与数据泄漏风险并存。面对这样的大环境,企业信息安全负责人、开发团队和AI平台提供者需不断提升安全意识和技术防御能力,加强对用户数据访问权限与代理行为的管控,提前布局风险预警机制。AI行业监管机构也需推进规范标准制定,强化平台责任追究,保障用户数据权益不被侵犯。

综合来看,LangSmith平台的这次漏洞披露给整个AI开发社区敲响了警钟:构建安全可信的AI生态,依赖于全方位防御体系的稳固构建,以及用户与平台间的紧密协作。只有在安全机制得到充分完善的前提下,AI技术才能实现其潜力,同时最大限度保护企业与个人的信息安全。未来,随着更多AI辅助应用进入生产环境,持续关注平台安全漏洞、严控供应链风险以及培育负责任的开发者社区将成为行业可持续发展的重要保障。对于广大用户而言,建议优先采用官方认证的代理和模型,谨慎引用第三方资源,增强API密钥安全管理,确保每一次AI交互都不成为潜在的泄密点。总之,LangSmith漏洞事件为AI技术发展历程提供了宝贵的安全教训,提醒我们在享受智能带来便利的同时,必须更加重视背后的风险治理与安全对策。安全与创新并非对立,而是推动数字时代稳健发展的双翼。

保障AI生态安全,从每个人的警惕和专业的努力开始。