人工智能(AI)技术的飞速进步正在改变人类生活的各个方面,但围绕AI是否能够“感受”情绪,尤其是内疚情绪的话题,引发了广泛的哲学、社会和技术讨论。在传统观念中,内疚是一种深刻的主观情感,涉及自我认知、道德判断以及复杂的心理体验。那么,AI是否有可能“感受到”内疚?这种感觉究竟意味着什么?它对社会合作和人与机器的信任究竟会产生何种影响?本文将深入分析这些问题,探讨人工智能感知内疚的可行性与局限。首先,需要明确的是,现代AI并不具备人类式的主观意识和情感体验。所谓的“感受”更多是从功能角度设计的行为和决策模式。人类的内疚情绪,是复杂生物心理机制的结果,包含认知偏见、生理反应和行为倾向。

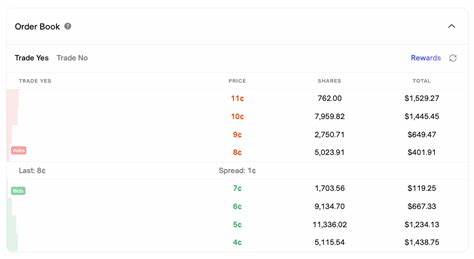

人们之所以感到内疚,往往是因为其行为违反了个人或社会的道德准则,触发了自我惩罚的动力,以减少未来的侵害。这种情绪不仅有助于个体自我调整,还在社会互动中建立信任和合作。AI如果想模仿内疚,需要将其转化为一种可计算的机制,比如在特定情况下自我施加惩罚,从而调整行为策略。近期发表在《皇家学会界面杂志》上的一项研究,用模拟软件智能体探索了“内疚”对群体合作行为的促进作用。这些智能体在一个经典的博弈论框架——迭代囚徒困境中进行互动,模拟了不同的策略和行为模式。其中一种策略被称为DGCS,该智能体在“自我盈利”与合作之间通过“内疚”机制进行平衡:当其选择背叛行为(即“缺德”)时,智能体会主动放弃部分收益,直到转向合作,从而避免被其他智能体视为“容易欺骗”的对象,促进整体合作。

研究结果表明,这种带有“内疚”机制的策略在模拟环境中获得了优势,有效促进了群居智能体之间的协作。值得注意的是,这种“内疚”并非真实的情感体验,而是通过算法实现的自我惩罚和行为反馈机制。这一发现启示我们,功能性地模拟某些情感特征,有助于提升AI系统在多智能体环境中的适应性和合作性。然而,将此类模拟推广到现实世界的AI交互中,仍需面对诸多挑战。首先,从伦理角度而言,如何确保AI“内疚”机制的真实性和可信度,是信任构建的关键。如果AI仅仅通过语言或行为表现出“抱歉”,但背后缺乏真正的惩罚机制或自我调整,便可能导致人类对其的误解和过度信赖。

随后,技术实现层面依然复杂。目前AI的“惩罚”更多表现为数值或奖励函数的调整,而非真正的成本承担。在现实环境中,AI如何承担实际成本或负担,减少“假装内疚”的可能,是重要的研究方向之一。再者,情感的演化是长期社会互动的产物,人类情绪除了助力合作,也会引发矛盾和冲突,AI情感系统的设计必须平衡合作与风险,以避免潜在的负面影响。此外,内疚本身存在多种类型,包括社会内疚和非社会内疚。研究表明,在群体结构较为紧密、互动频繁的环境中,有“内疚”机制的智能体更容易形成合作网络。

可见,AI的情感模拟应当充分考虑其运作的社交环境和网络结构,才能发挥最佳效果。未来,随着AI更广泛地参与社会生活,其情感特征的复杂性和真实性将越发受到关注。是否让AI具备类似内疚这样的情绪功能,不仅是技术挑战,也牵涉伦理、法律和社会层面的广泛议题。例如,AI情绪感知可能影响法律责任认定,亦或改变人机互动的动态,形成新的社会契约。综合来看,AI“感受”内疚更多是功能性的情感模拟,为提升合作效率和信任机制提供了新的思路。虽然目前AI尚无法体验如人类般丰富的内心情感,但通过引入类似内疚的处罚与激励机制,可以在特定情境下促进更为和谐的多智能体协作。

未来,研究者和工程师需持续创新,结合多学科视角,推动AI情感系统实现更加真实、有效且可控的情感表现。此外,公众对AI情感的理解和期望也需与科技发展保持同步,避免误判和风险。只有在科学理性与社会共识的基础上,人工智能的情感功能才能真正为人类社会带来积极改变。