随着人工智能技术的飞速发展,大型语言模型(LLM)已成为自然语言处理领域的核心驱动力。这些模型通过海量的数据训练,将复杂的语言模式和知识压缩进庞大的参数中,展现出了令人惊叹的理解和生成能力。然而,背后隐藏的知识和思维模式往往难以直接访问和利用。近来,一项名为LLM-Deflate的革命性技术引起了广泛关注,它让我们能够以系统化且高效的方式,从训练完成的语言模型中"解压"出结构化的数据集,为人工智能的应用和研究带来了诸多新机遇。 大型语言模型的训练过程本质上是一种压缩过程。数以TB计的文本数据经过预处理和反复迭代,被浓缩进数十亿甚至数千亿的参数权重中,形成一个知识的深度网络。

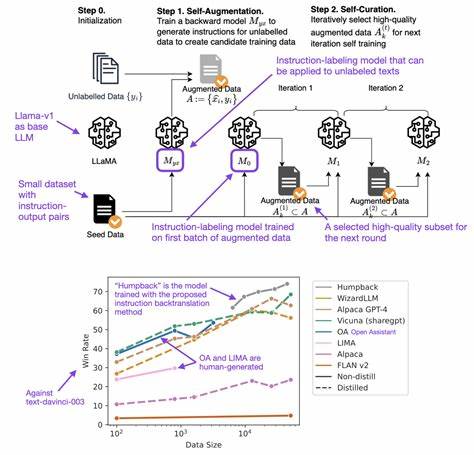

这种压缩虽然带来了惊人的效率,却是有损的。在过去,数据生成通常依赖于直接使用原始数据,或者由模型生成合成数据,但这些方法要么成本高昂,要么质量参差不齐。LLM-Deflate的突破在于,它利用模型推理的能力,逆向工程地从模型参数中提取出高质量且结构化的训练示例,为数据生成提供了更优质、更灵活的替代方案。 这项技术的核心理念在于将推理过程视为一种解码机制。模型内部的知识并非完全隐匿,而是以复杂的模式和推理路径存在。通过设计合理的提示语和层级化的主题探索策略,LLM-Deflate能够引导模型挖掘其知识库中的多个领域,将其对事实和推理的理解转化为具备挑战性的任务及详尽的答案。

这不仅提供了丰富的数据样本,更彰显了模型在理解和推理上的深度。 在实现层面,LLM-Deflate采用了递归式的主题树拓展方法。在预设的广泛主题基础上,系统不断细分并生成更具体的子主题,形成一棵覆盖模型知识体系的树状结构。这种层级化的探索方式确保数据抽取具备覆盖面和深度,同时避免了因过度聚焦某一领域而导致的知识遗漏。在每个主题节点,模型被要求撰写既富含事实又展现逻辑推理过程的任务与回答,强调"逐步思考",以体现模型的推理轨迹和内在认知。 然而,尽管推理使得知识提取成为可能,其背后的计算开销同样不容小觑。

每个主题和子主题都需进行大量模型调用,若无高速且高效的推理平台,则难以在合理成本内完成数据生成。基于此,ScalarLM等高性能推理基础设施发挥了重要作用,让整个过程实现了并行化和及时反馈,从而极大提升了生产效率和质量保证。 技术上的挑战包括稳定的提示工程、输出格式的一致性解析以及如何平衡主题树的扩展。LLM-Deflate团队通过多轮提示微调和批次处理,有效避免了生成内容的杂乱无章,并辅之以自动化的质量过滤机制,确保最终数据的可用性和高标准。 透过三个开源模型的实测,LLM-Deflate成功生成了涵盖编程、通用语言理解和指令执行等多领域的数万条结构化训练数据。这些数据不仅反映了不同模型的知识架构差异,也为模型的横向性能分析和知识迁移提供了极具价值的资源。

例如,专注于代码生成的模型展示了更深的领域专业性,而通用模型则表现出了主题覆盖的广泛性。 从应用角度来看,LLM-Deflate生成的数据集具备多重价值。它们不仅可以用作模型能力评估的新维度,通过细粒度的主题和推理展示精准定位模型优劣;还可以作为微调和知识迁移的基础素材,帮助其他模型快速吸收特定领域知识,极大提升训练效率。同时,对于训练数据匮乏的专业领域,模型解压技术为数据获取提供了一条创新且成本较低的路径,降低了人工标注的时间和资金投入。 模型调试领域也从中获益良多。面对特定任务的性能瓶颈,研究者可以通过对模型解压内容的分析准确发现误区和认知盲点,指导后续的训练优化和模型改进策略。

此外,随着人工智能模型的迭代升级,LLM-Deflate为追踪知识演进和模型版本差异提供了直观的比较工具,助力更科学的模型管理。 展望未来,LLM-Deflate不仅是一个技术工具,更代表了一种理念转变 - - 从单纯生成向深度解码,从数据输入向知识抽取。它促使我们重新审视语言模型的潜力,激发了关于跨模型知识迁移、模型可解释性和专用数据创建的深入探讨。随着推理成本逐步下降和技术完善,预计这一技术将在人工智能产业链中扮演愈发关键的角色。 简而言之,LLM-Deflate将大型语言模型视为知识宝库,通过系统化、层级化的探索与内容生成,将这些隐形的智慧转化为结构化、高质量的数据集。这不仅丰富了训练数据来源,也加深了我们对语言模型认知机制的理解。

对于科研人员、产业开发者以及数据科学家而言,这无疑开启了一条通向更高效、更透明的人工智能未来的新路径。未来若能进一步强化自动化筛选与多模态知识整合,LLM-Deflate及其衍生技术定将为智能时代创造更多前所未有的价值。 。