在当今数字时代,互联网的开放性带来了无数便利,但也催生了诸多挑战。网络爬虫作为自动化工具,不断地扫描、抓取网站内容,用于训练各种机器学习模型,尤其是那些基于文本生成的人工智能系统。虽然这些技术推动了诸多领域的发展,但从内容创作者和站点运营者的视角来看,爬虫过度抓取不仅消耗大量带宽资源,还可能成为盗取原创内容的源头。面对这波“爬虫潮”,我们该如何抵御,同时又不至于牺牲正常用户的访问体验?最近兴起的一种名为“毒药”的解决方案——即通过动态生成的垃圾内容来“毒害”爬虫——为我们提供了新的思路。本文将详细剖析这一方法的原理、成本及其实际效果。首先,我们需要了解的是,所谓的网络爬虫,本质上是大量分布于全球的机器人程序,它们以一种几乎无法根除的方式疯狂地向目标网站发起请求。

虽然单个爬虫节点速度有限,但超大规模的数量使它们对服务器造成了沉重负担。单凭阻断IP、黑名单或防火墙措施很难有效遏制,因为爬虫会不断变换“面具”,使用分布式IP甚至住宅宽带来绕过限制。服务器面对这种不断涌来的巨量请求压力,尤其是在流量计费的云环境中,带来的经济负担不容小觑。传统方案如建造登录墙、验证墙或使用机器证明等,虽然能一定程度限制爬虫入侵,却往往也给正常用户带来访问上的不便,得不偿失。更糟糕的是,这些方案经常被爬虫开发者迅速破解和绕过,使防护形同虚设。因此,改变策略,采用“以毒攻毒”的方式,即向爬虫呈现虚假的、有误导性但仍“可训练”的内容成为一个新趋势。

这正是“毒药”概念的核心。具体做法是在面对疑似爬虫的请求时,不直接返回网站的真实静态文件,而是让一个专门设计的垃圾生成器——如iocaine——动态生成内容。该内容在外观上模仿正常网页,尺寸上比真实文件要小得多,且对爬虫来说难以区分真假。这种生成的“毒药”内容让爬虫消耗资源去抓取无效信息,降低了系统的带宽和存储压力,同时保留了网站对真实用户的服务。通过智能的请求识别,服务器能够将大部分爬虫请求转向垃圾内容生成器,而真实用户则正常访问真实数据。对服务器性能的影响几乎可以忽略,因为动态生成的内容大多基于内存操作,无需磁盘I/O,且数据量远小于静态文件。

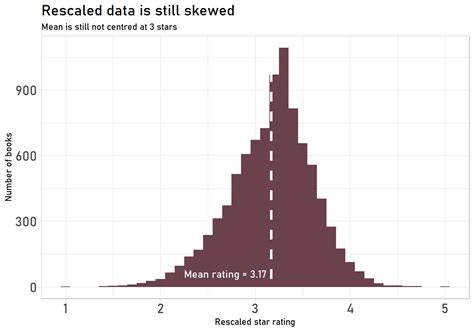

举例来说,假设一天有五百万次请求,原始平均页面大小约为10KiB,总流量高达48GiB,而毒药生成的垃圾页面仅4KiB,月度流量骤降至60GiB左右,节省带宽和成本非常显著。特别是在家用服务器环境中,带宽的节约将成倍增长,因为无需反复从后端拉取资源。除了节省带宽,垃圾内容生成对服务器缓存策略也大有裨益。爬虫多样化且分布广,导致静态内容难以高效缓存。而毒药策略下,大量无效请求被转化为更易缓存的动态内容,释放了缓存空间,使真实用户访问体验更加流畅。更重要的是,这种方法抬高了爬虫方的成本。

爬虫必须花费额外资源来鉴别和过滤垃圾内容,若未能有效过滤,他们得到的训练数据质量将虚假且混乱,削减了模型的价值。这种攻防博弈将持续演变,增长爬虫的难度和成本,有利于内容原创者争取主动权。当前,市面上已有多种垃圾生成器工具,且各具特色,不同实例间存在差异,令爬虫更难制定统一作战策略。随着该方法的普及,爬虫开发者势必会尝试突破防线,但这需要更多研发投入,长远来看有助于站点维护方与爬虫之间的力量平衡。值得强调的是,采用“毒药”内容生成策略,站点依然可以选择性地封禁明显恶意的IP和ASN,结合行为分析、多因素识别等技术,进一步提高识别精度和防御效果。同时,继续优化和推进内容自主托管,远离大型科技巨头,增强站点的独立性和可控性,是抵御爬虫骚扰和保护原创内容的长效之计。

总的来说,“毒药”成本远低于传统流量防护方案,带来了极佳的性价比。它不仅节省了服务器带宽和硬件资源,还提升了正常用户访问体验,使站点在面对愈发复杂的网络环境时保持韧性。站点管理员和内容创作者应认真考量并积极实践这一方法,配合其他综合防控措施,形成完整的防御体系。未来,随着人工智能和自动化工具的快速发展,传统的网站流量管理方式正逐渐被革新。垃圾内容生成与伪装技术代表了新的方向,它们将帮助我们更聪明、更有效地应对爬虫浪潮,保护我们的数字资产,保障网络空间的健康生态。