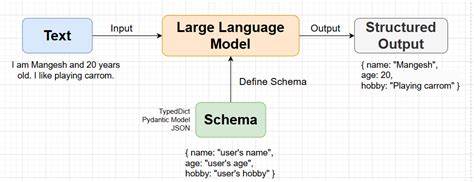

随着人工智能语言模型(LLM)应用领域的不断扩展,如何实现精准且结构化的输出成为众多开发者关注的重点。结构化输出不仅能提升信息的组织度,还让后续处理更加方便、高效。LangChain作为构建语言模型应用的重要框架,自身集成了便捷的结构化输出支持,而Llamafile作为可在本地运行的强大轻量级语言模型工具,则正逐步带来更多灵活的可能性。本文将带你深入了解如何借助LangChain与Llamafile实现结构化输出的全新方式,助力智能应用开发迈上新台阶。 首先,介绍一下LangChain中处理结构化输出的基石——with_structured_output方法。对于使用OpenAI等云端大模型的用户而言,LangChain提供了默认的结构化输出接口。

借助Pydantic进行数据模型定义,只需继承BaseModel,指定想要返回的字段和数据类型即可。此举让模型自动调整输出格式,极大地简化了开发流程。以AnswerWithJson为例,它包含answer和justification两个字段,分别代表回答内容和理由说明。通过简单的代码调用即可获得规范的JSON格式输出,无需额外教导LLM任何格式规则,极大提高开发效率。 然而,Llamafile现阶段尚未内置类似的with_structured_output方法。Llamafile本质上是结合了llama.cpp和Cosmopolitan Libc的跨架构可执行文件,可以让开发者在本地设备上轻松启动语言模型服务器,支持弱配置机器的运行。

使用Llama-3.2-1B-Instruct-Q8_0.llamafile在诸如较老款的MacBook Air等硬件上也能完成推理。尽管环境轻便,但原生缺少直接结构化输出支持,这就催生了借助LangChain中JsonOutputParser与PromptTemplate的创新方案。 JsonOutputParser是LangChain中专门负责解析JSON格式响应的组件,其特点在于可以结合Pydantic定义的结构体来自动校验和转换生成的JSON数据。借助这一工具,开发者无需花费大量精力构造复杂的正则表达式或手写解析逻辑,只需定义所需的返回字段、类型及注释,便能稳定提取结构化信息。为了让Llamafile返回符合预期的JSON数据,模板设计同样关键。 利用PromptTemplate,我们可以制定专门的提示语,要求模型在回答问题时,同时附带可信度、相关话题以及后续探讨问题等多维度信息。

模板中灵活注入JsonOutputParser生成的格式说明,可以显著强化模型在生成阶段对约定的JSON结构的遵守程度,从而获得高质量的规范输出。 完成PromptTemplate定义后,将提示语、语言模型实例以及JSON解析器通过函数组合符“|”串联成链式调用,形成一条统一的调用流水线。这条流水线能够连续处理用户输入,调用本地模型推理,再由解析器完成数据结构验证和转换,最终输出符合预期结构的答案。通过异常捕获机制,如果格式验证失败也能优雅fallback,确保用户始终获得有效输出。 此外,利用定义好的数据结构,还可以编写专属的展示函数,将那些可能嵌套的多维信息以易读且富有层次的格式呈现给用户。例如,将回答正文、置信度等级、相关主题、后续提问以清晰分区的方式展现,更加便于理解和后续使用。

本地部署的Llamafile虽然不具备云端服务的高算力优势,但通过合理设计对接LangChain的机制,仍能发挥重要作用。尤其对于隐私要求高、网络条件有限、或有特定算力限制的场景,Llamafile提供了优秀的替代方案。结构化输出的实现则使其数据变得标准化,利于后续分析、存储和复用。 总结来看,LangChain与Llamafile的结合实现了结构化输出的完整闭环。借助Pydantic定义数据模型的强类型特性,JsonOutputParser保证了输出数据的安全与准确。PromptTemplate强化了模型生成的规范性。

整体链条灵活兼顾了本地运行的轻量需求和输出结构的严谨要求,为智能应用的实现铺平了道路。 未来,随着Llamafile功能的不断完善与优化,预计会逐步原生支持更多结构化输出特性,为开发者带来更加便捷的交互体验。与此同时,LangChain也将持续深化对本地和云端不同模型的兼容和适配能力,为人工智能技术的普及和落地提供坚实后盾。无论是技术入门者还是资深专家,都可以借助这套方案轻松构建个性化、规范化的智能问答与信息提取系统。 随着结构化输出技术的成熟,人工智能应用的边界也将被进一步拓宽。无论是客服机器人、知识检索系统,还是智能助理,准确且丰富的结构化数据都能极大提升交互质量,满足多样化需求。

选择合适的工具与方法,结合LangChain与Llamafile的优势,实现本地高效、可控的语言模型服务,正成为越来越多开发者的理想方案。期待更多创新的方案涌现,推动我们迈向更加智能的未来。