随着人工智能技术的不断进步,特别是像ChatGPT这样的强大语言模型逐步进入软件开发领域,越来越多的开发者开始使用AI辅助生成代码。虽然这能显著提高开发效率,处理重复性工作,但随之而来的一个重大挑战便是如何识别这类由AI生成代码的特殊特征及其潜在风险。在代码审查过程中,资深测试工程师和开发者们发现,AI生成的代码往往表现出一系列独特的模式和问题,这使得识别和评估这类代码变得远比想象中复杂。首先,从代码表面特征来看,AI生成代码通常拥有极为“完美”的结构,变量命名极致规范化且过于冗长,注释丰富且具备文档式风格,代码抽象层级明显增多,却未必符合项目实际需求。例如,常见的模式是在函数命名中出现详尽而复杂的名称,如handleUserAccessRequest或processResponseMessageFully,这类命名虽符合语法规范,但显得冗长且不够简洁。这种“过度完美”反而成为判断代码是否出自AI之手的线索之一。

其次,注释方面,AI生成的注释往往无处不在,即使在非常简单或显然无需注释的代码段也会添加注释,且语气严谨正式,显得机械且缺少人性的灵活度。这种情况容易让评审者误以为代码足够周详和专业,但实际上存在潜在逻辑缺陷。再者,AI倾向于使用大量的辅助类,如Helper、Utils、Manager和Handler等类名频繁出现,这些层层包裹的抽象有时并非真正解决实际需求,反而造成了代码臃肿和可读性降低的问题。更令人担忧的是,测试代码中也存在明显的不足。AI生成的自动化测试常常仅仅局限于检查基础HTTP状态码,缺乏对业务逻辑的深入验证,未涵盖边界条件和负面测试场景。由于AI本身无法完全理解特定业务领域的复杂规则,它生成的测试代码往往忽视了关键的失败路径,导致测试效果大打折扣。

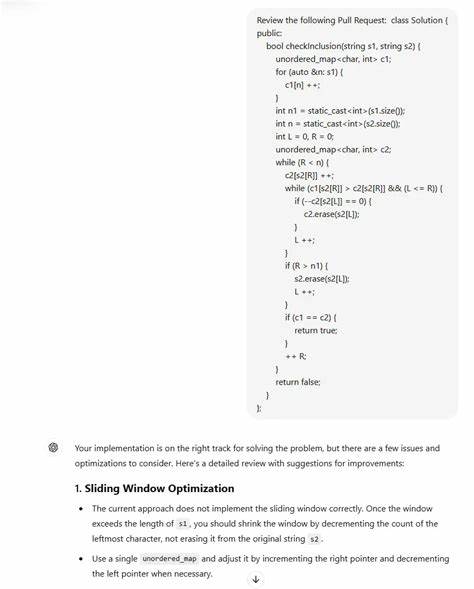

一个典型案例是某团队中QA人员提交的API测试PR,虽然结构干净整齐,瞬间通过所有测试用例,但却忽略了返回信息中重要的错误提示字符串,只凭200状态码断定成功,这显然违背了实际业务逻辑。面对如此问题,经验丰富的开发者和测试工程师通常会更加谨慎地对待貌似“完美”的PR,而不是直接接受。审查时需要仔细分辨代码中是否存在实质性的业务逻辑处理,而不仅仅是表面的包装。问自己这段try-catch是否真的有意义,变量命名是否过于繁复,是否存在不必要的抽象层。此外,还应特别关注代码中是否覆盖了关键的断言,是否包含了对异常情况和边界条件的充分考虑。整体而言,AI虽然能够快速生成代码样板,提高开发效率,协助解决重复性工作,但它不足以完全代替开发者的业务判断和逻辑推理。

AI生成的代码往往像一份初稿,缺乏人为的细致打磨和对细节的深刻理解。因此,团队在使用AI辅助编写代码时,必须将人工智能视作帮手,而非最终作者。代码审查过程依然不可缺失,高度依赖具备深厚业务理解能力的人工审核。特别是在深夜遇到生产问题时,AI生成的代码不能自动帮你调试和修复,那仍需依靠开发者的经验和智慧解决。对于那些推出不仅自己写代码,还自主运行测试、修复bug甚至自动批准PR的AI工具,如Cursor AI,团队更需要警醒其可能带来的质量风险。若没有恰当的人机协作机制,代码库中的AI标签难以辨认,隐患可能被埋藏其中,给团队带来不可预见的后果。

总结来看,鉴别ChatGPT生成代码并非单靠简单规则即可实现,而是一门结合代码风格分析、业务理解及深刻测试洞察的综合技术。开发团队应建立系统化的评审流程和明确的质量标准,警惕“看似完美”的代码背后的潜在误区。只有将人工智慧与AI生成代码优势结合,团队才能既享受技术带来的效率红利,又保证软件产品的稳定和可靠。未来随着AI技术的进一步发展,识别和管理AI生成代码的技术也将不断演进,开发者应保持开放且批判的心态,始终把控代码质量与业务价值为核心,推动软件工程持续向前发展。