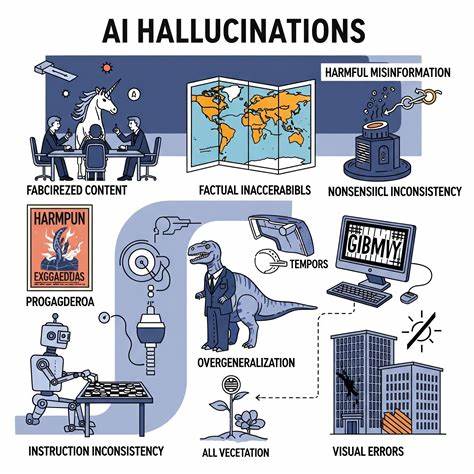

随着人工智能技术的飞速发展,尤其是在图像识别和自然语言处理领域的进步,基于AI的图像文本生成系统被广泛应用于许多实际场景,从自动描述图片内容,到辅助视觉障碍人士,乃至推动创意产业的发展。然而,这些系统并非完美无缺,其中一种被俗称为"幻觉"(hallucination)的现象仍然频繁出现,给用户带来了信任危机和实际困扰。"幻觉"指的是人工智能在生成与输入图像无关甚至完全错误的文本描述时,表现得异常自信,仿佛其输出的内容是准确无误的。这种持续且自信的错误输出在机器学习领域被视为一大挑战,严重影响了AI技术的可信度和广泛应用。首先,理解AI"幻觉"的成因非常关键。图像文本生成大多依赖于深度学习架构,将视觉特征与语言模型进行融合。

然而,训练数据中的偏差和不足,模型对于上下文的误判,以及语言模型本身对表达连贯性的追求,都会导致系统在缺乏准确视觉信息的情况下"编造"细节。这种现象就如同人类大脑在记忆空缺时自行填补信息,但AI的填补往往缺乏客观依据,因此错误更甚。举例来说,一幅简单的街景图片实际上只包含建筑和行人,但系统可能会自信地描述图中隐藏着狗、汽车甚至特定人物。这种不匹配不仅误导用户,还可能导致自动化判定和决策中的严重错误。在可预见的未来,人们对AI系统的依赖程度只会增加,从自动驾驶、医疗图像分析到社交媒体内容审核,图像文本生成技术都扮演着重要角色。因此,解决"幻觉"问题成为科技界迫切需要攻克的难题。

当前研究主要从提升训练数据质量、多模态融合精度及模型透明度等方面入手。增强训练数据的多样性和真实性有助于减少模型产生错误关联的可能性。同时,优化视觉信息与语言生成的结合,使模型能更准确地"感知"图像内容,从而避免虚构描述。此外,正在开展的模型解释性研究,试图让AI系统能够"说明"其输出依据,增强用户理解和信任,避免盲目信赖错误信息。尽管如此,彻底根除幻觉现象仍然充满挑战。部分原因在于,模型训练过程中始终存在信息缺失和不确定性,令其在面对复杂或模糊场景时难以保证完全正确。

另一个难题在于语言生成模型往往追求流畅、自然的表达,即便信息有误,也倾向于以坚定语气输出,给人以"知识渊博"的假象。这种高度自信的错误信息不仅令专业用户难以察觉,还可能被恶意利用,制造虚假内容和误导公众。为此,业界呼吁广泛采用多模态验证机制,即结合多源数据交叉比对,提高图像文本生成的准确率。强化模型的置信度评估功能,能够在发现潜在错误时发出警示,防止错误信息被直接用于决策。此外,用户教育和界面设计同样重要,应提升用户对AI输出结果的理解能力,避免盲目接受所有生成内容。未来,融合知识图谱和符号推理的混合智能方法,有望为幻觉现象提供更有效的解决方案。

通过结合结构化知识和深度学习的优势,AI系统能够更加理性地审视视觉信息与文本之间的关系,减少无根据的猜测。与此同时,持续推动开放数据共享和跨领域合作,也是提升整体技术水平的重要途径。总的来说,虽然图像文本生成中的AI幻觉问题尚未被完全克服,但这并不意味着人工智能技术的失败,而是表明目前技术仍处于不断完善和演进阶段。理解其背后机制,有助于我们更理性地应用AI,避免因盲目信任造成的不良后果。未来,伴随算法优化、数据改善及多元验证手段普及,AI在视觉理解与语言生成领域将迈向更高的准确性和可信度,为社会创造更大价值。 。