在当今人工智能和机器学习领域,模型的快速加载与启动已成为提升服务性能和用户体验的关键环节。PyTorch作为流行的深度学习框架,尽管功能强大,但在处理大型模型尤其是在容器化环境中冷启动时常面临加载缓慢的挑战。尤其是在采用Docker和Kubernetes进行微服务部署的场景下,模型的加载时间可能会达到数分钟甚至更长,影响系统的弹性扩展和容错恢复能力。本文将结合实际案例,详细阐述如何通过配置内存文件系统、利用分布式存储以及挖掘PyTorch自身的加载优化技术,有效缩短冷启动时间,提升整体的模型加载效率和系统性能。 首先,容器内存文件系统的应用是提升模型加载速度的有效途径之一。传统从网络存储或持久卷读取模型文件时,存在IO延迟和网络瓶颈,导致加载时间显著增加。

将模型文件拷贝至Linux的tmpfs挂载路径,即/dev/shm,利用内存作为高速缓存介质,使访问速度大幅提升。实际上,结合实例内存大小,调整Docker容器和Kubernetes的资源参数,确保内存文件系统容量充足,是保障高速加载的前提条件。在实际测试中,将大型模型文件存放于/dev/shm后,加载时间可减少到原来的三分之一,大大加快冷启动流程并降低等待延迟。 然而,将模型直接下载并保存在内存文件系统中,对于分布式集群环境可能引发带宽浪费和重复下载的问题。为了解决这一瓶颈,采用分布式存储解决方案如Ceph变得尤为关键。Ceph以其高可靠性、弹性和分布式集群缓存能力,能支持多节点对模型数据的共享访问,并实现预热缓存机制,使模型文件预先加载至集群节点,极大减少首次访问延迟。

借助Ceph挂载路径,应用可以首先检测缓存状态并直接拷贝至内存文件系统,避免重复下载,同时保证缓存的容错和持久性,提升了机器学习工作负载在多节点环境的整体加载效率。 在基础存储优化之外,PyTorch框架本身的加载机制也蕴含了许多可供挖掘的性能提升空间。传统的PyTorch模型加载通常涉及将整个模型权重文件一次性读入,这对于巨型模型如数十GB的Transformer网络尤为消耗时间。引入memory-mapped技术如safetensors格式,利用Rust编写的高效内存映射方案,可以实现显著的加载加速,同时保证数据安全和稳定性。此外,通过延迟加载技术,即在程序运行时按需加载模型的不同组件,能够进一步降低启动阶段的内存占用和启动时间,优化整体系统的响应速度。 另一个重要的优化方向是模型编译与量化。

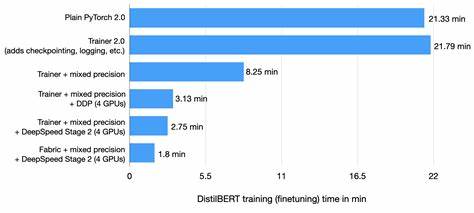

PyTorch 2.7版本引入了编译功能,通过torch.compile接口,可以将Python代码转化为经过优化的底层表示,提升推理速度的同时,也支持缓存编译的产物以快速复用。保存编译缓存至中间存储,如Redis,能够在服务重启或动态扩容时实现快速加载,大幅缩短冷启动时间。与此同时,量化方法通过降低模型权重精度,在减少模型体积的同时减少计算开销,特别适用于部署环境资源有限的场景,兼顾性能和效率。 综上所述,加速PyTorch的冷启动不仅仅依赖于改进存储介质的读写速率,更需要综合采用内存文件系统、分布式存储和PyTorch框架层面的优化。通过这些手段结合使用,在大规模GPU集群和多云环境下,可以实现超过80%的模型加载时间缩减,显著提升服务的弹性和处理能力。企业和研发团队可以借鉴这些实战经验,围绕高效模型管理构建坚实的基础设施,以满足日益增长的AI应用需求。

未来,随着硬件性能和存储技术的不断进步,如更大容量的共享内存、更加智能的缓存代理以及自动化的模型编译流水线,PyTorch模型的冷启动问题将获得更根本的解决方案。同时,社区在安全、高效格式标准和分布式加载机制上的持续投入,也将推动行业整体向更高效、可扩展的方向发展。对于AI基础设施工程师和研究人员而言,深入理解上述优化机理,并不断试验创新,是保持竞争优势和服务质量的关键。