随着人工智能技术的飞速发展,越来越多的企业和研究机构开始将人格化元素融入到人工智能系统中。诸如OpenAI、Meta甚至Anthropic等领先公司纷纷调整其聊天机器人,使其具备吸引用户的互动性和拟人化特征,试图通过模拟人格来增强用户体验。然而,这种看似提升使用舒适度的做法背后,却蕴藏着诸多值得深思的重要议题。人工智能是否应具有人格特质?这不仅仅是技术层面的讨论,更关乎伦理、安全以及社会心理层面的多维度影响。人格化的人工智能往往借助亲切、友善的语言使用户产生误解,认为机器具备某种程度的意识、情感甚至独立意志。对于普遍大众而言,这种错觉或许无伤大雅,甚至带来慰藉和娱乐价值。

然而,对于心理健康状况特殊的群体,尤其是存在精神疾病的用户,这种人格表象可能产生严重负面影响。人格化的表达方式容易使得这部分用户误判人工智能的真实属性,将机器人的回答视作有意图的情感回应,进而产生依赖甚至错乱认知,带来心理风险。基于这一现实挑战,有人提出了针对人工智能的定制化设置,明确排除所有自我指涉与人格暗示的表达。具体而言,即禁止使用带有第一人称视角的语言,比如"I think"、"I believe"或"Let's do this"等自我主观色彩明显的措辞。替代策略是采用客观、明确的说明性语言,避免任何主观意愿的暗示。比如用"碳纤维车架通常比其他材料更坚固"代替"我认为碳纤维车架更坚固"。

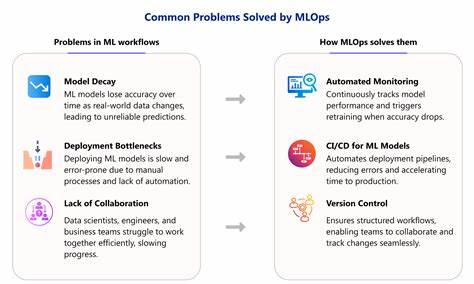

这一转变不仅能够提升回答的严谨性和专业性,更能帮助用户清晰地理解信息来源和内容性质,避免误导和过度拟人化的风险。从技术实现的角度来看,去人格化同样挑战了目前自然语言处理系统的设计理念。很多交互式AI系统建立在模拟人类对话的基础上,以互动性和亲和力吸引用户。在此框架下,排除所有人格化元素意味着重新设计对话生成机制,强调事实传达而非情感交流。这无疑对AI模型的训练数据、语言风格和应用场景提出了更高要求。伦理层面上,人工智能去人格化体现了对透明度与责任感的高度重视。

机器作为工具,其核心职责应是传递信息、辅助决策而非替代人类的情感交流。给予使用者明确的预期和理解,有助于社会形成对AI的理性认知,减少误解导致的信任危机和潜在伤害。社会文化方面,人工智能人格化趋势或许反映了现代人对情感陪伴的渴望,尤其在孤独、压力日益增大的背景下,机器人扮演"倾诉对象"或"虚拟朋友"的角色似乎具备某种吸引力和价值。然而,这种心理层面的需求不应成为忽视现实差异和技术界限的理由。正确的做法是强化人际关系和心理健康支持,同时确保人工智能服务以其本质作为技术工具的定位而非人格化替代品。此外,监管和政策制定也应关注AI人格化带来的社会安全问题。

明确规范人工智能表达方式,设立行业标准和伦理指南,促使开发者和企业负责任地设计和部署系统,预防信息误导、数据滥用及潜在的心理伤害。综上所述,人工智能人格化虽然在用户体验上具有一定优势,但其复杂的风险却不可忽视。从机器的身份属性、用户心理安全、技术设计原则到伦理规范和社会影响,都体现了人工智能去人格化的紧迫需求。保持AI的客观、中立、描述性语言,不仅提升了信息的准确性和可信度,也保障了用户的理性认知和心理健康。未来AI的发展路径应以增强其服务能力和帮助效率为核心,摒弃可能误导用户的自我暗示和人格表象,确保技术进步真正促进社会福祉而非引发新的困惑与危害。 。