随着人工智能技术的迅速发展,特别是代理式人工智能(Agentic AI)与大型语言模型(LLM)的崛起,相关的安全风险也逐渐显现。当前,AI系统的攻防环境日益复杂,传统的安全防御方法难以有效应对不断演变的攻击手段。尤其是在工具调用环节,AI模型对外部工具的访问权限一旦被突破,便可能引发一系列连锁安全问题。由此,采用零信任(Zero Trust)原则构建工具调用安全边界,成为保障代理式AI安全的关键所在。代理式AI的工具调用通常涉及模型接收和执行外部指令,而这些指令往往是动态生成的,并基于用户输入及上下文信息进行扩展调整。然而,正是这种高度灵活性和开放性,使得模型极易遭受攻击者的恶意干扰,导致意图劫持、工具链攻击和上下文污染等严重安全事件。

意图劫持是指攻击者将恶意指令掺入输入,篡改AI实际执行的任务目标,导致系统偏离用户初衷。工具链攻击则体现为攻击者通过一个工具的漏洞,逐步扩展权限,形成层层递进的攻击态势。上下文污染则是针对对话状态或模型上下文进行恶意篡改,干扰模型对接下来步骤的正确判断。这些问题暴露出当前AI工具调用机制本质上的安全隐患。诸如模型客户端协议(MCP)等标准虽然规范了工具调用流程,但其本身并未严格界定控制平面与数据平面的安全边界,且默认信任调用流程中的各个环节,这种隐含信任为攻击者留下了可乘之机。目前大多数防护措施仍停留在黑名单过滤或提示工程(prompt engineering)阶段,这些手段往往被证明是容易绕过或不足以防止更高级攻击的。

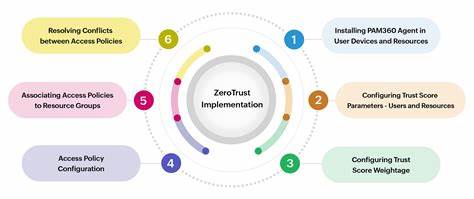

例如简单的屏蔽敏感词技术无法防止复杂的多步攻击流程,而仅依靠训练模型识别恶意指令的方法也因其概率性和局限性而难以提供安全保障。为解决这一问题,安全研究者提出重新设计安全边界的思路。关键在于认识到基于大型语言模型本身的安全防护难以落实,因为LLM天生被设计为遵从输入指令,无法选择性忽略恶意请求。借鉴互联网TLS加密认证的成功经验,提出通过零信任的加密身份认证和策略验证,将安全验证层直接引入工具调用环节,使工具本身成为最终的安全执行边界。零信任工具调用框架下,每一个参与实体 - - 无论是模型、工具、用户还是应用程序 - - 都赋予唯一的加密身份,通过数字签名来认证和校验操作的合法性。用户的意图会被策略化、签名化,工具收到调用请求时则需要验证签名和策略是否符合,确保仅允许在多层次安全策略合集许可范围内执行操作。

整个调用过程建立起不可篡改的链条,所有调用行为都留下可追溯的安全凭证,防止了伪造和欺骗。该方案还针对工具链调用中的安全复杂性做了细致设计。通过"认证工作流"(Authenticated Workflows)与"认证提示"(Authenticated Prompts)概念,将原本灵活多变、易被篡改的输入提示制订为基于策略绑定和深度限制的结构化内容。这样即便攻击者试图在提示中嵌入恶意信息,策略绑定机制也能将其限制在预先定义的权限范围内,并保持提示链的完整性和安全性。此类设计不仅提高了对供应链攻击(如提示内容传输篡改)的防护能力,也大幅度降低了数据驱动型攻击(例如恶意注入文档内容升级攻击)的风险。实践中,这项技术已逐步应用于主流AI平台的安全扩展中。

例如基于OpenAI及MCP协议实现的"安全OpenAI"和"安全MCP"项目,在工具调用层面引入零信任验证,成功阻断了多层复杂注入攻击,且对开发者透明,无需更改现有开发流程。相比传统依赖"训练+检测"的安全策略,这种架构性安全设计从根本上杜绝了模型行为自由意志对安全性的影响,使AI系统在任何情况下都"不可能"执行未经授权的操作。未来随着AI应用的多样化和深入,各类代理式AI系统对外部工具调用的需求只会持续增长。与此同时,由于攻击手段日益智能化,不断依赖强化模型检测和黑名单的旧安全模式将愈发难以适应。零信任工具调用策略作为一种全新的安全设计思路,不仅契合了分布式、动态交互的AI系统特点,更能够保证调用此类系统所产生的数据及操作在端到端均处于受控且可信的状态。为推广零信任工具调用体系实现真正普适的AI安全,行业需要加强底层协议标准制定,推动各大AI平台开放支持加密身份和策略验证功能。

此外,要持续优化用户体验,让零信任机制对开发者和终端用户"隐形",不增加使用复杂度,从而加速其主流落地。总之,面对不断扩大的AI安全风险,重塑工具调用的安全边界成为不可回避的命题。通过引入零信任原则,将工具层作为安全控制点,辅以加密身份和策略绑定,不仅有效抵御当前主流攻击,也为未来的AI安全挑战奠定坚实基础。在技术和标准的持续演进之下,我们有理由相信安全且可靠的代理式人工智能时代正在到来。 。